Beruflich Dokumente

Kultur Dokumente

Notas Convergencia

Hochgeladen von

Diego MorenoCopyright

Verfügbare Formate

Dieses Dokument teilen

Dokument teilen oder einbetten

Stufen Sie dieses Dokument als nützlich ein?

Sind diese Inhalte unangemessen?

Dieses Dokument meldenCopyright:

Verfügbare Formate

Notas Convergencia

Hochgeladen von

Diego MorenoCopyright:

Verfügbare Formate

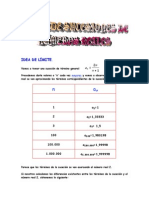

Captulo 1

Convergencia

1.1 Introduccion

En este captulo estudiaremos el comportamiento asintotico de sucesiones

de variables aleatorias, daremos distintas deniciones de convergencia y de-

mostraremos dos de los Teoremas mas importantes de la Teora de Probabil-

idad, de hecho los dos resultados que podramos decir le dieron vida a esta

area del conocimiento.

Antes de estudiar las distintos modos de convergencia, es importante

preguntarse de donde surgen estos resultados? cual es la motivacion para el

estudio del comportamiento en el lmite de sucesiones de variables aleatorias.

Desde la prehistoria de la Probabilidad, se ha deseado dar una inter-

pretaci on a la Probabilidad, intuitivamente, se consideraba que la probabil-

idad de un evento era algo as como un lmite de frecuencias relativas (de

hecho la escuela frecuentista la dene as), es decir si A es un evento

P[A]

n

A

n

donde n

A

es el n umero de veces que ha ocurrido el evento A en n ensayos

independientes del mismo experimento.

A esta propiedad se le llamo (como lo hemos ya mencionado en ??) Regu-

laridad Estadstica. A un cuando ya hemos visto que esta denicion frecuen-

tista de la Probabilidad no tiene sentido, sera importante saber si desde el

punto de vista del Modelo Axiomatico de la Probabilidad existe una Ley

emanada de sus axiomas que sea la contraparte teorica de la regularidad

estadstica.

1

2 CAP

ITULO 1. CONVERGENCIA

Esta Ley conocida como La Ley de los Grandes N umeros sera estudiada

en las Secciones 2 y 3 de este Captulo y esencialmente dice los siguiente:

Teorema 1.1 Ley de los Grandes N umeros. Sea (X

n

)

n1

una sucesion de

variables aleatorias independientes e identicamente distribuidas con esper-

anza . Entonces

n

k=1

X

k

n

, converge en alg un sentido a .

Este Teorema no solo nos dice que efectivamente existe una Ley emanada

de los axiomas sino que provee de lo que en Estadstica se conoce como un

estimador de . Deniremos y demostraremos esta propiedad para dos tipos

de convergencia, a saber, la convergencia casi segura y la convergencia en

probablidad.

Sin embargo, el hecho de que

n

k=1

X

k

n

,

en ocasiones no es suciente. Mas precisamente, por ejemplo, en un contexto

de inferencia sea (X

n

)

n1

una sucesion de variables aleatorias independientes

e identicamente distribuidas seg un F

0

con media desconocida.

Supongamos que para cada n 1, S

n

=

n

k=1

X

k

y supongamos que

queremos probar con la ayuda de

Sn

n

que > 5. La Ley de los Grandes

N umeros nos dice que este cociente es muy cercano a para n sucientemente

grande, as es que en primera instancia podramos pensar que no es tan

descabellado. Sin embargo, se quiere mas, es decir, se quiere dar un criterio

que nos diga algo en el siguiente sentido:

Rechace la Hipotesis de > 5 si

Sn

n

excede a un cierto n umero.

Si se conociera la distribucion de

Sn

n

se podra exhibir ese cierto n umero

que garantizara que este cociente lo excede solo con probabilidad (por

ejemplo, = 0.05).

Sin embargo, lo que ocurre es que no conocemos su distribucion, supong-

amos que alguien demostro que su distribucion converge a una distribuci on

conocida cuando n . Entonces se podra usar la distribucion lmite como

una aproximacion.

El Teorema de Lmite Central es en este sentido y dice lo siguiente:

1.2. CONVERGENCIA CASI SEGURA 3

Teorema 1.2 Sea (X

n

)

n1

una sucesion de variables aleatorias independi-

entes, identicamente distribuidas con media y varianza

2

, entonces

lim

n

P

_

S

n

n

n

x

_

= P[X x],

donde X es una variable aleatoria N(0, 1).

El lmite del Teorema anterior es un lmite de las funciones de distribucion

y se conoce como convergencia en distribucion.

En todo este Captulo denotaremos por S

n

=

n

k=1

X

k

.

1.2 Convergencia Casi segura

En toda esta seccion consideraremos (, F, P) un espacio de probabilidad

jo. Las sucesiones de variables aleatorias estaran denidas en este espacio.

Denicion 1.1 Convergencia Puntual. Una sucesion de variables aleatorias

(X

n

)

n1

se dice que converge en el punto si la sucesion de n umeros

reales (X

n

())

n1

converge.

Denicion 1.2 Conjunto de Convergencia. El conjunto de puntos

para los cuales la sucesion (X

n

())

n1

converge sera llamado el conjunto de

convergencia.

Sea (X

n

)

n1

una sucesion de variables aleatorias y C su conjunto de conver-

gencia. Consideremos la funcion X : R denida por:

X() =

_

lim

n

X

n

(), si C,

c, si C

c

.

(1.1) {variablelimite}

Para jo tal que X

n

() no converge a X(), entonces de la denicion

de convergencia de sucesiones de n umeros reales, existe > 0 tal que

|X

n

X| > , para una innidad de n

s.

Observese que para cada > 0

{ ||X

n

() X()| > , para una innidad de n

s}

=

n=1

_

l=n

{ | |X

l

() X()| > }

=

n=1

_

l=n

[ |X

l

X| > ] (Notacion). (1.2)

4 CAP

ITULO 1. CONVERGENCIA

Luego entonces, el complemento del conjunto de convergencia C estara dado

por:

C

c

=

_

k=1

_

n=1

_

l=n

_

|X

l

X| >

1

k

_

_

. (1.3) {conjuntoconvergencia}

Claramente el conjunto de convergencia es un evento y podemos concluir

entonces que la sucesion (X

n

)

n1

, converge a X sobre C.

Denicion 1.3 Convergencia Casi Segura. Una sucesion de variables aleato-

rias (X

n

)

n1

se dice que converge casi seguramente si su conjunto de conver-

gencia tiene probabilidad 1.

La convergencia casi segura la denotaremos por

X

n

c.s.

X

donde X es la variable aleatoria denida por la expresion (1.1).

Observese que:

X

n

c.s.

X, P[X

n

, no converge a X] = P[C

c

] = 0

Ejemplo 1.1 Consideremos el experimento de elegir un punto al azar en el

intervalo (0, 1). Para cada n 1, denimos

X

n

() =

1

n

[n],

donde [] denota la parte entera de .

Es claro que

lim

n

X

n

() = X() = , para toda .

Por lo tanto, X

n

c.s.

X.

Ejemplo 1.2 Sea (X

n

)

n1

una sucesion de variables aleatorias independi-

entes, identicamente distribuidas, con funcion de distribucion F. Supong-

amos que F(x) < 1 para toda x < x

0

, x

0

R . Para cada n 1 sea

X

(n)

denida por:

X

(n)

= max{X

1

, ..., X

n

}

Entonces

lim

n

X

(n)

= x

0

, casi seguramente

1.2. CONVERGENCIA CASI SEGURA 5

Para cada jo, la sucesion (X

(n)

())

n1

es una sucesion creciente. Por

lo tanto, si x

0

= , converge a un lmite nito si y solo si esta acotada. Sea

C = { | (X

(n)

())

n1

converge a un lmite nito}

= { | (X

(n)

())

n1

, esta acotada}.

Demostraremos que

P[C] = 0.

Observese que

C =

_

M=1

[X

(n)

< M, n 1],

por lo tanto, es suciente probar que para cada M IN,

P[X

(n)

< M, n 1] = 0

As, para toda k 1 y puesto que las variables aleatorias X

n

, n 1 son

independientes

P[X

(n)

< M, n 1] P[X

(n)

< M, 1 n k] = F

k

(M).

Por hipotesis F(x) < 1 para toda x R, lo que implica que F

k

(M) 0

cuando k . Por lo tanto,

P[X

(n)

< M, n 1] = 0.

Si x

0

< , para cada la sucesion converge, ya que P[X

(n))

x

0

] =

1. y el lmite es menor o igual que x

0

. Para cada M < x

0

, sea

C

M

= { | lim

n

X

(n)

() M},

lim

n

X

(n)

() M, si y solo si X

(n)

< M, n 1.

Siguiendo la misma demostracion que en el caso anterior, tenemos que

P[C

M

] = 0, para toda M < x

0

,

por lo tanto el lmite es igual a x

0

.

2

6 CAP

ITULO 1. CONVERGENCIA

Ejemplo 1.3 Consideremos una sucesion innita de ensayos Bernoulli in-

dependientes con probabilidad p (< 1) de exito. Sea

X

n

() =

_

n, si los primeros n ensayos fueron fracaso,

k, si el primer exito ocurrio en el ensayo k, k n.

Entonces, X

n

c.s.

X, donde X es una variable aleatoria Geometrica con

parametro p.

Para cada la sucesion (X

n

())

n1

es no-decreciente, por lo tanto,

la sucesion no converge si y solo si tiende a innito. Probaremos que la

probabilidad del conjunto de las tales que la sucesion tiende a tiene

probabilidad cero:

P[lim

n

X

n

= ] = P

_

n1

[X

n

= n]

_

P[X

n

= n] = (1 p)

n1

0.

Es claro de la denicion que si (X

n

())

n1

converge, esto implica que es

constante a partir de una cierta k 1, donde k es el ensayo en el que ocurre

el primer exito. Por lo tanto la variable aleatoria lmite es una variable

aleatoria Geometrica con parametro p.

2

Finalmente demostraremos La Ley de los Grandes N umeros mencionada en

la Introduccion.

Teorema 1.3 Ley Fuerte de Los Grandes N umeros. (Kolmogorov). Sea

(X

n

)

n1

una sucesion de variables aleatorias independientes e identicamente

distribuidas. Entonces

S

n

n

converge casi seguramente,

si y solo si las variables aleatorias X

n

tienen esperanza nita y

S

n

n

c.s.

E[X

1

],

donde S

n

=

n

k=1

X

k

.

1.2. CONVERGENCIA CASI SEGURA 7

La demostracion de la Ley Fuerte de los Grandes N umeros es complicada

y esta mas alla de los conocimientos del nivel de este libro, por lo que nos

contentaremos con demostrar una Ley Fuerte diferente cuya demostracion es

muy simple.

El resultado que probaremos a un cuando impone condiciones mas fuertes

sobre la existencia de los momentos de las variables aleatorias, no requiere

que estas sean identicamente distribuidas. Recuerdese que de la expresion

1.3 demostrar la convergencia casi segura es equivalente a probar que la

probabilidad del complemento del conjunto de convergencia C es igual a cero.

El Lema siguiente conocido como el Lema de Borel-Cantelli sera fundamental

en la demostracion.

Lema 1.1 Lema de Borel-Cantelli. Sea (A

n

)

n1

una sucesion de eventos tal

que

n1

P[A

n

] < . Entonces

P[A

n

, ocurra para una innidad de n

s] = P[

n=1

_

l=n

A

l

] = 0.

Demostracion

De la denicion se tiene que para toda n 1,

P

_

n=1

_

l=n

A

l

_

P

_

_

l=n

A

l

_

l=n

P[A

l

]

Por hip otesis

n=1

P[A

n

] < , por lo tanto,

l=n

P[A

l

] 0 cuando n

, de donde P[

n=1

l=n

A

l

] = 0.

2

Teorema 1.4 Una Ley Fuerte de los Grandes N umeros. Sea (X

n

)

n1

una

sucesion de variables aleatorias independientes, con cuarto momento nito.

Supongamos que para toda n 1, E[X

n

] = , V ar(X

n

) =

2

y E[(X

n

)

4

] = . Entonces

S

n

n

c.s.

,

donde S

n

=

n

k=1

X

k

.

Demostracion

8 CAP

ITULO 1. CONVERGENCIA

De la expresion 1.3, es suciente demostrar que para toda > 0,

P

_

S

n

n

> , o.i.

_

= 0.

Por el Lema anterior basta probar que

n=1

P

_

S

n

n

>

_

< .

De la Desigualdad de Bienayme-Chebyshev y puesto que las variables aleato-

rias X

k

son independientes, con varianza y cuartos momentos centrales co-

munes se tiene

P

_

S

n

n

>

_

= P

_

k=1

(X

k

> n

_

1

(n)

4

E[(

n

k=1

(X

k

))

4

]

=

1

(n)

4

[nE[(X

1

)

4

] +n(n 1)(E[(X

1

)

2

])

2

K

n

2

,

donde K es una constante. Ya que

n1

1

n

2

=

2

6

, se obtiene que

n=1

P

_

S

n

n

>

_

< .

2

Una consecuencia de la Ley de los Grandes N umeros es la aproximacion de

la distribucion de una variable aleatoria por lo que llamaremos el Proceso

Emprico y que denimos a continuacion:

Sea (X

n

)

n1

una sucesion de v.a.i.i.d. Para cada x R y n N denimos

11

[Xnx]

=

_

1, si X

n

x,

0, si X

n

> x,

y

N

n

(x) =

S

n

(x)

n

=

1

n

n

i=1

11

[Xnx]

.

1.3. CONVERGENCIA EN PROBABILIDAD 9

A Las variables aleatorias N

n

(x), x R se le conoce como el Proceso

Emprico.

Corolario 1.1 Sea (X

n

)

n1

una sucesion de v.a.i.i.d. con funcion de dis-

tribucion F. Entonces, para cada x R

N

n

(x)

c.s.

F(x), cuando n

La demostracion se sigue inmediatamente de la Ley Fuerte de los Grandes

N umeros. De hecho se tiene un resultado mas fuerte que no demostraremos:

Teorema 1.5 Teorema de Glivenko-Cantelli. Sea (X

n

)

n1

una sucesion de

v.a.i.i., con distribucion F. entonces

sup

xR

|N

n

(x) F(x)|

c.s.

0, cuando n .

1.3 Convergencia en Probabilidad

Un tipo de convergencia mas debil que la convergencia casi segura es la lla-

mada convergencia en probabilidad. Antes de dar la denicion consideremos

el siguiente ejemplo que es muy ilustrativo.

{ejeconvprob}

Ejemplo 1.4 Consideremos nuevamente el experimento de elegir un punto

al azar en el intervalo (0, 1) y sea (X

nk

)

n1,0kn1

una sucesion de variables

aleatorias denidas de la de siguiente manera:

X

nk

() =

_

1,

k

n

<

k+1

n

, si 0 k n 1,

0, en otro caso.

Esto es, tenemos el siguiente arreglo:

X

10

X

20

, X

21

X

30

, X

31

, X

32

.

.

.

.

.

.

.

.

.

X

n0

, X

n1

, X

n2

, , X

nn1

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

10 CAP

ITULO 1. CONVERGENCIA

GRAFICAS

Es posible escribir el arreglo como una sola sucesion, (Y

m

)

m1

de la sigu-

iente manera:

Y

n(n1)/2+k+1

= X

nk

,

Observese que para cada (0, 1) hay una innidad de parejas (n, k) para

las que X

nk

= 0 y tambien una innidad para las que X

nk

= 1. Por lo

tanto, para toda (0, 1) la sucesion (Y

m

())

m1

no converge, es decir, su

conjunto de convergencia tiene probabilidad cero.

Sin embargo, es claro que para n sucientemente grande, las variables

aleatorias X

nk

son muy parecidas a la variable aleatoria X 0. De hecho

son iguales a cero excepto en un conjunto de probabilidad

1

n

, lo que sugiere

la siguiente denicion:

Denicion 1.4 Convergencia en Probabilidad. Una sucesion (X

n

)

n1

de

variables aleatorias se dice que converge en probabilidad a la variable aleatoria

X si para cada > 0 se satisface:

lim

n

P[|X

n

X| > ] = 0

La convergencia en probabilidad sera denotada por X

n

P

X.

Claramente la sucesion de variables aleatorias (Y

m

)

m1

del Ejemplo 1.4 con-

verge en probabilidad a la variable aleatoria X 0.

A continuacion presentamos algunas de las Leyes Debiles de los Grandes

N umeros. El apellido Debiles se reere a la convergencia en probabilidad y

no casi segura que como hemos visto con el Ejemplo 1.4 es mas debil.

Teorema 1.6 Sea (X

n

)

n1

una sucesion de variables aleatorias, entonces

1. Ley Debil de los Grandes N umeros de Bernoulli. Si X

1

, X

2

, ...., X

n

, ...

son variables aleatorias independientes identicamente distribuidas, con

distribucion Bernoulli con parametro p, entonces

S

n

n

P

p.

2. Ley Debil de los Grandes N umeros. Si X

1

, ..., X

n

, ... son variables

aleatorias independientes identicamente distribuidas con E[X

1

] = ,

entonces

S

n

n

P

.

1.3. CONVERGENCIA EN PROBABILIDAD 11

3. Ley Debil de los Grandes N umeros de Poisson. Si X

1

, ..., X

n

, ... son

variables aleatorias independientes, y para cada i, X

i

tiene distribucion

Bernoulli con parametro p

i

, i 1, entonces

S

n

n

E

_

S

n

n

_

P

0.

4. Ley Debil de Chebyshev. Si X

1

, ..., X

n

, ... son variables aleatorias no

correlacionadas, es decir, Cov(X

i

, X

j

) = 0 para i = j, y V ar(X

i

)

M < para toda i 1, entonces

S

n

n

E

_

S

n

n

_

P

0.

5. Ley Debil de Markov. Si X

1

, ..., X

n

, ... son variables aleatorias con se-

gundo momento nito tales que:

V ar

_

S

n

n

_

0, Condicion de Markov,

Entonces

S

n

n

E

_

S

n

n

_

P

0.

Demostracion

De estas Leyes puede demostrarse facilmente que

(i) La Ley Debil de Markov es mas fuerte que la de Chebyshev y que la Ley

Debil.

(ii) La Ley Debil de Chebyshev es mas fuerte que la de Poisson.

(iii) La Ley Debil de Poisson es mas fuerte que la de Bernoulli.

(iv) La Ley Debil es mas fuerte que la de Bernoulli.

Luego entonces, es suciente demostrar la Ley de Markov, la cual se sigue de

la Desigualdad de Bienayme-Chebyshev:

Dada > 0, se tiene:

P

_

S

n

n

E

_

S

n

n

_

>

_

V ar

_

Sn

n

_

2

.

12 CAP

ITULO 1. CONVERGENCIA

La Condicion de Markov implica as la convergencia en probabilidad.

2

Como hemos visto en el Ejemplo 1.4 la convergencia en probabilidad no

implica la convergencia casi segura, sin embargo, el recproco si es valido:

Teorema 1.7 Sea (X

n

)

n1

una sucesion de variables aleatorias. Si X

n

c.s.

X

entonces X

n

P

X.

Demostracion

Supongamos que X

n

c.s.

X y sea C su conjunto de convergencia. Entonces

para n 1 y > 0:

[|X

n

X| > ]

_

kn

[|X

k

X| > ].

Sea

B() =

n1

_

k=n

[|X

k

X| < ],

entonces B() C

c

, por lo tanto P[B()] = 0. Por otro lado,

0 = P[B()] = lim

n

P[

_

kn

[|X

k

X| > ],

de donde se obtiene el resultado.

2

Volviendo al Ejemplo 1.4 se puede observar que si bien el conjunto de conver-

gencia de la sucesion tiene probabilidad 0 se puede considerar una subsucesi on

que converge casi seguramente a la variable aleatoria X = 0, por ejemplo la

subsucesion (X

n1

)

n1

. Esto no es casual, de hecho es un resultado general,

que enunciamos a continuacion pero que omitimos su demostracion.

Teorema 1.8 Sea (X

n

)

n1

una sucesion de variables aleatorias. Si X

n

P

X

entonces existe una subsucesion (X

n

k

)

n

k

1

tal que X

n

k

c.s.

X.

1.4. CONVERGENCIA EN DISTRIBUCI

ON 13

1.4 Convergencia en Distribucion

En las deniciones de convergencia casi segura y en probabilidad, se considero

un espacio de probabilidad (, F, P) jo en donde estaban denidas todas

las variables aleatorias. La convergencia en distribucion que se denira a

continuacion es un concepto que se reere no a una propiedad de convergencia

de las variables aleatorias sino de las funciones de distribucion. As, las

variables aleatorias en consideracion en esta seccion pueden estar denidas

en distintos espacios de probabilidad.

Denicion 1.5 Sea (X

n

)

n1

una sucesion de variables aleatorias y (F

n

)

n1

la sucesion correspondiente de funciones de distribucion. Diremos que X

n

converge en distribucion a (la variable aleatoria) X con funcion de dis-

tribucion F, si

lim

n

F

n

(x) = F(x),

para todo x R, punto de continuidad de F. La convergencia en distribucion

la denotaremos X

n

D

X (o F

n

D

F).

Ejemplo 1.5 Para cada n 1 sea X

n

una variable aleatoria uniforme sobre

el intervalo (

1

n

,

1

n

). Entonces X

n

D

X, donde P[X = 0] = 1.

La funcion de distribucion F

n

de X

n

esta dada por

F

n

(x) =

_

_

_

0, si x

1

n

,

1

2

(1 +nx), si

1

n

< x <

1

n

,

1, si x

1

n

.

Cuando n la sucesion de funciones F

n

tiende a G, donde

G(x) =

_

_

_

0, si x < 0,

1

2

, si x = 0,

1, si x > 0.

La funcion G no es una funcion de distribucion ya que no es continua por la

derecha. Consideremos la funcion de distribucion F de la variable aleatoria

X que es la constante igual a 0, es decir,

F(x) =

_

0, si x < 0,

1, si x 0,

14 CAP

ITULO 1. CONVERGENCIA

Claramente, de la denicion de convergencia en distribucion X

n

D

X, pues

F

n

(x) converge a F(x) para toda x = 0 y el 0 no es un punto de continuidad

de la funcion F.

Observese que en este ejemplo las variables aleatorias X

n

pueden estar

denidas en distintos espacios de probabilidad.

{constanten}

Ejemplo 1.6 Para cada n 1 sea X

n

la variable aleatoria constante igual

a n, es decir, P[X

n

= n] = 1. La funcion de distribucion F

n

de X

n

esta dada

por:

F

n

(x) = 11

[n,)

(x),

Luego, entonces

lim

n

F

n

(x) = 0, para toda x R.

Sin embargo, la funcion identicamente cero no es una funcion de distribucion.

Esto es, a un cuando para toda x R el lim

n

F

n

(x) existe, el lmite no

es funcion de distribucion, por lo tanto la sucesion (X

n

)

n1

no converge en

distribucion.

Ejemplo 1.7 Sea X una variable aleatoria N(0, 1). Para cada n 1 sea

X

n

la variable aleatoria denida por:

X

n

() = (1)

n

X().

La distribucion de X

n

es tambien N(0, 1), por lo tanto, X

n

D

X.

De este ejemplo se puede concluir que a un cuando las variables aleatorias

esten denidas en el mismo espacio de probabilidad, la convergencia en dis-

tribucion no nos da informacion acerca de la convergencia de las variables

aleatorias, pues en este caso,

|X

n

X| =

_

2X, si n es par,

0, si n es impar.

Ejemplo 1.8 Sea (X

n

)

n1

una sucesion de variables aleatorias independi-

entes e identicamente distribuidas Exponenciales con parametro > 0. Sea

M

n

= max {X

1

, ..., X

n

} y

Z

n

= M

n

log n,

1.4. CONVERGENCIA EN DISTRIBUCI

ON 15

enotonces, para cada x R y n tal que x + log n > 0

F

n

(x) = P[Z

n

x] = P[M

n

1

(x + log n)]

= (1 exp(

1

(x + log n))

n

=

_

1

e

x

n

_

n

.

Por lo tanto,

lim

n

F

n

(x) = exp(e

x

).

La funcion

F(x) = exp(e

x

),

es una funcion de distribucion llamada la distribucion Gumbel. Es decir

Z

n

D

Z, donde Z es una variables aleatoria con distribucion Gumbel.

Ejemplo 1.9 Sea (X

n

)

n1

una sucesion de variables aleatorias uniformes

en (0, 1). Sea M

n

= max {X

1

, ..., X

n

} y

Z

n

= n(M

n

1).

Claramente las variables aleatorias Z

n

toman valores en (, 0). Entonces,

para cada x > 0,

P[Z

n

x] = 1, para toda n 1.

Para x < 0 y n tal que

x

n

+ 1 (0, 1), tenemos

F

n

(x) = P[Z

n

x] = P[M

n

x

n

+ 1]

=

_

x

n

+ 1

_

n

.

De donde

lim

n

F

n

(x) = exp((x)), si x < 0.

La funcion

F(x) =

_

1, si x > 0,

exp((x)), si x 0,

16 CAP

ITULO 1. CONVERGENCIA

es una funcion de distribucion llamada Distribucion Weibull con parametro

= 1, es decir

Z

n

D

Z,

donde Z es una variable aleatoria con distribucion Weibull con parametro

= 1.

En general, es bastante difcil demostrar la convergencia en distribucion pues

la forma de estas funciones en ocasiones (como por ejemplo, en el caso Gaus-

siano) no es cerrada, es decir, se expresa en terminos de una integral. No solo

eso sino que como veremos mas adelante en lo que llamaremos el Teorema de

Lmite Central, los resultados importantes de convergencia en distribuci on

se reeren no a sucesiones particulares de variables aleatorias, sino a suce-

siones de variables aleatorias independientes e identicamente distribuidas con

la unica condicion adicional de la existencia de segundo momento nito.

Por otro lado, recuerdese que la funcion caracterstica caracteriza a la

funcion de distribucion, por lo que intuitivamente se podra esperar alguna

relacion entre la convergencia de las funciones caractersticas de una sucesi on

de variables aleatorias y su convergencia en distribucion. El siguiente Teo-

rema (de Levy-Cramer o Teorema de Continuidad de Levy) es en este sentido.

Teorema 1.9 Teorema de Levy-Cramer o de Continuidad de Levy. Una

sucesion de variables aleatorias (X

n

)

n1

converge en distribucion a la vari-

able aleatoria X si y solo para toda t R la sucesion (

n

(t))

n1

de sus

corespondientes funciones caractersticas converge a la funcion caracterstica

(t) de X.

Observese que en el Ejemplo 1.6 la funcion caracterstica de X

n

esta dada

por:

n

(t) = e

itn

,

y lim

n

e

itn

no existe, pues e

itn

= cos(tn) + isen(tn), por lo que tanto su

parte real como imaginaria oscilan cuando n .

Teorema 1.10 Teorema de Lmite Central (Clasico). Sea (X

n

)

n1

una sucesion

de variables aleatorias independientes identicamene distribuidas con esper-

anza y varianza

2

. Entonces

S

n

n

n

D

X,

donde X es una variable aleatoria N(0, 1).

1.4. CONVERGENCIA EN DISTRIBUCI

ON 17

Demostracion

Por el Teorema de Levy-Cramer es suciente demostrar que las funciones

caractersticas convergen. Para cada n 1, sea Y

n

=

Xn

, entonces

S

n

n

n

=

1

n

n

j=1

Y

j

.

Las variables aleatorias Y

1

, Y

2

, ... son independientes e identicamente dis-

tribuidas con media cero y varianza uno. Luego entonces

n

(t) = E

_

exp

_

it

S

n

n

n

__

= E

_

exp

_

it

1

n

n

j=1

Y

j

__

=

n

j=1

E

_

exp

_

it

1

n

Y

j

__

_

Y

1

_

t

n

__

n

.

donde

Y

1

es la funcion caracterstica de Y

1

(de hecho de todas las variables

aleatorias Y

n

).

De la expansion de la funcion caracterstica ?? se obtiene:

n

(t) =

_

1

t

2

2n

+o

_

1

n

__

.

Cuando n ,

_

1

t

2

2n

+o

_

1

n

_

_

e

t

2

/2

que es la funcion caracterstica

de una variable aleatoria N(0, 1).

2

Ejemplo 1.10 Una Aplicacion a Muestreo. En un lote de focos hay una

fraccion desconocida p de focos defectuosos. Utilizando el muestreo con reem-

plazo, se desea encontrar p con un error no mayor de 0.005.

Observese que

p =

N umero de focos defectuosos

N umero de focos en el lote

.

Sean X

1

, ..., X

n

variables aleatorias independientes Bernoulli con parametro

p. De la Ley de Fuerte de los Grandes N umeros, tenemos que

Sn

n

c.s.

p, por

18 CAP

ITULO 1. CONVERGENCIA

lo que para n grande se puede considerar a

Sn

n

como un estimador de p. La

Ley de Los Grandes N umeros no da suciente informacion pues no dice cual

es la velocidad de convergencia. Mas precisamente se desea encontrar n tal

que

P

_

S

n

n

p

< 0.005

_

> 0.95,

Observese que

P

_

S

n

n

p

< 0.05

_

= P

_

S

n

np

_

p(1 p)n

<

0.05n

_

p(1 p)n

_

.

Por el Teorema de Lmite Central se tiene que

S

n

np

_

p(1 p)n

D

X,

donde X es una variable aleatoria N(0, 1).

As, sea z

0

tal que N(z

0

) N(z

0

) = 0.95, donde N() = P[X ].

(Este valor se puede encontrar en las tablas de la distribucion Gaussiana) y

n sucientemente grande tal que

0.05

n

_

p(1 p)

z

0

,

esto es,

n 400p(1 p)z

2

0

.

En esta ultima expresion interviene p que es deconocida, sin embargo, inde-

pendientemente de su valor

1

4

p(1 p).

Luego entonces basta tomar n 100z

2

0

.

1.5 Evolucion del Problema

La Ley de los Grandes N umeros y el teorema de Lmite Central presenta-

dos son resultados sobre la convergencia de sumas normalizadas de vari-

ables aleatorias independientes e identicamente distribuidas, las primeras

1.5. EVOLUCI

ON DEL PROBLEMA 19

demostraciones (en el caso de variables aleatorias Bernoulli) datan del siglo

XVIII con los trabajos de Bernoulli, Laplace y De Moivre.

Los resultados que se presentan aqu son los llamados clasicos, y como

hemos visto se imponen condiciones fuertes sobre las distribuciones de las

variable aleatorias. Observese que en los casos descritos las variables aleato-

rias se centran con respecto a la media y se normalizan con respecto a la

varianza, ademas de que se supone que son independientes e identicamente

distribuidas.

Sin embargo, dada una sucesion arbitraria de variables aleatorias podramos

preguntarnos si es posible la existencia de una Ley de Grandes N umeros y un

Teorema de Lmite Central en alg un sentido. Mas precisamente este prob-

lema podra plantearse de la siguiente manera:

Dada una sucesion (X

n

)

n1

de variables aleatorias, existen constantes

(a

n

)

n1

, (b

n

)

n1

tales que

S

n

a

n

b

n

,

converja (en probabilidad) a una constante, o (en distribucion) a una dis-

tribucion Gaussiana? Algunas de las respuestas a estas preguntas pueden

consultars en ??, por ejemplo, cuando las variables aleatorias son independi-

entes mas no identicamente distribuidas. Resultados en este sentido existen

tambien cuando se debilita la condicion de independencia ??

En este siglo, Levy plantea un problema mas general:

Encontrar la familia de posibles distribuciones lmites de sumas normal-

izadas de variables aleatorias independientes e identicamente distribuidas, es

decir, sin imponer condiciones sobre la existencia de los momentos. Levy

considera el caso de segundo momento innito y primer momento nito o

innito.

Naturalmente, el problema de posibles distribuciones lmites de sumas

normalizadas de variables aleatorias independientes no necesariamente identicamente

distribuidas surge al mismo tiempo puede consultarse ??.

20 CAP

ITULO 1. CONVERGENCIA

Tarea III

Probabilidad II

1. Demuestre que la Ley Debil de Poisson es un caso particular de la Ley

Debil de Chebyshev.

2. Para cada n 1 sea X

n

una variable aleatoria N(n,

2

). Las variables

aleatorias X

n

, n 1 convergen en distribucion?.

3. Para cada n 1 sea X

n

una variable aleatoria N(,

1

n

). Las variables

aleatorias X

n

, n 1 convergen en distribucion?.

4. Sea (X

n

)

n1

una sucesion de variables aleatorias independientes, identicamente

distribuidas con distribucion Pareto con parametros , K > 0 dada por:

F(x) =

_

0, si x < K

1/

,

1 Kx

, si x K

1/

.

Sea M

n

= max {X

1

, ..., X

n

} y Z

n

=

Mn

(Kn)

1/

. Demuestre que Z

n

D

Z

donde Z es una variable aleatoria con distribucion dada por:

F

Z

(x) =

_

0, si x < 0,

exp(x

), si x 0.

A F

Z

se le conoce como la distribucion Frechet con parametro > 0.

5. Para los incisos (i)-(iv) genere (en el programa de computacion que

sepa usar) muestras de variables aleatorias X

1

, ..., X

n

, independientes

e identicamente distribuidas.

(a) Calcule S

n

=

n

i=1

X

i

,

(b) Calcule

Sn

n

comparelo con el resultado de la Ley de los Grandes

N umeros, para n = 10, 100, 1000, .

(c) Calcule para la muestra generada el proceso emprico N(x) denido

en las notas, compare los resultados con la distribucion de las vari-

ables aleatorias. (Teorema de Glivenko-Cantelli).

(i) Variables aleatorias Bernoulli con parametro p (para tres distintos

valores del parametro).

1.5. EVOLUCI

ON DEL PROBLEMA 21

(ii) Variables aleatorias Binomiales con parametros k, p (para tres

valores distintos de (k, p)).

(iii) Variables aleatorias Exponenciales con parametro > 0 (para

tres valores distintos del parametro).

(iv) Variables aleatorias Gamma con parametros , . (para tres dis-

tintos valores de los parametros.)

6. Compare la distribucion de

n

i=1

X

i

con la aproximacion del Teorema

de Lmite Central, para las variables aleatorias (i)-(iv) del ejercicio

anterior. Es decir, considere X

1

, ..., X

n

v. a.i.i.d. S

n

=

n

i=1

X

i

,

entonces

P[S

n

x] P

_

X

x n

n

2

_

,

donde E[X

i

] = ,V ar(X

i

) =

2

y X es una variable aleatoria N(0, 1).

No use simulaciones en este ejercicio sino la distribucion exacta. Para

n = 10, 30, 50.

Das könnte Ihnen auch gefallen

- Notas Convergencia PDFDokument21 SeitenNotas Convergencia PDFHéctor MuñozNoch keine Bewertungen

- ConvergenciaDokument24 SeitenConvergenciaAMYNNXXXXNoch keine Bewertungen

- Convergencia de sucesiones de variables aleatoriasDokument32 SeitenConvergencia de sucesiones de variables aleatoriasUriel GarciaNoch keine Bewertungen

- Cap 7 La V2Dokument25 SeitenCap 7 La V2Emilio Llanos HuamanNoch keine Bewertungen

- Dos Teoremas LimiteDokument33 SeitenDos Teoremas LimiteAMYNNXXXXNoch keine Bewertungen

- Series16 17Dokument30 SeitenSeries16 17Paco RiscoNoch keine Bewertungen

- Ley de Los Números Grandes PDFDokument6 SeitenLey de Los Números Grandes PDFEric Vázquez VillatoroNoch keine Bewertungen

- Convergencias EstocásticasDokument11 SeitenConvergencias EstocásticasFelipe CruzNoch keine Bewertungen

- Libro Proceso SDokument199 SeitenLibro Proceso Scerjio9Noch keine Bewertungen

- Teoremas LimiteDokument15 SeitenTeoremas LimiteAlejandro GLNoch keine Bewertungen

- Teoría de Conjuntos. Capitulo 3 PDFDokument13 SeitenTeoría de Conjuntos. Capitulo 3 PDFSara Camacho100% (1)

- Subsucesiones PDFDokument3 SeitenSubsucesiones PDFBelkysGoncalvesNoch keine Bewertungen

- Mat021-Apunte Sucesiones Ayud Mauricio GodoyDokument11 SeitenMat021-Apunte Sucesiones Ayud Mauricio GodoyCeeiqa UsmNoch keine Bewertungen

- Probabilidad II U3Dokument18 SeitenProbabilidad II U3MaryNoch keine Bewertungen

- Convergencia en probabilidad y casi toda parte en espacios puramente atómicosDokument5 SeitenConvergencia en probabilidad y casi toda parte en espacios puramente atómicosSEBASTIAN PERDOMO LEIVANoch keine Bewertungen

- Cap 4 PDFDokument42 SeitenCap 4 PDFFrancisco Montoya SánchezNoch keine Bewertungen

- Convergencia de variables aleatoriasDokument18 SeitenConvergencia de variables aleatoriasmemfilmatNoch keine Bewertungen

- EstadisticaDokument13 SeitenEstadisticanickNoch keine Bewertungen

- EstadisticaDokument8 SeitenEstadisticanickNoch keine Bewertungen

- Taller EstadisicaDokument13 SeitenTaller EstadisicaHernan QuinteroNoch keine Bewertungen

- Guia de Materia Función de Probabilidad, Esperanza, Varianza 2016Dokument3 SeitenGuia de Materia Función de Probabilidad, Esperanza, Varianza 2016tralkan77Noch keine Bewertungen

- CAP6Dokument23 SeitenCAP6anaNoch keine Bewertungen

- Cap6v1.2 Des Esperanza y VarianzaDokument46 SeitenCap6v1.2 Des Esperanza y VarianzaWendyNavarroNoch keine Bewertungen

- Técnicas de DemostraciónDokument16 SeitenTécnicas de DemostraciónJUAN JOSE ALDANA CARRANZANoch keine Bewertungen

- Convergencia en ProbabilidadDokument19 SeitenConvergencia en Probabilidadcristian_masterNoch keine Bewertungen

- Sucesiones MonotonasDokument7 SeitenSucesiones MonotonasAmerico GuerreroNoch keine Bewertungen

- Sucesiones monótonas y convergenciaDokument7 SeitenSucesiones monótonas y convergenciaRoberto Antonio Matheus C.Noch keine Bewertungen

- Variables aleatorias: discretas, continuas y sus funcionesDokument8 SeitenVariables aleatorias: discretas, continuas y sus funcionesestefaniaNoch keine Bewertungen

- Stolz - PDF DemostracionDokument7 SeitenStolz - PDF DemostracionLuis Alania Espiritu100% (1)

- Ley de Los Grandes NumerosDokument6 SeitenLey de Los Grandes NumerosLuis BautistaNoch keine Bewertungen

- Cadena de Markov - Poisson - Martingala - Mov BrownianoDokument10 SeitenCadena de Markov - Poisson - Martingala - Mov BrownianoEnoc BarrigaNoch keine Bewertungen

- Tema 5 2019Dokument85 SeitenTema 5 2019Kuki DogNoch keine Bewertungen

- Distribucion ExponencialDokument14 SeitenDistribucion ExponencialLucero Colunche BustamanteNoch keine Bewertungen

- Ley de Los Grandes Números - Fuerte PDFDokument6 SeitenLey de Los Grandes Números - Fuerte PDFMarcelo Andrés Jaime DíazNoch keine Bewertungen

- Presen7 Ley D Bil de Los Grandes N MerosDokument21 SeitenPresen7 Ley D Bil de Los Grandes N MerosNatalia Laiton RomeroNoch keine Bewertungen

- Ley de Los Grandes NúmerosDokument8 SeitenLey de Los Grandes NúmerosRobertNoch keine Bewertungen

- Teorema Del Limite Central y Ley de Los NumerosDokument6 SeitenTeorema Del Limite Central y Ley de Los NumerosCarlos Alberto QuinatoaNoch keine Bewertungen

- Proyecto de CalculoDokument11 SeitenProyecto de CalculoJefferson Fernando Mendoza NamayNoch keine Bewertungen

- Sucesiones ConvergentesDokument10 SeitenSucesiones ConvergentesLuzz's OlveraNoch keine Bewertungen

- T2 ProbabilidadDokument14 SeitenT2 ProbabilidadlauraNoch keine Bewertungen

- NOTAS - Estadística I Jimmy Hernández MoralesDokument385 SeitenNOTAS - Estadística I Jimmy Hernández MoralesCarlo IsaacNoch keine Bewertungen

- Introducción a la Teoría de Conjuntos: Notas de clase sobre números naturales y recursiónDokument21 SeitenIntroducción a la Teoría de Conjuntos: Notas de clase sobre números naturales y recursiónCamilo Lozano100% (1)

- Apuntes Tema 2 ProbabilidadDokument16 SeitenApuntes Tema 2 Probabilidadgirama3003Noch keine Bewertungen

- EMatemáticas FinitasDokument16 SeitenEMatemáticas FinitasEsteban Alonso Guzman FuentesNoch keine Bewertungen

- Foro Estadística DescriptivaDokument5 SeitenForo Estadística DescriptivaLuis Adrian CamachoNoch keine Bewertungen

- Análisis de la convergencia de sucesiones de números realesDokument3 SeitenAnálisis de la convergencia de sucesiones de números realesjuan manuelNoch keine Bewertungen

- Sucesiones ConvergentesDokument10 SeitenSucesiones ConvergentesDanny DacodavNoch keine Bewertungen

- Distribuciones de ProbabilidadDokument8 SeitenDistribuciones de Probabilidadsebas alvaNoch keine Bewertungen

- Medida Leccion 7Dokument9 SeitenMedida Leccion 7Luis EduardoNoch keine Bewertungen

- Inferencia estadística UNCDokument3 SeitenInferencia estadística UNCLEANDRO EZEQUIEL FERNANDEZNoch keine Bewertungen

- Variable AleatoriaDokument143 SeitenVariable AleatoriaSergio Vázquez Razo0% (1)

- Distrib de Probabilidad M6 (1er Parcial)Dokument19 SeitenDistrib de Probabilidad M6 (1er Parcial)Guzmán GregoryNoch keine Bewertungen

- Curso básico de teoría de númerosVon EverandCurso básico de teoría de númerosBewertung: 5 von 5 Sternen5/5 (2)

- Producción Final Analisis Matematico 2Dokument17 SeitenProducción Final Analisis Matematico 2Samuel El CrackNoch keine Bewertungen

- Análisis de la convergencia de sucesiones realesDokument16 SeitenAnálisis de la convergencia de sucesiones realesRomina Belen Miranda SernaNoch keine Bewertungen

- Introducción Al Análisis Matemático Minas Visado - HuamachucoDokument7 SeitenIntroducción Al Análisis Matemático Minas Visado - HuamachucoJosé Aranda LedesmaNoch keine Bewertungen

- Análisis Numérico / Análisis Numérico I: Clase 1Dokument6 SeitenAnálisis Numérico / Análisis Numérico I: Clase 1Ely AriasNoch keine Bewertungen

- F Isica Matem Atica Ii: Versi On Del 20 de Agosto de 2019Dokument131 SeitenF Isica Matem Atica Ii: Versi On Del 20 de Agosto de 2019René CuevasNoch keine Bewertungen

- UNAC Calculo IVDokument133 SeitenUNAC Calculo IVPedro SiriasNoch keine Bewertungen

- Ejercicios Resueltos y PropuestosDokument7 SeitenEjercicios Resueltos y PropuestosRenato Costa100% (1)

- Mate Superior Teoria y PracticaDokument70 SeitenMate Superior Teoria y PracticaAndrea GavariniNoch keine Bewertungen

- Esquema Formulario PDFDokument129 SeitenEsquema Formulario PDFLucho H. G.0% (2)

- Teoría de Distribuciones enDokument9 SeitenTeoría de Distribuciones enJhonatan CalloapazaNoch keine Bewertungen

- (659824768) Anafun1Dokument37 Seiten(659824768) Anafun1Josselyne Levano BNoch keine Bewertungen

- Ejercicios de Teoria de La MedidaDokument98 SeitenEjercicios de Teoria de La MedidaMirian MermaNoch keine Bewertungen

- Método de Iteración de Punto FijoDokument17 SeitenMétodo de Iteración de Punto FijoDIAZ RODRIGUEZ PIERO CHRISTOPHERNoch keine Bewertungen

- SucesionesDokument1 SeiteSucesionesAngie SantanderNoch keine Bewertungen

- TP Final EDI Series y SucecionesDokument125 SeitenTP Final EDI Series y SucecionesFaty LynNoch keine Bewertungen

- Entregable Resuelto ListoDokument7 SeitenEntregable Resuelto ListoYelitza RodriguezNoch keine Bewertungen

- Series de Potencias Con PreliminaresDokument89 SeitenSeries de Potencias Con PreliminaresOsmar Castillo100% (2)

- Matematicas Resueltos (Soluciones) Limites de Sucesiones Nivel I 1º BachilleratoDokument68 SeitenMatematicas Resueltos (Soluciones) Limites de Sucesiones Nivel I 1º Bachilleratomanuel_valle_4Noch keine Bewertungen

- Sesión 14 - 1 - Series de Potencias-Radio e Intervalo de ConvergenciaDokument25 SeitenSesión 14 - 1 - Series de Potencias-Radio e Intervalo de ConvergenciaDavid VargasNoch keine Bewertungen

- EXAMEN FINAL - Revisión Del IntentoDokument7 SeitenEXAMEN FINAL - Revisión Del IntentoNathalia RodriguezNoch keine Bewertungen

- Propiedades límites sucesionesDokument4 SeitenPropiedades límites sucesionesJean Carlos Gonzalez MoranNoch keine Bewertungen

- SERIESDokument13 SeitenSERIESJesúsNoch keine Bewertungen

- R3 Continuos - Luis Antonio Paredes RivasDokument88 SeitenR3 Continuos - Luis Antonio Paredes RivasDonGerardNoch keine Bewertungen

- Derivación y convergencia de series de potencias (≤40Dokument8 SeitenDerivación y convergencia de series de potencias (≤40Domms DommsNoch keine Bewertungen

- Metodos Numericos - Sin DerivadaDokument24 SeitenMetodos Numericos - Sin Derivadaf22krash100% (1)

- Criterios convergencia series 38Dokument1 SeiteCriterios convergencia series 38Yamid Muñoz67% (3)

- AproxSucesivasDokument10 SeitenAproxSucesivasEdoardo DenegriNoch keine Bewertungen

- SERIES INFINITAS y CRITERIOS DE CONVERGENCIADokument23 SeitenSERIES INFINITAS y CRITERIOS DE CONVERGENCIALUZ ANGELA VERA CONTRERASNoch keine Bewertungen

- Sucesiones y Series NuevoDokument2 SeitenSucesiones y Series NuevoFrancisco Javier Valenzuela RiquelmeNoch keine Bewertungen

- Identidad Del ParalelogramoDokument4 SeitenIdentidad Del ParalelogramoLorenzo Cruz AguillónNoch keine Bewertungen