Beruflich Dokumente

Kultur Dokumente

Chapitre6 3

Hochgeladen von

Chatnoir NoirOriginaltitel

Copyright

Verfügbare Formate

Dieses Dokument teilen

Dokument teilen oder einbetten

Stufen Sie dieses Dokument als nützlich ein?

Sind diese Inhalte unangemessen?

Dieses Dokument meldenCopyright:

Verfügbare Formate

Chapitre6 3

Hochgeladen von

Chatnoir NoirCopyright:

Verfügbare Formate

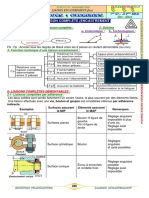

6 Classification automatique 1 6. CLASSIFICATION AUTOMATIQUE ................................................................................................................. 2 6.1 CE QUI DISTINGUE LES DIFFRENTES MTHODES ...................................................................................................2 6.

2 LES MTHODES HIRARCHIQUES ...........................................................................................................................2 6.2.1 La mthode "single linkage" ou "plus proche voisin"................................................................................. 3 6.2.2 La mthode "complete linkage" ou "voisin le plus loign" ....................................................................... 3 6.2.3 Les mthodes intermdiaires ....................................................................................................................... 3 6.3 LE DENDROGRAMME .............................................................................................................................................4 6.4 EXEMPLES DE CLASSIFICATION HIRARCHIQUE .....................................................................................................4 6.4.1 Exemple de Davis ........................................................................................................................................ 4 6.4.2 Exemple des montrgiennes ...................................................................................................................... 4 6.5 LES MTHODES NON-HIRARCHIQUES ...................................................................................................................5 6.5.1 Critre guidant les itrations ; convergence ............................................................................................... 5 6.5.2 Groupements stables ou formes fortes ........................................................................................................ 6 6.5.3 Exemple: classification non-hirarchique sur les donnes des montrgiennes. ....................................... 8 6.6 CRITRES DE RESSEMBLANCE ENTRE OBSERVATIONS. ..........................................................................................8 6.7 AIDES L'INTERPRTATION ..................................................................................................................................8 6.8 SEGMENTATION ....................................................................................................................................................9

6 Classification automatique 2

6. Classification automatique Etant donn "n" observations, comment puis-je les regrouper en un certain nombre de groupes (disons k) de faon ce que les groupes obtenus soient constitus d'observations semblables et que les groupes soient le plus diffrents possible entre eux. C'est la rponse cette question que veulent fournir les mthodes de classification automatique. La diversit des mthodes en classification automatique est dconcertante au premier abord. Des volumes entiers ont ts publis sur le sujet. Nous nous bornerons ici noncer les grands principes qui sous-tendent toutes ces mthodes. Il est important de bien cerner ce qui distingue la classification automatique de l'analyse discriminante. Dans l'AD, les groupes sont connus priori. Ils servent dfinir une quation (ou des quations si le nombre de groupes est suprieur 2) permettant de classer une nouvelle observation dont le groupe est inconnu. En classification automatique, il n'y a pas de groupes priori. La mthode cherche dans le nuage de points les zones denses qui formeront des groupes qu'il restera interprter par la suite.

6.1 Ce qui distingue les diffrentes mthodes Trois lments permettent de caractriser les diffrentes mthodes : i. La classification procde squentiellement en regroupant les observations les plus `semblables' en premier lieu (mthodes hirarchiques) ou elle regroupe en k groupes toutes les observations simultanment (mthodes non-hirarchiques). Le critre de `ressemblance' entre deux observations. Le critre de `ressemblance' entre deux groupes ou entre une observation et un groupe.

ii. iii.

6.2 Les mthodes hirarchiques Historiquement, elles furent les premires dveloppes, principalement en raison de la simplicit des calculs. L'avnement des puissants ordinateurs leur a fait perdre une certaine popularit au profit des mthodes non-hirarchiques. Toutefois, dans certains domaines (ex. palontologie), elles demeurent d'utilisation courante en raison de leur capacit d'organiser les ressemblances suivant une hirarchie, ce qui est le principe de classification habituel lorsqu'on parle d'espces animales ou vgtales. Dfinition: On appellera groupe un ensemble de une ou plusieurs observations regroupes par la mthode de classification.

L'algorithme de base est le suivant : i. a-t-on plus d'un groupe (si non, on termine).

6 Classification automatique 3

ii. iii.

calculer les `ressemblances' entre toutes les paires de groupes. fusionner les deux groupes montrant la plus grande ressemblance (similarit) ou la plus faible dissemblance (dissimilarit).

Les mthodes hirarchiques diffreront entre elles par le choix du critre de ressemblance et par la faon de mesurer les ressemblances entre un nouveau groupe fusionn et les autres inchangs.

6.2.1 La mthode "single linkage" ou "plus proche voisin" Soit la mesure de ressemblance S. Soit trois groupes R,P et Q. Supposons que R est fusionn avec P. On calculera la ressemblance de (R+P) avec Q de la faon suivante : S(R+P, Q)= max[ S(R,Q) , S(P,Q) ]

6.2.2 La mthode "complete linkage" ou "voisin le plus loign" Toujours avec la mme notation, on calculera plutt la ressemblance entre les anciens groupes et le nouveau groupe fusion de R et P par: S(R+P , Q)= min[ S(R,Q) , S(P,Q) ]

6.2.3 Les mthodes intermdiaires Ces mthodes dfinissent une ressemblance `moyenne' entre groupes. Il en existe plusieurs variantes. ex. "average linkage" : S(R+P , Q)= np/(np+nr)* S(P,Q) + nr/(np+nr)* S(R,Q) o np : nombre d'observations constituant le groupe P. D'autres mthodes compromis existent, certaines ne peuvent tre utilises qu'avec certains types de mesures de ressemblance. On peut mme, avec le logiciel `Clustan' par exemple, dfinir nos propres methodes de calcul de ressemblances entre un groupe fusionn et les autres. La mthode du `single linkage' est peu utilise de nos jours en raison du problme de chanage que cette mthode occasionne. Trs souvent, en effet, on se retrouve avec un groupe dmesurment gros et plusieurs petits groupes satellites. Le `complete linkage ne prsente pas ce problme. La mthode du complete linkage tend, au contraire former des groupes de taille gale.

6 Classification automatique 4

6.3 Le dendrogramme Puisque les mthodes hirarchiques fusionnent les groupes des degrs dcroissants de ressemblance, il est naturel de reprsenter les rsultats de la classification au moyen d'une structure arborescente que l'on appelle dendrogramme Il peut tre intressant de fournir ici l'algorithme pour la construction d'un dendrogramme qui consiste ordonner les observations de telle sorte qu'il n'y ait aucun croisement entre les diverses branches du dendrogramme. i. ii. iii. iv. placer les observations selon un ordre quelconque de gauche droite s'il ne reste qu'un seul groupe, on termine. prendre les groupes compris entre les groupes qui fusionnent et les dplacer rigidement la droite de la dernire observation du groupe fusionn situ le plus droite. retourner ii.

6.4 Exemples de classification hirarchique

6.4.1 Exemple de Davis L'exemple suivant est tir de Davis. Les observations consistent en des lames minces provenant de grs. Les variables mesures dcrivent la structure de la roche dont: taille et forme des grains, taille et forme des vides et proportion de vides. Davis utilise le cosinus entre les vecteurs dobservations comme mesure de similarit (1: plus ressemblant, -1: moins ressemblant). La similarit aprs fusion est calcule comme la moyenne des similarits calcules avant fusion (forme de "average linkage"). Il obtient les rsultats suivants: Question: Quelle modification faudrait-il faire la mesure de similarit si l'on voulait qu'une corrlation ngative forte soit indicatrice d'une forte similarit?

6.4.2 Exemple des montrgiennes L'exemple suivant montre l'application des mthodes liens simples et liens complets aux 68 donnes provenant des montrgiennes (voir chapitre sur l'ACP). On note les faits suivants: i. La mthode liens simples a donn de pitres rsultats. On observe un phnomne de chanage important puisqu'un seul grand groupe est discernable, peu importe le niveau de similarit ou l'on coupe. On ne retrouve pas du tout les groupes ptrologiques connus. La mthode liens complets a donn de bons rsultats. On retrouve dans l'ensemble les groupes ptrologiques connus. Les groupes sont de taille comparable.

ii.

6 Classification automatique 5

6.5 Les mthodes non-hirarchiques Ces mthodes sont plus proches des mthodes factorielles vues jusqu'ici. Leur essor est reli la possibilit rcente d'effectuer trs faible cot des montagnes de calculs. L'ide sous-jacente consiste rechercher les zones denses du nuage d'observations. L'algorithme de base est le suivant: A- Initialisation i. on choisit alatoirement k ( prciser) groupes d'observations avec un nombre donn d'observations dans chaque groupe (disons n/k), on initialise le critre de dispersion une valeur infinie. B- Itration ii. on calcule le vecteur moyenne (centre) des k groupes. iii. on calcule pour chaque observation la distance au centre de chaque groupe et on calcule le critre de dispersion prsent. Si la dispersion dcrot, on continue, sinon on arrte lalgorithme. iv. on affecte chaque observation au groupe dont elle est le plus prs; on obtient ainsi k nouveaux groupes et on retourne ii. Cet algorithme porte le nom de "agrgation autour de centres variables". Une version lgrement diffrente, connue sous le nom de "nues dynamiques" consiste reprsenter chaque groupe non pas par son centre, mais par un ensemble de points (noyau) choisis alatoirement l'intrieur de chaque groupe. On calcule alors une distance "moyenne" entre chaque observation et ces noyaux et l'on procde l'affectation. Une autre mthode, celle des "k-means", suit le principe gnral de la mthode d'agrgation autour de centres variables sauf que ds qu'une observation est affecte un groupe, on recalcule immdiatement la moyenne de ce groupe. Cette mthode converge plus rapidement, toutefois, le rsultat final peut dpendre de l'ordre dans lequel les observations sont lues.

6.5.1 Critre guidant les itrations ; convergence Pour qu' un algorithme de classification non-hirarchique soit acceptable, il est essentiel de dmontrer sa convergence un optimum local, sinon on pourrait boucler indfiniment. On parle d'optimum local plutt que d'optimum global car le critre est minimis en fonction d'une certaine partition initiale et d'un algorithme donn. Le rsultat n'est pas ncessairement le meilleur ensemble que l'on puisse obtenir puisqu'une partition initiale diffrente aurait pu donner de meilleurs rsultats. Autrement dit, le critre d'optimisation reprsente une fonction, dans l'espace des partitions possibles, qui n'est pas ncessairement convexe. Un critre pouvant tre utilis est la dispersion dans les groupes, i.e. la somme des carrs des distances des observations au centre du groupe auquel elles sont affectes (c.f. AD). critre = trace(D) = trace [(X-C)'(X-C)] o X est la matrice nxp des observations. C est la matrice nxp des moyennes des groupes rptes autant de fois qu'il y a d'observations dans le groupe considr trace: somme des lments diagonaux

6 Classification automatique 6

Ce critre permet de contrler les itrations. En effet la quantit trace (D) ne peut augmenter entre deux itrations successives m et m+1. On applique donc l'algorithme jusqu' ce que trace(D) diminue d'une valeur considre ngligeable. Dmonstration: i. ii. Trace(D) ne peut pas crotre entre deux itrations m et m+1 :

Lorsqu'on calcule Trace(D)m tape ii de l'itration m, on a la partition de l'itration m-1 et les centres de groupes de l'itration m. Si, l'itration m, aprs l'affectation on calculait la dispersion en utilisant les centres de groupes de cette mme itration, on aurait ncessairement une dcroissance de la dispersion puisquon a dplac les observations dun groupe lautre en utilisant le critre de distance minimale. De mme, ltape iii de litration suivante (m+1), on calcule la dispersion avec les mmes groupes que prcdemment mais cette fois par rapport leur vritable centre et non par rapport au centre de litration prcdente. Le centre d'un groupe est le point par rapport auquel la dispersion est minimale, donc celle-ci ne peut que dcrotre (ou demeure inchange) nouveau.

6.5.2 Groupements stables ou formes fortes La partition finale obtenue correspond ce qu'il convient d'appeler un optimum local. Le critre de dispersion ne peut plus dcrotre et on arrte donc l'algorithme. Les rsultats obtenus dpendent toutefois de la partition initiale (choisie alatoirement). Des groupes initiaux diffrents auraient pu donner une partition finale diffrente. Afin de contrer cette ennuyeuse situation et de dterminer quels sont les groupes vraiment homognes, il suffit d'appliquer l'algorithme plusieurs fois en modifiant les groupes initiaux et de noter quelles sont les observations qui se regroupent toujours ensemble. C'est ce que l'on appelle des formes fortes. Il convient de noter qu'il y a un maximum de kr formes fortes possibles (o r est le nombre de partitions initiales diffrentes). Ainsi avec k=4 et r=5, on aurait 1024 formes fortes possibles ( condition bien sr qu'il y ait plus de 1024 observations). En pratique toutefois le nombre de formes fortes ayant un effectif non-ngligeable est beaucoup moindre que cette valeur (avec n=1024, r=4, on aurait possiblement seulement 7 ou 8 formes fortes ayant plus de 10 observations). Exemple: Supposons que l'on ait 20 observations et que l'on applique un algorithme de classification non-hirarchique partir de 4 partitions alatoires initiales. Si, chaque application de l'algorithme, on demande de former 3 groupes, on pourra former le tableau suivant rsumant les rsultats de la classification.

6 Classification automatique 7

Observation # 15 17 10 12 11 1 4 5 7 2 3 8 16 18 9 20 6 13 14 19

1er essai 1 1 1 1 1 1 1 1 2 2 2 2 2 3 3 3 3 3 3 3

2e essai 3 3 3 3 3 3 3 3 1 1 1 1 1 2 2 2 2 2 2 2

3e essai 3 3 3 3 3 3 3 3 2 2 2 2 2 1 1 1 1 1 2 2

4e essai 2 2 2 2 2 2 2 2 1 1 1 1 1 3 3 3 3 3 3 3

Dans le tableau ci-haut, on distingue 4 formes fortes. Une premire constitue des observations [15,17,10,12,11,1,4,5], une 2e forme des observations [7,2,3,8,16], une 3e regroupant [18,9,20,6,13] et la 4e forme de [14,19]. Cette dernire forme forte est trs semblable la 3e, puisque sur 4 essais, un seul a regroup ces observations sparment. Le choix de trois groupes semble donc ici judicieux. Si lon avait observ plus de formes fortes, il aurait alors t souhaitable de rpter la classification en spcifiant plus (ou moins) de groupes former. On discerne mieux maintenant une diffrence fondamentale entre les mthodes hirarchiques et les mthodes non-hirarchiques. Avec les premires, on obtient une seule classification reprsente par le dendrogramme. L'utilisateur dtermine postriori combien de groupes lui semblent significativement diffrents. Avec les mthodes non-hirarchiques, le nombre de groupes doit tre fix priori. De plus dpendant du nombre de

6 Classification automatique 8

rptitions de la classification, on obtiendra possiblement un nombre beaucoup plus grand de formes fortes et l'utilisateur devra interprter ces formes fortes pour possiblement les fusionner, les liminer de l'tude ou reprendre l'tude avec un nombre de groupe initial diffrent. Malgr ce dsavantage, les mthodes non-hirarchiques sont suprieures aux mthodes hirarchiques pour ce qui est de la description des zones denses du nuage des observations. De plus le problme de la mesure de la ressemblance entre deux groupes fusionns ne se pose videmment pas. Notons qu'il est possible d'utiliser conjointement les deux mthodes en formant d'abord des groupes (formes fortes) par mthode non-hirarchique, puis en utilisant une mesure de ressemblance entre les groupes obtenus et en effectuant une classification hirarchique sur ces groupes. Comme on le voit, il y a large place laisse notre imagination. Question: Si on demande de former plus de groupes qu'il n'en existe rellement, que se passera-t-il lorsqu'on appliquera l'algorithme de classification plusieurs fois?

6.5.3 Exemple: classification non-hirarchique sur les donnes des montrgiennes. Par un algorithme de type "k-means", on a obtenu les groupes suivants que l'on reprsente sur le plan factoriel des axes 1 et 2 de l'ACP. On notera une bonne concordance entre les groupes obtenus par classification automatique et les groupes ptrologiques.

6.6 Critres de ressemblance entre observations. Il existe une multitude de critres de ressemblance entre observations. Dans un livre rcent sur le sujet (Legendre L. et Legendre P.,1984), on en rpertorie au-del de 70 diffrents. Toutefois, tous appartiennent deux grands types : les mesures de distance et les mesures de similarit. Les mesures de similarit obissent aux deux proprits suivantes : i. ii. symtrie: s(x,y) = s(y,x) s(x,y) est maximum quand x=y

Les mesures de distance obissent aux proprits suivantes : i. ii. iii. symtrie: d(x,y) = d(y,x) 0 d(x,y) = 0 <==> x=y ingalit triangulaire: d(x,y) d(x,z) + d(y,z)

Chaque mesure possde ses avantages et ses inconvnients, le choix d'une plutt que de l'autre s'effectue selon la nature des donnes et la nature des relations entre observations que l'on veut mettre particulirement en valeur. La mthode utilise (hirarchique ou non-hirarchique) influence aussi le choix. En effet, on favorisera plutt les mesures de distance avec les mthodes non-hirarchiques. 6.7 Aides l'interprtation

6 Classification automatique 9

Une fois les groupements obtenus, il faut pouvoir les interprter. Pour ce faire, toutes les mthodes d'analyse des donnes vues jusqu'ici peuvent tre mises profit. L'analyse discriminante en particulier permet de dterminer selon quel(s) facteur(s) s'est effectu le regroupement. On obtient parfois d'excellentes visualisations l'aide de l' ACP ou de l' AC. On peut dessiner des enveloppes reprsentant les groupes sur les plans factoriels, examiner les relations entre les groupes, etc. Les statistiques lmentaires pour chaque groupe obtenu peuvent galement donner d'excellentes pistes. On ne doit videmment pas ngliger toute information extrieure susceptible d'clairer l'interprtation. Prcisons galement que dans certaines applications, les regroupements sont effectus non pas sur les valeurs originales des p variables, mais sur des valeurs issues de celles-ci comme par exemple les coordonnes obtenues de l'ACP sur un nombre restreint (q < p) de vecteurs propres, ou encore les coordonnes obtenues de l'AC. Question: Les groupes obtenus avec les p coordonnes d'une ACP (matrice des covariances) seront-ils les mmes que ceux obtenus avec les p variables initiales lorsque le critre de dispersion utilise la distance euclidienne?

6.8 Segmentation La segmentation d'une image consiste identifier des zones homognes dans l'image. On identifie d'abord des pixels sur l'image qui servent d'amorce aux diffrents groupes. L'algorithme type, dit de croissance des rgions, procde en cherchant amalgamer aux diffrents pixels les pixels voisins. Un critre de distance (dans l'espace des variables) est utilis. Algorithme : i. Dterminer un seuil dmax correspondant la plus grande diffrence acceptable pour quun pixel puisse tre joint un germe donn. Les germes sont considrs tour de rle en commenant par le premier. ii. Tous les pixels xi tel que d(xi,gj) < dmax et tel que partant de xi il est possible de rejoindre gj en empruntant uniquement (par le ct) des pixels respectant ce mme critre sont associs au germe gj et sont tiquets dfinitivement. Parmi ces pixels, il peut se retrouver dautres germes non encore traits (la catgorie est alors absorbe et ce germe est retir de la liste des germes traiter). iii. Considrer le germe suivant dans la liste des germes traiter et aller ii. jusqu puisement de la liste. terminaison, il et possible que certains pixels naient t affects aucun des germes initiaux. Dans ce cas, on peut soit augmenter la valeur de dmax, soit crer de nouveaux germes dans ces zones et repartir lalgorithme, soit laisser ces pixels comme non classs.

Das könnte Ihnen auch gefallen

- Betonnage Sous Leau 4Dokument8 SeitenBetonnage Sous Leau 4Chatnoir Noir0% (1)

- 28 60 Pompes Dinjection Triplex 2011 083Dokument2 Seiten28 60 Pompes Dinjection Triplex 2011 083Chatnoir NoirNoch keine Bewertungen

- @1 Configuration Entreprise Et GRH 1Dokument13 Seiten@1 Configuration Entreprise Et GRH 1Chatnoir NoirNoch keine Bewertungen

- MDQ Principes de Management de La Qualité ISO 9000-2000Dokument3 SeitenMDQ Principes de Management de La Qualité ISO 9000-2000Chatnoir NoirNoch keine Bewertungen

- CCTP Chapitre03 19Dokument8 SeitenCCTP Chapitre03 19Chatnoir NoirNoch keine Bewertungen

- CCTP Chapitre03 17Dokument10 SeitenCCTP Chapitre03 17Chatnoir NoirNoch keine Bewertungen

- Transport Et Exploitation D'énergie ÉlectriqueDokument6 SeitenTransport Et Exploitation D'énergie ÉlectriqueHakim Abdelhakim NabilNoch keine Bewertungen

- La Géométrie Du Train AvantDokument21 SeitenLa Géométrie Du Train AvantHamza OuikassiNoch keine Bewertungen

- Calcul Des Courants de Court CircuitDokument35 SeitenCalcul Des Courants de Court CircuitSandra PayageNoch keine Bewertungen

- Automatique 2AGM Chap1 PDFDokument37 SeitenAutomatique 2AGM Chap1 PDFSassi AmineNoch keine Bewertungen

- 26 Liaison ComplèteDokument20 Seiten26 Liaison ComplèteFarouk Keniou100% (1)

- Rta 4211Dokument8 SeitenRta 4211Atef Ben AmmarNoch keine Bewertungen

- TD3 2022-2023Dokument1 SeiteTD3 2022-2023saidihakima87Noch keine Bewertungen

- Tavaux DirigésDokument2 SeitenTavaux DirigésHakimAgüeroNoch keine Bewertungen

- MJ SlidesDokument22 SeitenMJ SlidesMokhtarBensaidNoch keine Bewertungen

- Devoir de Synthèse N°3 - Sciences Physiques - Bac Sciences Exp (2011-2012) MR BARHOUMIDokument4 SeitenDevoir de Synthèse N°3 - Sciences Physiques - Bac Sciences Exp (2011-2012) MR BARHOUMIMohamed SaidiNoch keine Bewertungen

- Exposition Au Béryllium-IRSSTDokument58 SeitenExposition Au Béryllium-IRSSTIssad KamalNoch keine Bewertungen

- Exam Phys Stat 2010Dokument4 SeitenExam Phys Stat 2010Hadjer JojoNoch keine Bewertungen

- CorrigéSérie TD5 Phys 3Dokument3 SeitenCorrigéSérie TD5 Phys 3Suzuki GSXRNoch keine Bewertungen

- Cristallographie PDFDokument98 SeitenCristallographie PDFRyad KheloufNoch keine Bewertungen

- 419 Lecon2013 PDFDokument3 Seiten419 Lecon2013 PDFKL TpkosNoch keine Bewertungen

- 04 Electrocinetique Regimes Transitoires Exercices PDFDokument2 Seiten04 Electrocinetique Regimes Transitoires Exercices PDFRiad TifaNoch keine Bewertungen

- Free EnergyDokument23 SeitenFree Energydjabio100% (1)

- Controle Des Travaux de Terrassements PDFDokument58 SeitenControle Des Travaux de Terrassements PDFlimmoudNoch keine Bewertungen

- TP Ef Axe ContreficheDokument4 SeitenTP Ef Axe Contreficheمحمد الأمين شرفاويNoch keine Bewertungen

- Corrigé de L'examen Nal de Maths 3Dokument5 SeitenCorrigé de L'examen Nal de Maths 3An IsNoch keine Bewertungen

- ElectromagnetiqueDokument16 SeitenElectromagnetiqueKay Chan Sotheara100% (4)

- KSB Determination Des Pompes Centrifuges FRDokument96 SeitenKSB Determination Des Pompes Centrifuges FRCamille Aquilon83% (6)

- Les Fontes MouléesDokument6 SeitenLes Fontes MouléesAbdessamad JannaneNoch keine Bewertungen

- Cours de Cristallo MpsiDokument10 SeitenCours de Cristallo MpsiMOHAMEDELOULJI0% (1)

- Chaines Cinematiques - Prof PDFDokument7 SeitenChaines Cinematiques - Prof PDFGenie Meca0% (1)

- CNRS PC Par THDokument6 SeitenCNRS PC Par THyousfi majdNoch keine Bewertungen

- Exercice Sve CT EursDokument44 SeitenExercice Sve CT EursAbdelilah El GmairiNoch keine Bewertungen

- Liaisons Mécaniques ModélisationDokument6 SeitenLiaisons Mécaniques ModélisationRedelNoch keine Bewertungen

- EV32-EV38 Evaluation Chap 5 CorrigeDokument7 SeitenEV32-EV38 Evaluation Chap 5 CorrigeSunpreetSingh22Noch keine Bewertungen

- Série D'exercices 14, Mouvements Plans, 2BAC BIOF, SM, SP Et SVT, PR JENKAL RACHIDDokument4 SeitenSérie D'exercices 14, Mouvements Plans, 2BAC BIOF, SM, SP Et SVT, PR JENKAL RACHIDNajimou Alade Tidjani100% (4)