Beruflich Dokumente

Kultur Dokumente

Elektronische Musik

Hochgeladen von

mrhi23Copyright

Verfügbare Formate

Dieses Dokument teilen

Dokument teilen oder einbetten

Stufen Sie dieses Dokument als nützlich ein?

Sind diese Inhalte unangemessen?

Dieses Dokument meldenCopyright:

Verfügbare Formate

Elektronische Musik

Hochgeladen von

mrhi23Copyright:

Verfügbare Formate

Jahresarbeit zum Abschluss der 12.

Klasse

an der

Freien Waldorfschule Freiburg-Rieselfeld

vorgelegt von

Pascal Kuri

Im Schuljahr 2013/2014

1

Einfhrung .............................................................................................................. 2

Warum elektronische Musik, warum nicht Computermusik? ............................... 4

Mein Weg zur elektronischen Musik ........................................................................... 6

Elektronische Musik ................................................................................................ 8

Aufbau der Tne und Klnge ....................................................................................... 8

Technische Errungenschaften: Geschichte der elektronischen Musik ...................... 12

Was ist FL Studio? ................................................................................................. 17

Pattern ....................................................................................................................... 19

Das Piano Roll ............................................................................................................ 22

Die Playlist .................................................................................................................. 24

Was ist ein Sample und was ein Loop? ..................................................................... 26

Oszillatoren ................................................................................................................ 28

LFO (Low Frequenzy Oscillator) ................................................................................. 32

VST Plugins ................................................................................................................. 33

Der Mixer ................................................................................................................... 35

Was sind Automation Clips? ...................................................................................... 39

Edit Events ................................................................................................................. 40

Welches Equipment wird wirklich bentigt? ............................................................ 41

Von der Idee zum fertigen Lied .............................................................................. 44

Schluss .................................................................................................................. 50

Glossar ........................................................................................................................ 52

Quellenverzeichnis ..................................................................................................... 59

2

Elektronische Musik, dieser Begriff wird hufig missverstanden. Die Vorstellung,

elektronische Musik bestnde nur aus Techno, House, Dance oder Elektro, ist weit

verbreitet. Da diese nun wirklich recht spezielle, wenn auch inzwischen weit

verbreitete Musikrichtungen sind, kann leicht die Vorstellung aufkommen, sie allein

reprsentierten elektronische Musik. Mittlerweile haben sie ihren festen Platz in der

Vielfalt der Musikrichtungen gefunden und verdienen, wie ich finde, durchaus ihre

Beachtung und sollten genau so geschtzt werden, wie etwa Jazz, Rock oder Klassik.

In der elektronischen Musik gibt es unzhlige Genres mit ihren Subgenres, wie Trip-

Hop, Psychedelic Ambient, Chiptune, Breakbeat, Lo-Fi oder Glitch Hop, die sich alle

durch charakteristische Merkmale unterscheiden. Lo-Fi ist zum Beispiel eine spezielle

Musikrichtung, in der oft das Krakeln von Schallplattennadeln benutzt wird, dabei

werden Sounds verwendet die bersteuert oder Beats die verzerrt sein knnen. Oft

sind Geigen oder Gitarren dabei. Ein wenig kann Lo-Fi als Hip-Hop mit dreckigeren

Beats und verzerrteren Sounds ohne Text betrachtet werden. Hufig werden auch

Filme oder Menschen zitiert. Der Begriff Lo-Fi stammt von Low Fidelity und beschreibt

schlechte Aufnahmen, das Gegenteil von Hi-Fi, also High-Fidelity.

Diese unterschiedlichen Genres sind den Wenigsten bekannt.

Dubstep, Drum & Bass oder Elektro Swing kennt man eher. Ihre Subgenres jedoch,

wie Jump-Up, Darkstep oder intelligent Drum & Bass sind der Masse wieder vllig

fremd.

Natrlich sind Vorurteile diesen speziellen Musikstilen gegenber nicht vllig

grundlos. Elektronische Musik ist, ein wenig wie das Internet, noch relativ neu. Fr

die ltere Generation ist es oftmals schwer, sich vorzustellen, wie diese Musik

zustande kommt. Auch sind ihnen die neuartigen Klnge fremd. Hinzu kommt, dass

ein Groteil der Charts, also der bekanntesten und erfolgreichsten Songs, fast

3

ausschlielich am Computer entstanden ist. Bekanntlich bestehen diese aktuellen

Charts aus einfachsten Melodien und Rhythmen. Die sthetische Vielfalt und der

Reichtum, der durch Synthesizer erzeugten Klnge und der elektronischen Musik,

bleiben damit verborgen.

Eine grundstzliche Abneigung entspringt, meiner Meinung nach, aus Unkenntnis und

Unwissenheit.

Eine weitere Unsicherheit bringen die Begriffe elektroakustische Musik,

Computermusik und elektronische Musik. Welcher dieser Begriffe beschreibt nun

das Komponieren und Vertonen von Musik am Computer?

Die elektroakustische Musik ist eine Art Spielerei mit den Mglichkeiten der

elektronischen Klangerzeugung und der Bearbeitung von akustischen Eindrcken. Es

werden beispielsweise Aufnahmen von Zgen mit Schritten im Schnee vermischt und

elektronisch verzerrt. Nur fr die Wenigsten ist diese Musik wirklich hrenswert und

auch ich zhle mich nicht zu jenen. Zu sehr entsteht der Eindruck, Industrielrm in

seiner unangenehmsten Form wrde zu Kunst erhoben werden. Wer bereits

elektronische Musik als Lrm empfindet, sollte sich von der elektroakustischen Musik

also unbedingt fernhalten, um dadurch in seinem Vorurteil, gegenber elektronischer

Musik nicht noch Besttigung zu finden.

Die elektronische Musik beschreibt Klnge, die mit elektronischen Instrumenten oder

Klangerzeugern erzeugt werden und keine herkmmlichen akustischen Instrumente

verwendet. Auch das Komponieren am Computer knnte also dazugehren.

Tatschlich entwickelte sich daraus der Begriff Computermusik. Dieser wird sogar

auf Wikipedia umfassend beschrieben. Elektronische Musik ist also nur ein

berbegriff fr, unter Anderem, meine Art des Musizierens am Computer.

4

Der Begriff Computermusik ist den Wenigsten bekannt und drfte einige sogar

abschrecken. Auch habe ich das Gefhl, dass Computermusik ein wenig komisch und

nach etwas ganz anderen klingt, als es wirklich ist. Bei Computermusik fehlt der Bezug

zum Komponisten im Begriff. Es entsteht der Eindruck, man habe auf einen Knopf

gedrckt, und der Computer habe direkt ein Ergebnis, ein fertiges Lied, ausgespuckt.

Auch kommt das Gefhl auf, der Computer sei das Instrument. Das ist nicht der Fall.

Da die Instrumente virtuell sind, kann der Computer oder ein Keyboard mit dem

virtuellen Instrument funktionieren, wie die Finger oder der Bogen mit einem

blichen akustischen Instrument, als eine Art Medium.

Das Vorurteil, auf ein paar Knpfe drcken und fertig, ist der grte Feind eines

elektronischen Komponisten. Whrend das Programm Magix Music Maker tatschlich

mit sehr einfachen Mitteln auskommt, ist das bei profitauglichen Programmen

gnzlich anders. Der Weg zum fertigen Lied ist schwer und lang. Ein gutes Lied kann

Monate, wenn nicht sogar ein Jahr bentigen um wirklich ausgereift zu sein. Von der

Idee, zur Gestaltung, ber Instrumentenfindung, den Rhythmus, das Tempo, die

Synthesizerprogrammierung, die Effekte und das Mastering, sind es tausend kleine

Schritte. Man begegnet unterschiedlichsten Arbeitsgebieten, die man kennen oder

kennenlernen und durchschreiten muss. Besonders in meinem Entwicklungsstand ist

dies noch sehr zeitaufwendig. An einzelnen Liedern kann ich so mehrere Stunden am

Tag, monatelang, jeden Tag sitzen und arbeiten. Da ich nebenbei noch einiges

darber lernen muss, ist es nicht ganz so einfach, flssig arbeiten zu knnen.

5

In der heutigen Gesellschaft wird die elektronische Musik viel zu wenig geschtzt und

in ihrer Komplexitt durchgehend in Frage gestellt. Genau wie die CGI Special Effects

bei Kinofilmen, oder die Programmierung von Spielen, wird die elektronische Musik

als schnell und einfach in der Produktion hingestellt, doch allein durch ihre Vielfalt

sollte klar sein, dass dies nicht so einfach ist, wie man es sich vielleicht vorstellt. Wie

knnte es sein, dass zwei vllig unterschiedliche Lieder, beide elektronisch, mit ein

paar Knopfdrcken gemacht wurden? Das ist bereits in der Vorstellung unrealistisch.

Im Praktischen Teil habe ich mich mit dem Komponieren und Fertigstellen zweier

eigener elektronischer Musikstcke beschftigt. Von der Grundidee (Melodie) ber

die Begleitungen, die Instrumente, die Rhythmen, das Mastering usw. entstand alles

aus meinen Vorstellungen und der eigenen Kreativitt. Auch steht mir die Mglichkeit

frei, meine Musik zu vermarkten und damit Geld zu verdienen.

Der theoretische Teil befasst sich berwiegend mit den Grundlagen des Musizierens

mit elektronischen Hilfsmitteln. Des Weiteren werde ich auf die Geschichte der

elektronischen Klangerzeugung eingehen, sowie einige Technologien erklren, ohne

die eine Komposition am Computer berhaupt nicht mglich gewesen wre. Auch

gibt es eine Chronologie der Entstehung meiner Lieder.

6

Seit Ewigkeiten bin ich riesiger Musik- und Filmfan. Durch Musik kann so Vieles

ausgedrckt und transportiert werden, wie man es sich kaum vorstellen kann.

Gefhle aller Art knnen ihren Ausdruck finden, oft auch ganz ohne Gesang.

Instrumentalmusik war mir schon immer die liebste, auch wenn es wirklich gute

Stcke mit Vocals gibt. Als ich dann 13 Jahre alt war, lag, auf meinen Wunsch hin,

unter dem Weihnachtsbaum Virtual DJ. Ein simples Programm, mit dem man

verschiedene Lieder zusammenmischen kann. Auch wenn ich dieses Programm

niemandem empfehlen wrde, hat es mir den Weg in die elektronische Musik

bereitet.

Spter bekam ich Magix Music Maker, mit dem ich monatelang Musik machte und

immer weniger auf Vorlagen und Loops, als auf Samples und virtuelle Instrumente

zurckgriff. 2010 endlich besorgte ich mir FL Studio 9 Signature Bundle und fing

sofort an, Musik zu machen. Natrlich zunchst sehr primitive und einfache Musik die

wirklich ein wenig komisch ist. Auf Youtube kann man unter MrHi23 meine alten

Lieder finden und die Entwicklung nachvollziehen. Nach und nach wurde ich immer

besser und hatte bereits einige Lieder geschafft, auf die ich auch heute noch ein

wenig stolz bin.

Ab Ende 2011 gab es eine groe Lcke. Einige persnliche Grnde hielten mich von

meiner Leidenschaft ab. Erst krzlich fand ich wieder zur eigenen Musik und die

Lieder der Zwlftklassarbeit sind sozusagen mein Comeback. Mit FL Studio 11, einem

Keyboard und Aktiven Nahfeld-Monitoren inklusive Interface ausgerstet, versuche

ich den Sprung von amateurhaft zu etwas Professionellem.

Dass ich elektronische Musik fr meine Zwlftklassarbeit whlen wrde, war nicht

von Anfang an klar. Zu Beginn wollte ich einen Kurzfilm drehen. Alles war bereit, ich

hatte eine Kamera und sogar eine Idee. Optimistisch dachte ich auch, dass es wohl

nicht so schwer sei, ein paar Schauspieler zu finden. Doch die Idee, die ich hatte, war

in dieser Zeit nicht realisierbar und ein absolutes Mammutprojekt. Special Effects

7

htten programmiert und teures Equipment ausgeliehen oder gekauft werden

mssen. Die Idee gefllt mir trotzdem. Nachdem ich genau in dieser Zeit zur Musik

zurckfand, war klar: Ich mache ein Album mit ca. zehn Liedern und zu einem davon

vielleicht noch ein Musikvideo mit kleiner Story. Auch hier hatte ich bereits eine Idee.

Doch die Realitt holte mich ein. Sich in nicht einmal einem Jahr zehn einigermaen

professionelle Lieder auszudenken und zu produzieren, obwohl ich berhaupt keine

Erfahrung mit dem Mastering und den Schritten zu einem wirklich fertigen Track

hatte, war so schon kaum erreichbar. Zustzlich noch ein Musikvideo mit Story zu

drehen, also deutlich zu viel. Lieber wollte ich zwei wirklich gute und wirklich fertige

Lieder haben, als zehn mittelmig gemasterte und insgesamt eher schlechte. So ist

das Album zur Single oder auch einer Kurz-EP geworden, diese entspricht dafr

meinen Anforderungen als Perfektionist.

8

Elektronische Musik unterscheidet sich von normaler Musik vor allem in der

Vorbereitung und Produktion. Es braucht fr die elektronische Musik wesentlich

mehr als monotone Kicks und tiefe Bsse.

nge

Grundstzlich unterscheiden sich die Tne, die von herkmmlichen Instrumenten

erzeugt werden, nicht von den elektronischen. Jedes Gerusch, jeder Ton besteht aus

Schallwellen. Bei gleichmigem Schwingen von Gegenstnden oder Saiten entstehen

diese Schallwellen in gleichbleibender Geschwindigkeit und es kommt ein Ton in

bestimmter Lautstrke und Hhe hrbar heraus. Die Luft, die uns umgibt schwingt

mit und transportiert so die Schallwellen zu unserem Gehr. Aus diesem Grund gibt

es keine Gerusche im All, es gibt keine Stoffe, die die Schwingungen transportieren

knnten.

Im Gehr wird nun das Trommelfell durch Klnge und Gerusche in Schwingung

versetzt und leitet die Informationen an unser Gehirn weiter.

Um diese Schwingungen mit Tnen zu verbinden ist es wichtig zu verstehen, wie

diese bezeichnet werden. Dabei ist es vor allem ntig, zwischen Gerusch und Ton zu

unterscheiden.

Ein Ton besteht in seiner Urform aus einer gleichmigen Welle, dabei kann man sich

am besten eine Gitarrensaite vor sein geistiges Auge holen und zupfen. Da das

menschliche Auge ein wenig trge fr Bewegungen ist, sehen wir nur, dass die Saite

schwingt. Bei extremer Verlangsamung knnen wir nun die Wellenform erkennen, die

die Saite immer wieder durchluft. Sie geht auf und ab.

9

Diese Welle hat immer eine bestimmte Geschwindigkeit und wird in Schwingungen

pro Sekunde, kurz Hertz gemessen. An der Hertzzahl kann man die Tonhhe

erkennen. Bei 100Hz (Hertz) geht die Schwingung 100-mal in der Sekunde auf und ab.

1kHz (Kilohertz) entspricht 1000Hz. Die Zahl im Zusammenhang mit den Hertz wird

auch Frequenz genannt. Das menschliche Ohr kann durchschnittlich Frequenzen von

20Hz bis zu 20kHz (also 20 000Hz) hren. Den fr uns nicht hrbaren Bereich unter

20Hz nennt man Infraschall, ihn senden z.B. Wale aus. Auch wenn wir diese nicht

hren knnen, auf unseren hrbaren Bereich hinaufgestuft, senden diese Tiere die

lautesten Gerusche, die je ein Tier oder Mensch von sich geben kann. Da Infraschall

sehr langsam schwingt, kann man ihn durchaus erkennen, auch auditiv. Dabei hren

wir keine Tne, sondern empfinden nur die Schwingung an sich, hnlich wie einen

regelmigen Windsto.

Anders herum, alles was ber 20kHz schallt, ist fr uns auch nicht hrbar und wird

Ultraschall genannt. Hufig verwenden bestimmte Tiere Ultraschall. Echoortung

beschreibt das Orientieren mithilfe von Ultraschall. Das bekannteste Beispiel ist die

Fledermaus, sie bringt Frequenzen bis zu 200kHz zum schwingen und orientiert sich

am Echo, welches z.B. Bume zurckwerfen. So kann sie Beute orten und Gefahren

ausweichen. Bei Ratten konnte bei 50kHz ein sozialeres Verhalten nachgewiesen

werden. So bekamen diese ein steigendes Annherungsverhalten unter Einwirkung

dieser Ultraschallfrequenz.

In einem einfachen Internettest (egopont.com) konnte ich Frequenzen von ca. 30Hz

bis zu 19kHz deutlich hren. Jedoch hngt dieses Vermgen stark vom Alter und der

Belastung des Gehrs ab. So knnen Kleinkinder Ultraschall hufig noch hren,

verlieren diese Gabe jedoch bereits mit etwa fnf Jahren. Mit ca. 18 Jahren knnen

die meisten nur noch bis 16kHz hren und die hheren Tne nicht mehr

wahrnehmen. Im Alter reduziert sich also unser Hrspektrum, deshalb wird oft

bereits ab 16kHz von Ultraschall gesprochen, eigentlich sind jedoch 20kHz der

Standartwert.

10

Um die Schwingungen noch einmal zu verdeutlichen, gibt es hier ein Beispiel mit

einer Stimmgabel. (Abb.

1

)

In dem Moment, in

dem die Gabel in

Schwingung versetzt

wird, versetzt diese die

umliegende Luft, in der

selber Frequenz in

Schwingung. Das Hin

und Her beim Schall ist,

wie auf dem Bild

erkennbar, ein

Zusammenspiel aus

erhhtem und

verringertem Druck.

Der hier gezeigte Ton jedoch, liee sich ganz einfach als elektronischer Sinuston

identifizieren, da er keine Obertne oder weitere Klnge besitzt. Wenn der Schall,

eine sich nicht verndernde Schwingungsperiode besitzt, und aus einer einzigen

Welle besteht, spricht man in der Physik von einem reinen Ton. Der Klang ist

bekanntlich ein Zusammenspiel von mehreren Tnen, meist sind es Akkorde, welche

zusammen ein bestimmtes Klangmuster ergeben. Der Klang ist in der Wellenform

vllig anders als der Ton und, je nach Anzahl der Tne, weitaus komplexer.

Gehrtechnisch ist der Unterschied relativ klar und deutlich hrbar. Auch physisch,

und dadurch auch visuell, verndert sich das Bild der Schallwelle. Nachfolgend ein

Beispiel mit einem reinen Ton im Vergleich zu einem Klang einer Geige in a gestimmt

(440Hz).

1

Quelle Abbildung:

akustik.tu-berlin.de/fileadmin/fg23/Lehre/Lehre/Raumbauakustik/Abschn_1_PhysikGrundlg.pdf (Jan. 2014)

11

(Abb.

2

)

Auf der linken Seite ist der Vergleich als Schallwellenmuster abgebildet, der Klang der

Geige (unten) ist deutlich komplexer, obwohl er in der gleichen Frequenz (440Hz)

schwingt. Auf der rechten Seite ist das Spektrum der Geigensaite mit ihren

Obertnen veranschaulicht. Diese Obertne machen die Vernderung vom Ton zum

Klang aus. Auffllig wird, dass die Obertne mit steigender Frequenz immer leiser

werden, dies geht theoretisch bis hin zum Unendlichen und lsst sich mathematisch

berechnen. Eine einzelne Saite schwingt somit in unendlich vielen Frequenzen auf

einmal, das macht es unter Anderem so schwer, natrliche Instrumente elektronisch

zu imitieren.

Nach dem Klang folgt das Gerusch, es ist eine zufllig auftretende Schallwelle, ohne

Regelmigkeiten. In der elektronischen Musik werden Gerusche beispielsweise bei

der Imitation von Flten verwendet. Vor allem jedoch bei Perkussion und

elektronischen Drum Kits werden Gerusche oft auch recht dominierend benutzt. Um

einem Querfltensolo etwas mehr Leben einzuhauchen, werden zum Beispiel leisere

2

Quelle Abbildung:

http://www.laermorama.ch/m1_akustik/oszillogramm.html (Jan. 2014)

12

Gerusche verwendet, um Atmung zu imitieren. Musik unterscheiden wir von

Geruschen vor allem also durch das Vorhandensein von Tnen. Die Lautstrke eines

Klanges oder eines Gerusches wird Amplitude genannt. Eine Schallwelle, die nur

ganz schwach vom Nullpunkt auf und ab schwingt, ist leise. Bei starker Aussteuerung

ist das Resultat lauter, die Amplitude strker.

Niemals htte ich gedacht, dass die Entstehungsgeschichte der elektronischen Musik

so interessant ist, wie kaum eine andere. Von den allerersten Schritten, bis hin zu

heutigen Entwicklungen, gibt es immer spannende Instrumente und schlaue Kpfe

hinter den Instrumenten der elektrischen Ton- und Geruscherzeugung mit

unglaublich interessanten Ideen.

Bevor es um wirkliche, elektronische Musik geht, kommen wir zu den elektronischen

Klangerzeugern und Instrumenten. Prokop Divi (1698-1765) u.a. auch der Erfinder

des Blitzableiters, interessierte sich besonders fr die Elektronik und stellte bereits

um 1730 herum seine Erfindung, das Mutationsorchestrion Denis dor, vor. Es

existierte nur ein einziges Exemplar und es soll mit 790 Saiten gearbeitet haben.

Mithilfe von 130 elektronischen Registern soll nun eine Modifikation an den Saiten

und den Klngen mglich gewesen sein. Das soll soweit gereicht haben, dass bliche

Blser- und Streicherinstrumente imitiert werden konnten. Der Erfinder Prokop Divi

baute einen kleinen Scherz ein, der dem Musizierenden einen schwachen

elektrischen Schlag gab, wann er es wollte. Jedoch ist dieses Instrument nur fr die

Modifikation der Tne brauchbar gewesen und konnte keine eigenen erzeugen.

Deshalb gilt es nicht als elektronisches Musikinstrument.

1761 stellte Jean-Baptiste Thillaie Delaborde (1730-1777), ein franzsischer Priester,

seine Clavecin lectrique, ein neues Musikinstrument, das mit Elektronik arbeitete,

13

vor. Es war im Wesentlichen ein Glockenspiel, basierend auf Warnglocken. Es ist

etwas schwer zu erklren und zu verstehen, wie das Clavecin lectrique berhaupt

funktionierte. Zwei Glocken fr jeden Ton, eine geerdet, eine ungeerdet bringen

einen Klppel dazwischen in der gewnschten Geschwindigkeit und damit auch

Tonhhe zum schwingen. Weitere Beschreibungen sind wirklich kompliziert.

Nach einem groen Loch in der Geschichte geht es erst am Ende des 19. Jahrhunderts

mit der Entwicklung weiter. 1897 stellte Thaddeus Cahill (1867-1934) sein

Dynamophon vor. Das erste richtige, elektronische Musikinstrument. Es erlangte

schnell Beliebtheit und war mit einem einzigartigen Klang ausgestattet. Zu dieser Zeit

erschien das Dynamophon, besser bekannt als Telharmonium, noch wie Science

Fiktion und ein vllig neues Klangerlebnis. Es sorgte fr einigen Gesprchsstoff und

wurde hufig in Zeitschriften beschrieben. Im Allgemeinen wird der Klang wie der

einer elektronischen Orgel, etwas gemischt mit einem Leierkasten (Drehorgel)

beschrieben. Das Telharmonium war jedoch gigantisch und wog ca. 200 Tonnen. Es

war und ist bis heute, das grte Musikinstrument, welches je gebaut wurde. Somit

war es nicht besonders mobil und es konnten nicht sehr viele Menschen in den

Genuss kommen, es zu sehen und spielen zu hren. ber Telefonleitungen konnte es

nach Wunsch empfangen werden. Auch hier ist es kompliziert, den genauen Aufbau

zu verstehen und wiederzugeben. Es besteht im Groben aus Zahnrdern mit je einem

zugeordneten Ton, je nach Zackenanzahl und Drehzahl verndert sich dieser Ton von

Zahnrad zu Zahnrad. Leider wurden die einzigen zwei Telharmonien zerstrt und

hinterlieen keine Video- oder Tonaufnahmen. Es wurde auf Grund seiner Gre und

der Tatsache, dass das Telefonnetz durch bermiges Interesse zusammenstrzte

nicht weiterentwickelt. Der Erfinder arbeitete zunchst an der Vermarktung seines

Dynamophons, wechselte dann jedoch aus dem Grund der Telefonbertragung seine

Ideen. Auch die erste elektrische Schreibmaschine ist auf ihn zurckzufhren.

Thaddeus Cahill gilt durch sein Dynamophon als ein Pionier der elektronischen

Musikproduktion. Er erkannte das Potenzial und wandelte es in die Tat um.

14

In diesem Raum konnte der Musizierende sein Telharmonium spielen. Von den

Ausmaen, die dieses annimmt, bekommt man auf diesem Bild nichts mit, denn der

Rest des Instrumentes, der eigentliche Hauptteil, befand sich im Nebenraum.

(Abb.

4

)

3

,

4

Quelle Abb. http://www.flickr.com/photos/stephenhill/galleries/72157628449186983/ (Jan. 2014)

15

(Abb.

5

)

Die Komplexitt wird auf

diesen Bildern schnell klar,

was einem heutigen

Serverraum gleicht, ist nur

ein Teil eines einzigartigen

Instrumentes, welches ber

zwei Rume verteilt arbeitet.

Bald wurden die ersten Oszillatoren fr die Musik erfunden, sie sind bis heute das

Fundament eines jeden elektronischen Instruments.

Das Theremin basiert auf dem Prinzip von normalen Antennen, davon besitzt es zwei

Stck. Eine vertikale Antenne bestimmt die Tonhhe und eine horizontale die

Lautstrke. Ein Oszillator vertont die empfangenen Signale. Der Musizierende benutzt

beide Hnde und kann mit Hilfe des Magnetfeldes vllig berhrungslos spielen. Auch

wenn das Theremin strahlt, ist diese Strahlung deutlich reichweitenbeschrnkt und

insgesamt viel schwcher als die eines Handys (Verhltnis ca. 1:1000) und damit

deutlich weniger schdlich. Erfunden wurde es von Leon Theremin, dem wir auch

einige andere Erfindungen in der elektronischen Musik zu verdanken haben. Leon

Theremin wurde 1896 in Sankt Petersburg geboren und verstarb 1993 in Moskau. Mit

der Erfindung des Theremins gilt er als einer der wichtigsten Pioniere der

elektronischen Musik und Klangerzeugung durch Synthesizer und Drumcomputer. Er

entwickelte sein Theremin weiter und erfand einige Instrument wie das

Theremincello und das Terpsiton, welches Bewegungen des gesamten Krpers in

Tne umwandelt. Heutzutage gibt es in etwa zehn professionelle Thereminspieler,

5

Quelle Abb.

http://www.flickr.com/photos/stephenhill/galleries/72157628449186983/ (Jan. 2014)

16

die das Instrument wirklich gut bedienen knnen. Einige Erfindungen wie das

Sphrophon, das Ondes Martenot und das Trautonium basieren auf dem Theremin

und werden also nur am Rande erwhnt.

Der nchste groe Schritt ist die Hammond Orgel, sie ist die kleinere Version eines

Telharmoniums, welches damals gigantische Mae hatte. Laurens Hammond (1895

1973) brachte seine nach ihm benannte Hammond Orgel 1934 auf den Markt. Sie

wurde sofort ein kommerzieller Erfolg. Die Idee, Pfeifenorgeln zu ersetzen, wurde

jedoch nicht wahrgenommen und die Orgel wurde nicht in Kirchen, sondern

berwiegend im Jazz verwendet. Einige Jazzberhmtheiten wie Fats Waller, Jimmy

Smith, Keith Emerson usw. verwendeten die Hammond Orgel regelmig. Sie hat

einen unverwechselbaren Klang und wird deshalb noch Heute, viele Jahre nach

Einstellung der Produktion, gehandelt und von Sammlern und Liebhabern gerne

gekauft.

17

Das FL Studio ist bei meiner Form der Musikproduktion, der Hauptbestandteil und

das Fundament fr meine elektronische Musik. Mit FL Studio lsst sich komponieren,

abmischen und aufnehmen. Die Aufnahmen lassen sich beliebig bearbeiten und

knnen direkt als Mp3 oder als ein anderes Audioformat exportiert werden. FL

Studio, die Abkrzung fr Fruity Loops Studio, ist nur eines von vielen

Musikprogrammen fr den PC, weitere sind Cubase von Steinberg oder Magix

Samplitude.

Die Anwendungsbereiche unterscheiden sich in vielerlei Hinsicht, wobei Cubase und

FL Studio einige hnlichkeiten aufweisen.

Das einfachste Programm, Magix Music Maker, hat zwar einen eher geringen

kreativen Wert, ist zum Einstieg in das Komponieren elektronischer Musik aber

bestens geeignet. Magix Music Maker wurde 1994 auf den Markt gebracht und ist

seitdem die erfolgreichste Musiksoftware weltweit. Der Anwender benutzt

sogenannte Loops, das sind kurze Takte Musik, beispielsweise ein Beat, also eine

Schlagzeugsequenz, die man in der Dauerschleife ohne Brche hren kann. Diese fgt

er zu einem Song zusammen. Im Internet gibt es eine unendliche Anzahl an

kostenlosen, sowie kostenpflichtigen Loops, sodass der Benutzer groe

Wahlmglichkeiten hat. Die Kreativitt beschrnkt sich hier auf das Mischen von

diesen Loops, so kann man Hip-Hop Elemente mit Techno oder sogar Klassik

verbinden. So ist Magix Music Maker zwar kein vollwertiges Programm durch das

man stolz sagen kann: Das ist mein Song., man kann jedoch die Dramatik eines

Liedes gestalten lernen. Das Programm bietet zwar die Mglichkeit, eigene Melodien

zu entwerfen, ist jedoch in der Ausfhrung und Umsetzung dieser Melodien sehr

beschrnkt, und vor allem das Mastering bentigt einige weitere Funktionen, um als

wirklich professionell gelten zu knnen. Zu viel ist noch automatisiert. Trotzdem

wrde ich es als Einsteigerprogramm, vor allem fr jngere Beginner durchaus

empfehlen. Fr die professionelle Musikproduktion ist Magix Music Maker also nicht

geeignet.

18

Den grten Lerneffekt, den Magix Music Maker bieten kann, stellt fr mich der

Spannungsbogen in einem Lied dar. Denn auch als unplugged Musiker, also ohne

elektronische Hilfsmittel, kann man eine noch so tolle Melodie erschaffen und

trotzdem ein sterbenslangweiliges Lied als Produkt erhalten, wenn die Gestaltung

nicht stimmt.

Der groe Bruder, Magix Samplitude, ist die konsequente Weiterfhrung von Magix

Music Maker und fr professionelle Produktionen geeignet, jedoch sieht, fr meinen

Geschmack, die optische Darstellung am PC ein wenig zu bunt und verwirrend aus.

Ausserdem ist Samplitude um ein Vielfaches teurer als das, meiner Meinung nach,

hherwertige FL Studio.

Ein weiteres Programm ist Logic Pro. Es wird besonders in der professionellen

Technoproduktion benutzt und ist fr Apple Computer konzipiert und damit fr PC

User nicht oder kaum zugnglich.

Cubase ist vor allem fr die Aufnahme von Instrumenten und zum Mastering, sowie

fr das Bearbeiten der Aufnahmen und somit weniger zum eigenen Komponieren, als

zum Vervollstndigen eines Songs konzipiert.

FL Studio wird in allen Bereichen und Musikrichtungen verwendet und ist somit

barrierefrei und fr den Einstieg, sowie die professionelle Produktion gleichermaen

geeignet. Einige bekannte Knstler wie Afrojack, Avicii, sowie Timbaland benutzen FL

Studio fr ihre Musik. Es ist auch fr das berufliche Komponieren von elektronischer

Musik nutzbar.

19

FL Studio basiert auf dem sogenannten Patternsystem, das fr mich logischste und

am einfachsten nachvollziehbare System in der elektronischen Musikproduktion. Es

ist fr meine Bedrfnisse das Beste.

6

Quelle Abbildung:

Eigener Screenshot eines meiner elektronischen Lieder in frhem Stadium

20

Pattern kommt, wie die meisten Begriffe in der elektronischen Musik, aus dem

Englischen und bedeutet wrtlich bersetzt Muster. Ein in FL Studio komponiertes

Lied setzt sich unter Anderem aus einer Vielzahl von Pattern zusammen, welche der

Komponist zuerst programmiert und anschlieend wie Loops zu seinem fertigen

Song zusammenfgen kann. Die Patterns sind also der Teil an dem am hufigsten, vor

allem zu Beginn der Produktion, gearbeitet wird.

Im Schaubild (Abb. 1) links oben in der Ecke wird der Takt eingestellt (1). In diesem

Fall ist es ein 12/4 Takt. Von -- (also 0) bis 64 gibt es keine Einschrnkungen in der

Taktart. Heutzutage sind die meisten Lieder in einem 4/4 Takt komponiert, das ist das

einfachste und einprgsamste Format fr Laien und vor allem fr einfache

Musikkonsumenten. Der 8/4 Takt hnelt dem 4/4 Takt sehr, er ist genau doppelt so

lang und fr lngere Melodien geeignet. Ein Song im 4/4 Takt kann jedoch auch mit

8/4 Patterns gemacht werden. Die Taktart wird fr jedes Pattern neu eingestellt und

kann von Pattern zu Pattern variieren. So kann man beispielsweise in ein Techno Lied,

das so gut wie immer einen 4/4 Takt besitzt, einen Ambient Break, einen komplett

andersartigen Teil im sonst fortlaufenden Lied, einbauen. Dieser kann deutlich

verlangsamt und in einem typischen Takt fr Ambient gehalten sein. Ausgefallene

Rhythmusnderungen sind damit am besten mglich. Die Angabe erfolgt immer in

Vierteln.

Rechts neben dem Taktwhler ist ein Button um den sogenannten Step-Sequenzer bei

der Wiedergabe zu wiederholen (2).

Der Wiedergabebutton fr das einzelne Pattern befindet sich weiter rechts, gefolgt

von der Option den Namen und die Farbe des Patterns zu ndern (das kleine +).

Klickt man auf den aktuellen Patternnamen oder das dazugehrige Dreieck (3),

erscheint ein Scrolldownmen, also ein sich aufklappendes oder ausfahrendes Men

mit dazugehrigen Optionen.

Auf der gleichen Hhe befindet sich noch ein Swing-Regler, den ich noch nie

benutzt habe, geschweige denn Informationen darber herausfinden konnte. Beim

Herumspielen konnte ich auch keine bedeutenden nderungen feststellen.

21

Der Graph- und der Keyboard Editor (4) verlangen eine vorhergehende Erklrung

einiger anderer Elemente.

Der Step-Sequenzer ist berwiegend fr die Rhythmuselemente im Lied zustndig.

Das Pattern ist nur die Zahl oder der Name des Step-Sequenzers. Bei jedem Pattern

kann der Step-Sequenzer unabhngig von allen anderen verndert werden. Das

Prinzip ist recht einfach. Die Zeit vergeht von links nach rechts und die Taktschlge

sind abwechselnd kaminrot und graublau gefrbt. Auf ein Viertel kommen vier Steps.

Diese Steps haben zwei Mglichkeiten, sie sind an oder aus

Bei den Steps gilt: an bedeutet, das Sample wird gespielt und aus, das Sample wird

nicht gespielt. Alle Instrumente und beispielsweise Kicks, Snares, Hi-Hats etc.

werden, bevor sie genutzt werden knnen, in das Pattern geladen und erscheinen als

neue Reihe im Step-Sequenzer (5). Jede Reihe bietet noch die Mglichkeiten (von

links nach rechts) de- oder aktiviert zu werden. Ausserdem kann die Balance vom

linken und rechten Lautsprecher verndert und die vorlufige Lautstrke eingestellt

werden. An diesen Reglern sollte man jedoch vorsichtig sein, da diese sich auf jedes

Pattern bertragen.

Der Graph Editor (4) hlt nun einige weiterfhrende Optionen fr die aktuell

angewhlte Reihe im Pattern bereit. In ihm kann man einzelne Teile in der Dauer des

Step-Sequenzers lauter oder leiser schalten und das Gleiche mit der Balance und

einem feinen Pitch machen. Der Pitch ist die Tonhhe in dem das Instrument erklingt

und der feine Pitch ist eine sehr przise Feineinstellung des Pitches.

Der Keyboard Editor (4) rechts davon lsst die Hhe jedes einzelnen Steps im Step-

Sequenzer bearbeiten und fhrt zur aktuell angewhlten Reihe zu jedem Step eine

winzige hochkantige Klaviertastatur aus. Mit einem Rechtsklick auf das jeweilige

Instrument bekommt man unter Anderem die Funktion, es im Piano Roll zu

bearbeiten. Dadurch wird fr dieses Instrument der Step-Sequenzer deaktiviert und

auch optisch verndert sich die dazugehrige Reihe (Bsp. 6). Sie zeigt die Hhen und

die zeitlichen Positionen der einzelnen Tne aus dem Piano Roll an.

22

Im Piano Roll, entstehen die Melodien und Differenzen in Tonhhen und Lngen. Das

Instrument, welches in den Step-Sequenzer geladen wurde, kann hier ohne

Einschrnkungen gespielt werden. Auch hier vergeht die Zeit von links nach rechts.

Anhand des Positionsmarkers (1) kann man die Position in der Zeit erkennen. Am

7

Quelle Abb.

Eigener Screenshot eines meiner Lieder mit dem VSTi Wasp XT mit dem modifizierten Preset Wired Saw

23

linken Rand des Piano Rolls ist eine Klaviertastatur hochkant mit Notennamen und

Nummern abgebildet (2).

Am Namen kann man die Tonart und an der Nummer die Oktave des Tones erkennen

und mit einem Linksklick auf dem Noteneditor festlegen. Mit dem Linksklick erscheint

ein grner Balken an der gewnschten Stelle in der letztbenutzen Lnge (z.B 3).

Dieser Balken steht fr einen Ton, er ist auch im Nachhinein vllig mobil und

verschiebbar. Mit der gedrckten linken Maustaste, kann man diesen nun auf und ab

(Tonhhe) und hin und her (zeitliche Position) bewegen. Am linken Rand eines jeden

Balkens kann man seine Lnge verndern.

In der linken oberen Ecke stehen weitere Optionen und Werkzeuge zur Verfgung (4

von links nach rechts). Das Dreieck verweist wieder auf ein Scroll-down-Men und

bringt weiterfhrende Optionen, unter anderem Akkorde zu generieren und

wiederholt aber auch einige Werkzeuge von den folgenden:

Das Werkzeug-Symbol birgt Optionen, die dem Komponisten etwas unter die Arme

greifen. Es lsst auch den Ton an sich bearbeiten. Jedoch wird diese Option von mir

so gut wie nicht benutzt.

Nun kommt das Magnetsymbol. Dieses ist sehr hilfreich und wird von mir regelmig

genutzt. Beim Verschieben oder Verlngern der Tne versucht man meist genau im

Takt zum Lied zu bleiben, das Magnetsymbol fhrt nun beim Anklicken Optionen fr

das Springen der Noten in bestimmten Abstnden aus. Das Raster, welches ber den

gesamten Noteneditor verteilt ist, gibt darber weitere Auskunft. Man kann auf diese

Weise auswhlen, ob die Noten nicht springen (None), oder z.B. in einem Abstand

von einem Step springen und somit die Notenpositionen und -lngen schnell finden.

Bei der Verlngerung oder Verschiebung springt der Ton nun um den gewhlten

Abstand.

Das Stiftsymbol ist das erste, welches Auswirkungen auf den Cursor hat. Mit dem Stift

schreibt (mit rechts lscht) man Tne, mit dem Pinsel kann man viele Tne mit

gehaltener Maustaste schreiben, und mit dem Lschsymbol lscht man. Der

durchgestrichene Lautsprecher lsst Angewhltes stummschalten. Dann folgt eine Art

Kuttermesser, mit ihm kann man Tne zerstckeln. Darauf folgt die Anwhlfunktion

24

und zuletzt der Lautsprecher mit dem man wiedergeben kann, was man mit der Maus

anwhlt.

Diese ganzen Funktionen lassen sich jedoch viel leichter und schneller ber

Tastaturbefehle ansteuern. Bei fast allen Musik- Foto- und Filmprogrammen gilt, je

weniger die Maus und je mehr die Tastatur benutzt wird, desto schneller kann man in

einen flieenden Workflow kommen und sich damit auf das Wesentliche, das

Kreative konzentrieren.

Nachdem man die Patterns mit den gewnschten Melodien und Rhythmen gefllt

hat, kommt es zum zusammensetzen der Puzzleteile und somit, hnlich wie bei Magix

Music Maker, zur Dramatik des Stcks.

In der Playlist wird nach und nach, grtenteils aus den Patterns, das Endprodukt

zusammengestellt. Nachdem die Patterns einigermaen fertiggestellt sind, knnen

diese in die Playlist geladen und beliebig vermischt, geschnitten und gekrzt werden.

Die Playlist funktioniert hnlich dem Piano Roll. Mit einem Linksklick fgt man ein

Pattern in die Playlist ein. Mit gedrckter linker Maustaste kann das Pattern nun, wie

der Ton im Piano Roll, in der Zeit hin und her verschoben werden. Das Auf- und Ab-

verschieben der Pattern, dient lediglich der Ordnung. Sowohl in den Patterns, wie in

der Playlist, kann oben, mittig zwischen den Pattern hin- und hergewechselt werden.

In der Playlist, kann damit das gewnschte Pattern ausgewhlt und eingefgt werden.

Die Spuren werden als Tracks bezeichnet, deren Namen und Farbe man immer

ndern und das Ganze somit deutlich bersichtlicher gestalten kann. Da die Playlist

besonders zum Ende hin noch mit Effekten aus dem Mixer gefllt wird, ist es ratsam,

diese immer geordnet zu halten und zu beschriften, um vor allem sptere

nderungen, ohne lstiges Suchen, vornehmen zu knnen.

25

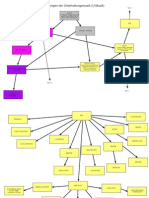

Dieses Schaubild zeigt die Grundfenster. Zu sehen ist darauf das Pattern mit

dem Step-Sequenzer, rechts davon der Mixer. Darunter die Playlist, die die

ganzen Ideen zu einem fertigen Lied zusammenstellen lsst und unten das

Piano Roll. Links an der Seite, der Browser. Mit gedrckter linker Maustaste

lassen sich die Dateien aus dem Browser als neues Instrument in das

Pattern/den Step-Sequenzer oder als einzelne Sounds in die Playlist laden.

8

Quelle Abbildung

Eigener Screenshot mit den geffneten Hauptfenstern in FL Studio

26

Samples sind winzige Audiofiles, also Sounddateien, die beispielsweise ein Kick

(Basstrommel) darstellen knnen. Ich benutze Samples in meinen Songs fast

ausschlielich fr Drums und Percussion.

Sample kommt aus dem Englischen und bedeutet Probe oder Beispiel. Eigentlich wird

in der Musik jedoch zwischen Loop und Sample unterschieden. Whrend der Loop ein

Takt ist, der wiederholt, meist ohne Brche, gespielt und verwendet werden kann,

besteht das Sample aus einem einzigen Schlag und kann so wie ein Teil eines

Schlagzeuges benutzt werden. Tatschlich kann man sich im Internet Schlagzeuge

auch als Sample Packs (also Sample Sammlungen) oder, als Drum Kit kaufen oder

kostenlos herunterladen; manchmal sogar bestimmte, auch real existierende

Schlagzeug Sets. Eine andere Form, in der ich Samples verwende, ist als FX oder SFX.

Das sind Sound Effekte, wie zum Beispiel eine wild redende Menschenmenge, ein

startendes Auto oder vllig elektronische Sounds, die nichts mit Instrumenten

gemein haben. Samples knnen sogar gezupfte Seiten einer Gitarre in einer

bestimmten Tonhhe sein.

Samples unterscheiden sich auditiv und visuell von Loops.

9

Quelle Abb.

Kick Sample in FL Studio geladen, eigener, herausgeschnittener Screenshot

27

Diese Abbildung zeigt ein Sample eines Basskicks. Von links nach rechts sieht man den

``Knall abklingen und die Aussteuerung verringert sich bis zum Nullpunkt. Die

Gesamtlnge dieses Samples betrgt zwei Sekunden, wovon ca. 1,5 Sekunden

absolute Stille sind.

Samples knnen in ihrer Lnge unbegrenzt variieren und sind nicht unbedingt

rhythmusgebunden. Sobald aber eine sich, ohne starke Brche, wiederholende

Melodie oder ein Rhythmus hinzukommt, spricht man von einem Loop.

Loops sind, im Gegensatz zu Samples, kleine Melodiestcke oder Rhythmusteile. Man

kann also aus mehreren Samples oder sogar aus einem, immer wiederkehrenden,

Sample einen Loop kreieren (z.B. Basskick fr einen Dancesong). Auch hier kann man

an der Aussteuerung deutlich die Kicks, Claps o.. erkennen und somit mit etwas

Knnen an einem Loop herumschneiden und ihn vllig verndern.

Der wohl bekannteste Loop, weltweit, ist der Amen Break. Die groen

Aussteuerungen sind die Snares und die Kicks. Die Kicks setzen ab der Hlfte aus. Die

kleinen Aussteuerungen sind die Hi-Hats. Die groe Aussteuerung am Ende ist ein

Becken (engl. Cymbal). Wenn man nun diesen Loop direkt, ohne Lcke fortlaufen

lassen wrde, knnte man ihn unendlich oft wiederholen und eine Melodie dazu

spielen, oder ihn auch mit anderen Loops kombinieren (Magix Music Maker).

Die Lnge des Loops kann nur stufenweise variieren. Wenn Magix Music Maker oder

FL Studio einen Loop erkennt, wird er automatisch an die Schnelligkeit angepasst.

Jedoch muss er klar einen Takt haben z.B. 4/4, 7/8, 12/8, um zum Rest des Projektes

10

Quelle Abb.

Der legendre Amen Break geladen und aus eigenem Screenshot herausgeschnitten

28

zu passen. Ich benutze nur sehr selten Loops, denn die Kreativitt ist eingeschrnkt.

Lediglich den Amen Break wrde ich benutzen, um eine kleine Hommage an

Breakbeat und Soul zu gestalten. Im praktischen Teil der Arbeit habe ich keine Loops

in meinen Liedern. Sie sind komplett selbstproduziert.

Ein Oszillator ist grob gesehen der elektronische Schwingkrper. Er erstellt elektrische

Schwingungen, welche schlielich auf die Lautsprecher bertragen werden. Das Wort

wird abgeleitet von dem lateinischen Oscillare, was so viel wie schwingen bedeutet.

In der Physik werden auch sogenannte Oszillatoren verwendet um bestimmte

Ablufe zu visualisieren. Die elektronischen Impulse, bzw. die Schallwellen knnen im

Gegensatz zu denen akustischer Instrumente vllig barrierefrei bearbeitet werden.

Die blichen Standarts sind zu Beginn die natrliche Sinuswelle. Sie ist vor allem

durch ihren weichen Klang erkennbar und ist die angenehmste fr unser

menschliches Ohr. Hufig wird diese fr extrem tiefe Bsse (Sub Bass) oder Science

Fiktion Melodien verwendet

11

Quelle Abb.

http://www.analogeklangsynthese.de/analog/sine.html (Jan. 2014)

29

Diese Welle sieht noch recht natrlich aus, die folgenden knnen in dieser Form

jedoch nur schwer ohne Elektronik realisiert werden. Die Sinuswelle wird vor allem

fr die Erzeugung von Bass- und Orgelklngen verwendet.

Die Sgezahnwelle hrt sich in jeder Tonhhe in ihrer Grundform elektronisch an und

hat im Klang eine eher technische sthetik. Sie hat einen deutlich grberen Charakter

und wird, wie sie hier gezeigt ist, gerne in hrteren Elektro- oder Technotracks

verwendet. Ausserdem wird sie im Zusammenspiel mit anderen Wellenformen bei

der Erzeugung von Streichern, E-Gitarren oder Bssen genutzt. Auf diesem

Beispielbild ist eine von zwei Mglichkeiten einer Sgezahnwelle aufgefhrt. Diese ist

steigend, von links nach rechts steigt die Welle linear. Eine abwrts steigende

Sgezahnwelle macht dies anders herum.

12

Quelle Abb.

http://www.analogeklangsynthese.de/analog/saw.html (Jan. 2014)

30

Die Dreieckswelle ist etwas hrter als die Sinuswelle, jedoch lange nicht so grob wie

der Sgezahn. Bei der Erzeugung von fltenartigen Sounds wird diese gerne

verwendet.

Die Rechteckwelle ist die, die am strksten nach Elektronik klingt und vor allem im

LFO fr Chiptune, gerne verwendet wird. Sie ist wie ein pltzlich wechselndes An und

Aus. Vom berdruck geht es ohne bergang zum Unterdruck.

13

Quelle Abb. http://www.analogeklangsynthese.de/analog/triangle.html (Jan. 2014)

14

Quelle Abb. http://www.analogeklangsynthese.de/analog/square.html (Jan. 2014)

31

Das Rauschen ist das sogenannte Chaos bei Wellen und rein zufllig. Es besteht aus

einer Unzahl von verschiedenen Frequenzen und verndert sich durchgehend. Es wird

grundstzlich in drei Kategorien eingeteilt:

Weies Rauschen enthlt alle Frequenzen in gleicher Lautstrke. Fr mich hrt es sich

ein wenig wie der Soundeffekt in einem unendlich groen Raum, unendliche Weiten

und ein ewiger Hall, der sich nie wiederholt.

Rosa Rauschen hrt sich da bereits deutlich hrter an und beinhaltet tiefe

Frequenzen, die hheren werden abgeschwcht. Dieses Rauschen ist typisch bei FM

Radios ohne Empfang.

Blaues Rauschen ist das genaue Gegenteil von rosa Rauschen und ist somit sehr hell

und knnte wie ein laut aufgedrehter Verstrker ohne Signalquelle beschrieben

werden. Ein nicht sehr penetrantes, eher durchgehend existierendes Rauschen.

Mithilfe dieser Wellenformen, lassen sich alle mglichen, vorstellbaren Tne, Klnge

und Gerusche erstellen oder imitieren. Vor allem das Erstellen neuer Sounds ist

wirklich unvorstellbar spannend und interessant, man kann Klnge erzeugen, die

noch nie jemand so gehrt hat.

15

Quelle Abb. http://www.analogeklangsynthese.de/analog/noise.html (Jan. 2014)

32

Der LFO ist ein wichtiges Utensil in jedem elektronischen Musikprogramm und darf

nicht fehlen. Der Low Frequency Oscillator bedeutet wrtlich bersetzt

Niederfrequenzoszillator. Genau das macht er auch. Der LFO sendet die gleichen

elektronischen Impulse aus, wie der Oszillator, jedoch im absolut niederfrequenten

Bereich, im Bereich des Infraschalls. Erst, wenn dieser einen Zusammenhang mit

einem bereits existierenden Instrument herstellt, kann er hrbar gemacht werden.

LFOs knnen nun auf eine bestimmte Eigenschaft bertagen werden. So kann man

den LFO unter anderem auf die Lautstrke oder die Verzerrung anwenden. In der

gewnschten Wellenform und Frequenz moduliert der LFO nun den gewhlten Effekt.

Hufig wird der LFO vor allem im Dubstep verwendet, um den typischen Wobble Bass

zu kreieren. Auerdem wird er fr die elektronische Erzeugung von einem Vibrato

benutzt. Er kann also auch die Tonhhe Modulieren und so in einer Frequenz von 3-

15Hz das typische Vibrato an einer Geige, einer Gitarre oder hnlichem erzeugen. Der

LFO hat den Vorteil, gnzlich verndert werden zu knnen, whrend der normale

Oszillator noch ein wenig eingeschrnkt ist. So kann zum Beispiel der LFO

durchgehend gendert werden, abwechselnd im Takt mal schneller, mal langsamer.

Er ist nicht frequenzgebunden und somit deutlich flexibler.

Insgesamt kann der LFO einen viel greren Bereich abdecken, als er fr das Vibrato

bentigt wird.

Modulation meint in der elektronischen Musik nichts weite, als das Bearbeiten von

Parametern. Sobald also an einem Knopf gedreht wird, spricht man von der

Modulation.

Auch FL Studio besitzt die Mglichkeit der LFO-Modulation.

33

Was sind Plugins?

Bei Internetbrowsern wie Firefox oder Google Chrome, gibt es Plugins ebenso wie in

der elektronischen Musik. Diesen helfen sie beispielsweise Werbung zu verbergen

oder Internetvideos abzuspielen. VST ist die Abkrzung fr Virtual Studio Technology

und macht Entwicklern, sowie Musikern den Weg fr vllig Neues frei.

Eine Schnittstelle fr VST Plugins, macht ein Programm gleich viel flexibler und bietet

endlose Mglichkeiten. VSTs kommen auch direkt aus der Musikproduktion und

wurden eigens fr diese entworfen.

1996 stellte Steinberg das erste Mal die VSTs vor. Der Programmierer programmiert

ein Instrument oder einen Effekt, den der Musiker dann direkt in sein Programm

laden kann. Nicht alle Musikprogramme jedoch sind VST-kompatibel und damit

sogenannte VST-Hosts, sondern einige bedienen sich auch anderen Technologien.

VSTs sind am weitesten verbreitet und knnen unterschiedlich benutzt werden. Mit

der Zeit hat sich VST weiterentwickelt, sodass nun einige Erweiterungen, wie

beispielsweise ein Qualittszertifikat und weitere Mglichkeiten fr die Kompabilitt

hinzugekommen sind. Der einzige Nachteil ist, da VST fr jeden Programmierer frei

zugnglich ist, knnen schlecht programmierte Instrumente oder Effekte die Stabilitt

des gesamten Programms beeinflussen und in Extremfllen zu einem Absturz fhren.

Frhere Versionen

16

Ab Version 3.0

17

16

Quelle Abb. http://www.soundonsound.com/sos/nov10/articles/25-milestone-products.htm (Jan. 2014)

17

Quelle Abb. http://www.musictech.net/wp-content/uploads/2013/09/steinberg_vst3_logo.jpg (Jan. 2014)

34

Als Effekt kann das VST meist keine eigenen Tne erzeugen, sondern nur die der

Instrumente durch Modulation bearbeiten. Eine Ausnahme bildet beispielsweise ein

VST Effekt, welcher ein Krakeln eines Schallplattenspielers imitieren soll (so wie ich

einen benutze). Die Mglichkeiten sind beinahe grenzenlos. Flanger, Distortion

(Verzerrung), Delay (Verzgerung), oder Reverb (Hall) sind nur einige Beispiele. Im

Mixer, werden diese Effekte dann auf das gewhlte Instrument angewandt. Auch

Effekte, die es physisch zu kaufen gibt, gibt es ebenso digital als VST. Die folgende

Abbildung zeigt, wie ein Effekt aussehen kann. (Abb.

18

Als Instrument (Virtual Studio Technology Instrument), kann das Plugin direkt in das

Pattern geladen und dort bearbeitet und verwendet werden. Im VSTi knnen eigene

Effekte integriert sein, die man verwenden kann. Ausserdem kann man hufig

vollstndig in den Klang eingreifen. Ein Instrument besteht so gut wie immer aus

Oszillatoren die durch ihre Kombination Klnge imitieren oder typische Synthesizer

Klnge erstellen knnen. Meistens gibt es auch sogenannte Presets, die bereits Tne

voreingestellt haben. Die Vielfalt ist unendlich: Mundharmonika, Geigen, Flten,

Chor, Contrabass, Akustische Gitarre, Exotische Instrumente, . . . Ein dauernd

wachsendes Spektrum und die Freiheit bei modulierbaren Oszillatoren knnen

helfen, den Liedern eine absolut persnliche Note zu geben. Genau wie Effekte

knnen die Instrumente komplett unterschiedlich aussehen und jedes Mal, wenn

man ein neues benutzt, muss man beginnt eine neue Auseinadersetzung.

18

Quelle Abb. Eigener bearbeiteter Screenshot

35

Ein Effekt (VST) kann also auf ein Instrument (VSTi) angewendet werden. Doch wie

werden diese beiden verbunden?

Auch der Mixer ist ein mchtiges Werkzeug, er kann VSTs mit VSTis verbinden, das

macht ihn unter Anderem so wichtig. Der Groteil des Masterings, also des letzten

Schliffs eines Liedes, findet im Mixer statt. Somit ist der fachgeme Gebrauch des

Mixer auch ein Zeichen fr die Professionalitt eines Musikers, denn ein gutes

Mastering ist in der Musikwelt immer wichtig. Wenn man ein Instrument in den

Mixer laden will, um es mit Effekten zu versehen oder weiter zu bearbeiten, gibt es

mehrere Mglichkeiten. Die einfachste Mglichkeit ist, es im Pattern anzuwhlen. Bei

VST Instrumenten ffnet sich das Plugin zustzlich, dieses kann man schlieen. Bei

geladenen Samples, ffnet sich nur ein kleines Fenster, welches dann weiterfhrende

Mglichkeiten bereithlt.

36

(Abb.

19

)

Hier gibt es die Mglichkeit den Pitch zu

verndern, die Lautstrke und das Spektrum in

welchem der Pitch gendert werden kann.

Weitere Optionen wie Attack (Anschlag),

Release oder Decay sind auch mglich, jedoch

unter dem Reiter INS. Unten ist das Sample

visuell dargestellt, die Knobs, also die runden,

drehbaren Regler knnen das Sample an sich

verndern. Zum Beispiel Fade-in oder Fade-out

lassen das Sample vorne und hinten an- oder

abklingen. Darber sind einige Mglichkeiten,

die Welle zu bearbeiten; Reverse fr rckwrts

oder Swap Stereo, fr ein vertauschtes

Stereoverhltnis. Alle Mglichkeiten lassen sich

kaum in diesem Rahmen beschreiben, die

meisten sind beim Instrument auch nicht

vorhanden. Beim VSTi wird ausserdem eine

Klaviatur anstatt der Aussteuerung angezeigt.

Um nun das Sample oder das Instrument an den Mixer zu senden, muss lediglich die

passende Zahl in das FX Fenster eingegeben werden. In diesem Fall, FX 4. Es wird an

Channel 4 im Mixer geschickt und kann dort mit bis zu acht Effekten beladen werden.

19

Quelle Abb. Eigener Screenshot

37

(Abb.

20

)

Diese Abbildung zeigt den Mixer, der bereits mit Effekten und Instrumenten beladen

ist. Fr die bersicht wurden den Instrumenten Farben und kleine Icons (Symbole)

zugeordnet. Auch hier ist es nicht mglich, wirklich alles zu beschreiben.

Jede vertikale Spur kann mit mindestens einem Instrument, Sample oder Loop belegt

werden. Die Spur auf der linken Seite ist immer der Master (hier Grn), also das

Endergebnis und die Gesamtlautstrke. Am obersten Rand kann am Dreieck ein

Scrolldownmenu ausgefahren werden, welches jedoch von mir nicht oder kaum

benutzt wird.

Jede Spur hat eine Aussteuerungsanzeige. Wenn die Aussteuerung am oberen Rand

ankommt, ist das Ergebnis deutlich bersteuert und es klingt schrecklich verzerrt.

Somit sollte kein Instrument in diesen Bereich kommen und auch der Master darf den

Orangenen Bereich nicht berschreiten.

Unter dem Namen des Instrumentes (in der ersten Spur der Master), gibt es einen

Bogen ber den man die Balance, also ob der rechte oder der linke Lautsprecher

20

Quelle Abb. http://www.flstudio-shop.de/assets/images/neuer-mixer_600.png (Jan. 2014)

38

angesteuert werden soll, einstellen kann. Darunter befindet sich der Volumenregler,

ber den man die Lautstrke einstellen kann.

Die Channelzahl kann am oberen Ende jeder Spur abgelesen werden. Ein an FX 4

geschicktes Instrument erscheint an Insert 4.

Auf der rechten Seite sind die Effekte. Von unten nach oben gibt es eine Art

Rangordnung. Der unterste Effekt wirkt sich auf die oberen Effekte aus. Ein Verzerrer

auf Platz 8, verzerrt so auch einen Flanger auf Platz 7, diese beiden wirken sich auf

einen Reverb auf Platz 6 aus usw.

Unter der Mglichkeit, acht Pltze mit Effekten zu belegen, gibt es einen groben

Equalizer und weitere Funktionen. Diesen sollte man jedoch nicht verwenden, da der

Equalizer viel zu ungenau ist. Dafr verwendet man also besser auch ein Plugin. Jede

Spur bietet auerdem die Mglichkeit, das FX zu deaktivieren. Wenn es deaktiviert

ist, wird es grau, aktiviert, gelb. Das hat zur Folge, dass alle Effekte abgeschaltet

werden und das Instrument dry gehrt werden kann. Das ist fr einen Vorher-

nachher-Vergleich wichtig, um zu erkennen, ob eine Besserung oder eine

Vernderung erfolgt ist, die es wert ist, beibehalten zu werden. Um auch einen

Vergleich mit nur einem einzigen Effekt zu haben, gibt es neben jedem Slot, also

jedem Platz fr einen Effekt einen Knob, mit dem die Intensitt des Effektes gewhlt

werden kann. Das kleine grne Lichtchen, kann an- oder ausgeschaltet werden, um

den Effekt vllig zu deaktivieren.

39

Automation Clips knnen bei vielen Knobs mit einem Rechtsklick in die Playlist

geladen werden, dabei spielt es keine Rolle, ob es die Lautstrke, der Cutoff oder

etwas anderes ist. (Abb.

21

)

Mithilfe der Kurven lsst sich nun die Entwicklung des gewhlten Effekts ber das

ganze Lied hinweg bearbeiten. Dicke Punkte sind dabei immer die Extremwerte.

Zwischen zwei groen Punkten ist immer ein Mittelpunkt, der etwas kleiner ist, es sei

denn, die groen Punkte sind vertikal auf einer Hhe. Durch Benutzen eines kleinen

Punktes, kann von einer linearen bis zu einer exponentiellen Steigung stufenlos

eingestellt werden. Wenn man mit der gedrckten Maustaste nach unten fhrt, geht

es immer mehr zur exponentiellen Kurve am rechten Extremwert. Fhrt man nach

oben, nhert sich die Steigung einer exponentiellen am linken Extremwert. Auch auf

dem LFO lassen sich diese Einstellungen vornehmen. Somit sind die Automation Clips

auch eine Mglichkeit, den berhmten Wobble Bass im Dubstep zu erschaffen. Fr

meine Musik benutze ich Automation Clips vor allem fr bergnge, so kann ich eine

Melodie (Trance oder Dance typisch) aus dem Bass kommen lassen und so den Effekt

des aus dem Nichts entstehen lassen, erzeugen.

21

Quelle Abb. Eigener Screenshot

40

Eine weitere Mglichkeit ist das Edit Events, es hat eine hnliche Funktionsweise, wie

die Automation Clips, lsst sich aber genauer bearbeiten.

Das perfekte Werkzeug fr jeden Dubstep Produzenten ist Edit Events, auch ber den

Rechtsklick anwhlbar. Es erscheint ein neues Fenster, welches im ersten Moment ein

wenig wie die anderen Aussieht, jedoch eine vllig eigene Funktion hat. Im Beispiel

Dubstep kann man es auf den Cutoff anwenden und ihn dort sehr przise bearbeiten.

Es gibt die Mglichkeit, diese komplett mit der Maus zu erstellen, oder einen LFO zu

verwenden, wie in diesem Beispiel. Diesen LFO habe ich von links nach rechts zu

Beginn schnell und zum Ende hin immer langsamer ausschlagen lassen.

22

Quelle Abb. Eigener Screenshot

41

Auch wenn ein LFO benutzt wurde, kann er nachtrglich mit der Maus bearbeitet

werden. Wenn man nur einen Teil der Zeit markiert und den LFO verndert, wird er

nur fr diesen Teil verndert, so kann man Rhythmusnderungen vornehmen.

Mit der linken Maustaste werden die nderungen genau der Maus folgend erstellt.

Mit der rechten erstellt man eine Gerade zwischen Ansatz- und Endpunkt.

tigt

Was man fr das Komponieren bentigt, kommt ganz darauf an, welches Budget man

zur Verfgung hat, und wie professionell man arbeiten mchte. Das Programm an

sich gibt es in verschiedenen Ausfhrungen. Die Fruity Edition ist die gnstigste und

in ihren Mglichkeiten sehr reduzierte Version. Wichtig ist natrlich zu berlegen,

was damit gemacht werden soll. Hobbymig zu komponieren ist damit mglich.

Doch sollte es professionell werden, fehlt doch Einiges. Das Aufnehmen generell, ist

mit der Fruity Edition nicht mglich. Auch die wichtigen Automation Clips, mit denen

Effekte oder die Lautstrke ber die Laufzeit des Liedes unterschiedlich geschaltet

werden knnen, fehlen. Die Producer Edition bietet da schon mehr. Sie kann

aufnehmen und Automation Clips verwenden.

Die Signature Bundle Edition bringt noch einige, sonst separat kufliche Effekte und

Instrumente gleich mit. Sie ist die teuerste von allen Dreien. Da das Aufnehmen und

die Automation Clips wirklich wichtige Werkzeuge sind, ist es ratsam sich die

Producer Edition zu holen. Die Signature Bundle Version ist nur bei vertiefter

Auseinandersetzen mit der elektronischen Musik zu empfehlen. Von der Fruity

Version wrde ich ganz abraten. Hat man sich fr eine Version entschieden, sollte

man sich 49$ bereithalten um sich im Online-Shop von Image-Line Lifetime free

Updates zu kaufen. In der Signature Bundle Edition sind diese bereits mitgeliefert.

Damit kann man jede kommende Version von FL Studio, mit allen Erneuerungen,

kostenlos bekommen und ist so immer auf dem neusten Stand.

42

Neben FL Studio ist fr jedes Musikprogramm ein relativ aktueller Computer

empfehlenswert, um Hnger und starke Verzerrung durch zu langsames Bearbeiten

der Informationen zu vermeiden. Mit der Maus und der Tastatur lassen sich so

bereits mit den vorinstallierten Instrumenten gute Melodien und Lieder

komponieren. Der einzige Nachteil ist, dass in Musikerkreisen zum Beispiel der Klang

der FL Keys sehr schnell erkannt wird und das Lied somit an Magie verliert. Im

Internet gibt es zahlreiche VSTs, die das verhindern knnen und so den Eindruck

eines schlecht gemachten Liedes ausbremsen knnen. Das Angebot an kostenfreien

sowie kostenpflichtigen Instrumenten ist immens.

Gute Kopfhrer oder Lautsprecher sind das A und O. Auf gar keinen Fall darf man

ber Laptop Lautsprecher arbeiten. Das Ergebnis knnte aus 90% Bass bestehen und

auf jeder anderen Box ganz miserabel klingen. Da die Bassfrequenzen von einem

kleinen Lautsprecher nur bedingt wiedergegeben werden, versucht der Musizierende

dies durch Anheben des Basspegels auszugleichen und heraus kommt eine Art

Subwoofer Test. Mit normalen Lautsprechern einer Stereoanlage oder eines Hi-Fi

Systems ist es vorerst in Ordnung zu komponieren. Dennoch ist es immer wichtig

einen Vergleich zu haben und die Anlage gut zu kennen. Wenn das fertige Lied auf

der einen Anlage ausgeglichen klingt, jedoch auf jeder anderen zu hhenbetont, dann

hat die Referenzanlage zu viel Bass oder anders herum. Bei einer richtigen

Leidenschaft, oder sogar dem Wunsch, diese Kreativitt beruflich auszuben, ist es

von groer Wichtigkeit, sich Monitorlautsprecher zu besorgen, am besten aktive.

Diese haben einen linearen Sound und versuchen die Musik so wiederzugeben, wie

sie ist. Die teuersten Hi-Fi Lautsprecher ntzen nichts, wenn sie nicht linear sind und

jedes Stck mit einem Equalizer romantisieren und somit verflschen. Denn ein

fertiges Lied sollte nicht nur auf einer Anlage gut klingen, sondern auf so gut wie

jeder. ber ein USB Interface kann ein extrem hochwertiger Sound wiedergegeben

werden. 3,5mm Klinke sollte hierbei vermieden werden, zu schlecht die Qualitt.

Mindestens 6,3mm, wenn nicht sogar XLR Anschlsse sollten fr das beste Ergebnis

verwendet werden.

43

Um die Vorteile der Aktivmonitore voll auszunutzen, ist es wichtig den Raum

akustisch vorteilhaft einzurichten. Hall sollte vermieden werden. Bei weniger Budget,

kann ein Teppich auf dem Boden und Stoff an der Wand bereits Wunder wirken. Auf

gar keinen Fall jedoch, sollte eine kahle Wand den Boxen gegenber oder in

unmittelbarer Nhe sein. Eine Wand absorbiert den Schall nicht, sondern wirft ihn

zurck, was wiederum eine ungenaue Soundwiedergabe zur Folge hat. Die

Lautsprecher sollten am besten auf weichem Untergrund stehen und nicht auf Holz.

Wer etwas mehr Geld zur Verfgung hat, kann sich Akustikschaumstoff kaufen und

Stnder fr die Lautsprecher. Je mehr Stoff und je weniger Holz oder Metall in der

Umgebung ist, desto besser.

Ein Midi Keyboard kann auch nicht schaden. Nach dem Anschlieen kann man es

dann mit allen Samples und Instrumenten belegen, die man in sein Programm

geladen hat und diese gleich aufnehmen. Das praktische ist, die Tne werden im

Piano Roll angezeigt und knnen dort wieder vllig frei verndert, gelscht oder

ergnzt werden.

44

Zu Beginn steht oft, nicht immer, die Idee. Unter der Dusche, bei den Hausaufgaben

oder unterwegs kommt sie, manchmal unangekndigt, manchmal beim wilden

Rumpfeifen. Dann muss alles ganz schnell gehen, die Idee muss festgehalten werden,

damit sie nicht verloren geht. Zu oft ist es mir passiert, dass ich eine Idee hatte und

dachte: die vergesse ich nicht mehr, und zehn Minuten spter war sie weg. Also so

unmittelbar wie mglich muss die Idee verewigt werden. In der eigenen Wohnung ist

das kein Problem, ich schmeie den Computer an, ffne das Internet und gehe auf

die Seite all8.com, klicke auf Tap BPM und drcke im Takt zu meiner Melodie im Ohr

eine beliebige Taste. Die Seite spuckt nach einiger Zeit die passende BPM (Beats per

Minute) in Zahlen aus und ich ffne mein Musikprogramm. Die aufgerundete Zahl

gebe ich dann in das passende Kstchen bei FL Studio ein. Somit ist das ganze Projekt

bereits im passenden Tempo. An der Geschwindigkeit im Zusammenspiel mit der

Melodie und natrlich meinen Wnschen kann ich nun voraussagen, in welche

Richtung das Lied in etwa gehen wird.

Nachdem ich also die Geschwindigkeit angepasst habe, nehme ich mir das

nchstbeste Instrument und beginne mein Hirngespinst in Tne zu verwandeln.

Meistens nehme ich dazu die FL Keys, das primitive virtuelle Instrument von Image-

Line. Jedes andere Instrument bentigt, um die Melodie klar und schnell zu vertonen,

vorangehende Einstellungen, und das kann ich in so einer eiligen Situation berhaupt

nicht gebrauchen. FL Keys dagegen muss ich nur in das Programm laden und kann es

sofort wie ein kleines, schlecht klingendes Klavier benutzen, spielen und mit meinen

Ideen beschreiben. Nachdem dies getan ist, speichere ich sofort und ein Stein fllt

mir vom Herzen. Ich habe es geschafft: Ein neues Lied steht in den Startlchern.

Problematisch wird es erst, wenn ich unterwegs den Einfall habe. Da ich

notentechnisch eine Niete bin, ist es mir nicht mglich, schnell ein Blatt mit Noten zu

beschreiben. Besser ist es, wenn ich mein Handy, meine Kamera oder hnliches dabei

45

habe, mit dem ich etwas aufnehmen kann. Solange ich nicht in der Straenbahn oder

der Innenstadt bin, geht das auch mal, um die Melodie festzuhalten. Wenn auch das

nicht der Fall ist, dann muss ich doch auf meine Erinnerungsfhigkeit zurckgreifen

und versuche die Melodie mglichst tief in mein Gehirn einzubrennen. Meistens

jedoch bin ich damit erfolgslos und die Idee verliert sich.

Nachdem ich FL Studio ffne, erscheint die Arbeitsoberflche vllig leer, wie ein

unbeschriebenes Blatt. (Abb.

23

)

23

Quelle Abb. Eigener Screenshot

46

Im aktuellen Pattern ffne ich mit einem Rechtsklick auf ein Instrument/Sample (hier

Kick, Clap, Hat oder Snare) ein Scrolldownmen, welches mir unter Anderem die

Mglichkeiten gibt, es durch ein anderes zu ersetzen oder ein weiteres hinzuzufgen.

Ich ersetze den Kick durch ein richtiges Instrument. Bei schnelleren oder komplexeren

Melodien nehme ich vorrbergehend FL Keys, um schnelle Ergebnisse zu erzielen. Bei

Begleitung oder Melodien, die mit Klavier berhaupt nichts zu tun haben, nehme ich

vorerst Sytrus und irgendein Preset. Fr den typischen Bass BooBass.

Mit dem geladenen Instrument gehe ich nun in den Piano Roll (Rechtsklick send to

Piano Roll) und beginne meine Melodie zu schreiben. Nachdem ich das gespeichert

habe, verfalle ich meist in den Beat. Auch hier suche ich mir erst nur Kicks, die

funktionieren und beginne einen passenden Beat zu kreieren. Kick und Snare sind

hier die Grundfunktionen, spter kommen Hi-Hats, Crash und Precussion hinzu.

Wenn ich etwas an der Melodie verndern oder ergnzen mchte, klone ich das

Pattern, um eine Art Backup zu haben, fr den Fall, dass mir die Idee misslingt, oder

etwas vllig Anderes dabei herausspringt.

Irgendwann ist es dann soweit. Nach einigen Wochen oder Monaten habe ich lauter

unbenannte, vollgestopfte Patterns. Oft haben einige Patterns einige Instrumente mit

den gleichen Melodien oder Begleitungen. Nachdem ich so die Grundzge

herausgearbeitet habe, splitte ich die Patterns, nehme sie also auseinander. Dafr

klone ich ein Pattern und lsche im neuen alle Instrumente, bis auf eines. Dieses

lsche ich dann aus dem ursprnglichen Pattern, bis nur noch eines brig ist. Dies

mache ich mit allen Pattern, die mehrere Instrumente haben und lsche Doppeltes.

Nun habe ich fr jedes Instrument in jeder Ausfhrung ein eigenes Pattern. So habe

ich mehr bersicht und kann spter in der Playlist viel flexiblere Einstellungen

vornehmen. In der Playlist setze ich meine Puzzlestcke zusammen, meistens

entstehen Gruppen an Musiksegmenten. So zum Beispiel zu Beginn eine Art Intro,

47

welches vllig anders daherkommt, als der Mittelteil. Oft kommen die bergnge

erst sehr spt dazu, das heit, nach dem Intro ist eine kleine Pause, dann kommt der

Mittelteil, wieder eine Pause und dann eine Art Zwischenteil und wieder der

Hauptteil. Meistens kommt anschlieend noch ein Anhngsel in einer vllig anderen

Musikrichtung hinzu. Diese Anordnung ist natrlich nicht jedes Mal gleich, aber als

Veranschaulichung in Ordnung.

Nach und nach beginne ich, die Grundlautstrke fr die Instrumente festzulegen.

Diese darf spter nicht mehr verndert werden, da dies Auswirkungen auf jedes

Pattern und somit auf das gesamte Arrangement hat. Fr die bersicht, welche, je

weiter ich in der Produktion fortschreite, immer wichtiger wird, halte ich in der

Playlist die Tracks nach Instrumenten sortiert. Ein Track ist dann z.B. der Bass, dieser

wird so benannt, bekommt ein Icon und eine passende Farbe von mir zugeteilt. Alles,

was jetzt Bass ist, setze ich in diesen Track. Nur selten berschneidet sich dort etwas.

Da Fruity Loops bis zu 199 Tracks zulsst, hat man auch mehr als ausreichend Platz.

24

24

Quelle Abb. Eigener Screenshot

48

Bei meinen Kompositionen fr die Jahresarbeit begann ab hier fr mich absolutes

Neuland, den Mixer habe ich in meinen alten Produktionen so gut wie nicht benutzt,

und somit habe ich keine Effekte zu meiner Musik hinzugefgt oder gar ein Mastering

vollbracht. Da meine letzten Lieder bereits ber zwei Jahre zurckliegen, ist das zu

verkraften. Da ich mich jedoch weiterentwickeln, und fr die Jahresarbeit von vorne

bis hinten komplette Lieder gestalten mchte, komme ich daran nicht vorbei.

Da alle Instrumente/Samples noch relativ unbrauchbar sind, mache ich mich auf die

Suche nach den Sounds die meinen Vorstellungen entsprechen. Nach und nach

ersetze ich so die eher schlecht klingenden mit gut klingenden Instrumenten und die

billigen mit den qualitativ hochwertigeren Samples. Dabei kombiniere ich auch Kicks,

Claps, Snares und Hi-Hats so miteinander, dass sie mir gefallen. Meistens habe ich

bereits whrend vorheriger Schritte damit angefangen und vervollstndige das nur

noch mit Begleitungen und nicht mit den Hauptinstrumenten.

Ich schicke nun ein Sample oder Instrument nach dem anderen in den Mixer. Fr

jedes nehme ich einen anderen Channel, sonst wrden sich die Einstellungen auf

mehrere auswirken. Beim Mischen werden Frequenzen gespart. ber den Parametric

Equalizer 2 in FL Studio krze ich so zum Beispiel die Hhenanteile aus einem Kick

und die tiefen aus einem Hi-Hat. Der Vorteil hier ist besonders der satte Sound, der

entsteht, da sich die Hhen und Tiefen nun strker voneinander abheben, weil sich

die Instrumente stark voneinander unterscheiden und jedes seinen eigenen

Frequenzbereich bekommt. Wichtig ist auch, die Stereoanteile aus tieferen

Instrumenten zu verbannen und diese so monoton zu halten wie mglich, damit die

49

Melodie und die hheren Tne diese voll ausnutzen knnen. Nach diesen Schritten ist

das Mischen fertig. Trotzdem sollte es nicht unterschtzt werden, da es mit einer

gewissen Anzahl an Instrumenten einige Zeit dauern kann. ber mehrere Stunden

verteilt hrt man dann meistens auch nur einzelne Instrumente und passt diese

aneinander an. Somit ist das Mischen nicht nur Visuell, sondern immer auch auditiv

und man sollte immer einen Vergleich haben, um zu sehen, ob es wirklich eine

Besserung gab.

Nach dem Mischen oder Pre-Mastering geht es an das richtige Mastering. Zu Beginn

muss die Frequenzkurve mit einem Equalizer (apQualizer) kontrolliert werden. Am

besten ist es, wenn diese Kurve von links (Bass) nach rechts (Hhen) duchschnittlich

linear abfllt. Beim Mastering wird vor allem noch einmal etwas Lautstrke

hinzugewonnen. Mit dem Fruity Multiband Compressor bearbeite ich die Tiefen,

Mitten und Hhen des gesamten Songs. Der Kompressor komprimiert die Tne, die

aus dem Lied herausstechen und zu laut sind. Sie werden leiser gespielt werden,

damit sich der gesamte Ton gleichmiger anhrt. Der Kompressor springt bei der

vorgegeben Lautstrke der gewhlten Frequenz an. Der Kompressor hilft, die lauten

Teile eines Tons abzusenken und den kompletten Ton dadurch lauter spielbar zu

machen, ohne, dass dieser bersteuert.

50

Auch, wenn ich ein sehr groer Fan von elektronischer Musik bin, sollte sie in meinen

Augen auf gar keinen Fall die akustische ersetzen. Zwar hat elektronische Musik fr

mich genauso eine Essenz wie unplugged Music, dennoch ist es schn, Instrumente

live oder auch aufgenommen zu hren und zu sehen. Deshalb sollte elektronische

Musik nie versuchen, wie akustische zu klingen, sondern eindeutig elektronisch sein

und ihre Vorteile der Synthesizer und Oszillatoren, sowie digitalen Effekte voll

ausnutzen. Es gibt nichts Schneres als gemeinsames Musizieren. Doch auch das

Zusammenkommen und Musizieren mit Freunden muss bei der elektronischen Musik

nicht verloren gehen. Es geschieht aber auf einer ganz anderen Ebene. Ein Vorteil ist

auch, wenn man mit jemanden aus dem Internet oder einem Freund, der gerade fern

ist, musizieren will, kann man sozusagen kooperative Lieder gestalten. Man kann sich

flps (das Dateiformat in dem FL Studio Projekte vor dem Export gespeichert werden)

hin und her schicken und so gemeinsam Musik erschaffen. Auch ist es nun fr

Menschen, die kein riesiges Budget haben, bereits mit einfachsten Mitteln mglich,

ihr Talent zu frdern und ihre eigene Musik zu komponieren.

Genau wie das Internet und andere technische Errungenschaften sollte in der

elektronischen Musik nicht sofort nur das Schlechte gesehen werden, denn das

Internet und die elektronische Musik sind letzten Endes nur das, was wir daraus

machen. Ob wir uns nun ber das Internet verabreden oder den ganzen Tag online-

Rollenspiele spielen ist schlielich uns berlassen.

Die Idee einige, elektronische Musik entstehe allein durch ein paar Knopfdrcke,

entspricht nicht ganz der Wahrheit.

Eine Ungerechtigkeit gibt es: Es gibt Menschen, die jahrelang ihre eigene Musik

komponieren, die immer einen besonderen Charakter hat und hinter der wirklich

Arbeit steckt. Andere benutzen Vorlagen, kopieren Melodien und werden ber Nacht

zum Star. Das ist wirklich nicht fair. Ich beobachte, dass nur eine kleine Anzahl von

Musikrichtungen wirklich Verbreitung findet, sei es, weil die Plattenfirmen und

51

Musikproduzenten keine Lust oder keinen Mut dazu haben, etwas neues zu

versuchen, und lieber Zusammengeklautes verffentlichen, oder sei es, dass das

ausgewhlte Stck wie 30 andere Stcke klingt, die zuvor schon in den Charts waren.

Auf diese Weise kommen kleine Musiker, die wirklich fr die Musik arbeiten und

leben, nicht oder nur sehr selten auf diesen Stand der Bekanntheit. Dieses

Phnomen, war jedoch auch vorher schon erkennbar.

Wenn man sich aber ein wenig in die Tiefen der Musikrichtungen und Mglichkeiten

begibt, findet man, da bin ich mir sicher, immer etwas, was einem gefllt, auch wenn

man elektronischer Musik generell eher skeptisch gegenbersteht. Denn auch hier ist

es, wie berall anders auch, immer gut eine allgemeine Offenheit, dem Neuen

gegenber zu haben, sonst verpasst man womglich noch einige Highlights. Spter

kann man immer noch entscheiden, ob man es nun mag oder nicht.

Ich habe in der Vielfalt des Hrbaren im Internet einiges Interessantes gefunden, und

auch meine Musik durch verschiedene Impulse bereichern knnen.

25

25

Quelle Abb.

http://4.bp.blogspot.com/-f0vY0Sih5uc/UHh5JDhNTjI/AAAAAAAAAC4/fbYfLzm07DA/s1600/blog+pic.png

(Jan. 2014)

52

Afrojack:

bekannter Knstler, der Fl Studio nutzt und sich durch seine ausgefallene