Beruflich Dokumente

Kultur Dokumente

Administración de Procesos y Procesador

Hochgeladen von

Jorge I. Arteaga0 Bewertungen0% fanden dieses Dokument nützlich (0 Abstimmungen)

43 Ansichten3 SeitenEl documento describe conceptos fundamentales sobre procesos y administración de procesadores. Explica que un proceso es un programa en ejecución que incluye el estado actual del programa y la memoria asignada. Los procesos pueden estar en diferentes estados como listo, en ejecución o bloqueado. También introduce conceptos como procesos ligeros, concurrencia, planificación de procesos y diferentes algoritmos de planificación como FIFO, SJF y Round Robin.

Originalbeschreibung:

Originaltitel

Sistemas Operativos (REMA).docx

Copyright

© © All Rights Reserved

Verfügbare Formate

DOCX, PDF, TXT oder online auf Scribd lesen

Dieses Dokument teilen

Dokument teilen oder einbetten

Stufen Sie dieses Dokument als nützlich ein?

Sind diese Inhalte unangemessen?

Dieses Dokument meldenEl documento describe conceptos fundamentales sobre procesos y administración de procesadores. Explica que un proceso es un programa en ejecución que incluye el estado actual del programa y la memoria asignada. Los procesos pueden estar en diferentes estados como listo, en ejecución o bloqueado. También introduce conceptos como procesos ligeros, concurrencia, planificación de procesos y diferentes algoritmos de planificación como FIFO, SJF y Round Robin.

Copyright:

© All Rights Reserved

Verfügbare Formate

Als DOCX, PDF, TXT herunterladen oder online auf Scribd lesen

0 Bewertungen0% fanden dieses Dokument nützlich (0 Abstimmungen)

43 Ansichten3 SeitenAdministración de Procesos y Procesador

Hochgeladen von

Jorge I. ArteagaEl documento describe conceptos fundamentales sobre procesos y administración de procesadores. Explica que un proceso es un programa en ejecución que incluye el estado actual del programa y la memoria asignada. Los procesos pueden estar en diferentes estados como listo, en ejecución o bloqueado. También introduce conceptos como procesos ligeros, concurrencia, planificación de procesos y diferentes algoritmos de planificación como FIFO, SJF y Round Robin.

Copyright:

© All Rights Reserved

Verfügbare Formate

Als DOCX, PDF, TXT herunterladen oder online auf Scribd lesen

Sie sind auf Seite 1von 3

UNIDAD 2.

- Administracin de Procesos y Del Procesador

2.1 Concepto de Proceso

Un proceso no es mas que un programa en ejecucin, e incluye los valores actuales del contador de programa, los registros y las

variables. Conceptualmente cada unos de estos procesos tiene su propia CPU virtual. Desde luego, en la realidad la verdadera CPU

conmuta de un proceso a otro.

Un proceso es un concepto manejado por el sistema operativo que consiste en el conjunto formado por:

Las instrucciones de un programa destinadas a ser ejecutadas por el microprocesador.

Su estado de ejecucin en un momento dado, esto es, los valores de los registros de la CPU para dicho programa.

Su memoria de trabajo, es decir, la memoria que ha reservado y sus contenidos.

2.2 Estado y Transiciones de los procesos

El principal trabajo del procesador es ejecutar las instrucciones de mquina que se encuentran en memoria principal. Estas

instrucciones se encuentran en forma de programas. Para que un programa pueda ser ejecutado, el sistema operativo crea un nuevo

proceso, y el procesador ejecuta una tras otra las instrucciones del mismo. En un entorno de multiprogramacin, el procesador

intercalar la ejecucin de instrucciones de varios programas que se encuentran en memoria. El sistema operativo es el responsable

de determinar las pautas de intercalado y asignacin de recursos a cada proceso.

El uso adecuado de la concurrencia entre procesos exige la capacidad de definir secciones crticas y hacer cumplir la exclusin

mutua. Cualquier servicio o capacidad que d soporte para la exclusin mutua debe cumplir con un protocolo de sincronizacin, que

tiene los requisitos siguientes:

1. Debe cumplirse la exclusin mutua: slo un proceso de entre todos los que poseen secciones crticas por el mismo recurso u

objeto compartido, debe tener permiso para entrar en ella en un instante dado.

2. Un proceso que se interrumpe en una seccin no crtica debe hacerlo sin estorbar a los otros. Es decir que si se cuelga un proceso

que est usando un recurso, los dems procesos que esperan deben poder acceder al recurso de todas formas (el S.O. mata al

proceso que se colg y as libera al recurso).

3. No se puede demorar indefinidamente la entrada de un proceso a un cierto recurso; no debe permitirse el interbloqueo y la

inanicin. Todos los procesos deben poder acceder al recurso que solicitan, sino se van a morir sin usarlo y no es justo.

4. Cuando ningn proceso est en su seccin crtica, cualquier proceso que solicite entrar en la suya debe poder hacerlo sin

dilatacin. Es decir, si nadie est usando un cierto recurso, entonces se le otorga al primer proceso que lo solicite.

5. No se pueden hacer suposiciones sobre la velocidad relativa de los procesos o su nmero (cantidad de procesadores). Nunca se

puede saber a priori si a un proceso le falta mucho o poco para terminar.

6. Un proceso permanece en su seccin crtica slo por un tiempo finito. Esto sirve para evitar que un proceso se quede con un

recurso por mucho tiempo y para que un recurso no se quede trabado sin sentido.

2.3 Procesos Ligeros (Hilos y Hebras)

Un proceso ligero, o thread, es un programa en ejecucin (flujo de ejecucin) que comparte la imagen de memoria y otras

informaciones con otros procesos ligeros. Un proceso puede contener un solo flujo de ejecucin, como ocurre en los procesos

clsicos, o mas de un flujo de ejecucin (procesos ligeros).

Cada proceso ligero tiene informaciones que le son propias y que no comparte con otros procesos ligeros. Las informaciones propias

se refieren fundamentalmente al contexto de ejecucin, pudindose destacar las siguientes:

Contador de programa.

Pila.

Registros.

Estado del proceso ligero (ejecutando, listo o bloqueado).

Todos los procesos ligeros de un mismo proceso comparten la informacin del mismo. En concreto, comparten:

Espacio de memoria.

Variables globales.

Archivos abiertos.

Procesos hijos.

Temporizadores.

Seales y semforos.

Contabilidad.

2.4 Concurrencia y Secuenciabilidad

Los procesos son concurrentes si existen simultneamente. Los procesos concurrentes pueden funcionar en forma totalmente

independiente unos de otros, o pueden ser asncronos, lo cual significa que en ocasiones requieren cierta sincronizacin o

cooperacin.

Multiprogramacin con un nico procesador.

En este modelo todos los procesos concurrentes ejecutan sobre un nico procesador. El sistema operativo se encarga de ir

repartiendo el tiempo del procesador entre los distintos procesos, intercalando la ejecucin de los mismos para dar asi una

apariencia de ejecucin simultanea.

Multiprocesador.

Un multiprocesador es una maquina formada por un conjunto de procesadores que comparten memoria principal. En este tipo de

arquitecturas, los procesos concurrentes no solo pueden intercalar su ejecucin sino tambin superponerla. En este caso si existe

una verdadera ejecucin simultanea de procesos, al coincidir las fases de procesamiento de distintos procesos. En un instante dado

se pueden ejecutar de forma simultanea tantos procesos como procesadores haya.

2.5 Niveles, Objetivos y Criterios de planificacin

Concepto de Planificacin

La planificacin hace referencia a un conjunto de polticas y mecanismos incorporados al sistema operativo que gobiernan el orden

en que se ejecutan los trabajos que deben ser cumplimentados por el sistema informtico.

Objetivo de la Planificacin

El objetivo principal de la planificacin es optimizar el rendimiento del sistema y proporcionar un buen servicio a todos los procesos

que se encuentren en el. En general, la planificacin trata de cubrir los siguientes objetivos:

Justicia.

Mxima capacidad de ejecucin.

Producibilidad.

Minimizacin de la sobrecarga.

Equilibrio en el uso de recursos.

Seguridad de las prioridades.

Criterios de planificacin

Para realizar los objetivos de la planificacin, un mecanismo de planificacin debe considerar lo siguiente:

Si un proceso es por lote o interactivo

La prioridad de un proceso

Cuanto tiempo de ejecucin real ha recibido el proceso

Cuanto tiempo adicional va a necesitar el proceso para terminar?: los tiempos promedio de espera pueden reducirse priorizando

los procesos que requieren de un tiempo de ejecucin mnimo para su terminacin, pero pocas veces es posible conocer la cantidad

de tiempo adicional que cada proceso necesita para terminar.

2.6 Tcnicas de administracin del planificador.

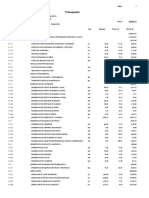

FIFO

Tal vez la disciplina mas simple de planificacin sea la de FIFO (First IN First OUT). Los procesos se despachan de acuerdo con su

tiempo de llegada a la cola de procesos listos. Cuando un proceso tiene la CPU, se ejecuta hasta terminar. Es junto en el sentido

formal, pero algo injusta en cuanto a que los trabajos largos hacen esperar a los cortos y los trabajos sin importancia hacen esperar a

los importantes. FIFO ofrece variaciones relativamente pequeas en los tiempos de respuesta y por lo tanto es mas predecible que

los otros esquemas. No es til en la planificacin para los usuarios interactivos porque no puede garantizar buenos tiempos de

respuesta.

SJF

Otro mtodo de planificacin de la CPU es el algoritmo de planificacin con seleccin del trabajo mas corto (SJF, shortest job-first).

Este algoritmo asocia con cada proceso la duracin de la siguiente rfaga de CPU del proceso. Cuando la CPU esta disponible, se

asigna al proceso que tiene la siguiente rfaga de CPU mas corta. Si las siguientes rfagas de CPU de dos procesos son iguales, se usa

la planificacin FCFS para romper el empate. Observe que un termino mas apropiado para este mtodo de planificacin seria el de

algoritmo de la siguiente rfaga de CPU mas corta, ya que la planificacin depende de la duracin de la siguiente rfaga de CPU de

un proceso, en lugar de depender de su duracin total. Usamos el termino SJF porque casi todo el mundo y gran parte de los libros

de texto emplean este termino para referirse a este tipo de planificacin.

RR (Round Robin)

Es un sistema apropiativo. Cada proceso recibe una fraccin de tiempo de procesamiento o cuanto para su ejecucin, de manera

que cuando se esta ejecutando y excede el tiempo que se le ha concedido, se genera una interrupcin de reloj, mediante la cual la

ejecucin del proceso se detiene y se coloca al proceso al final de la cola de procesos listos para su posterior ejecucin,

seleccionndose a continuacin un nuevo proceso de la cola para su ejecucin. Si un proceso finaliza su ejecucin antes de que

termine el tiempo que se le ha asignado, este cede el control, seleccionndose un nuevo proceso de la cola para su ejecucin.

Queues Multinivel (Colas Multinivel)

Otra clase de algoritmos de planificacin es la que se ha desarrollado para aquellas situaciones en las que los procesos pueden

clasificarse fcilmente en grupos diferentes. Por ejemplo, una clasificacin habitual consiste en diferenciar entre procesos de primer

plano (interactivos) y procesos de segundo plano (por lotes). Estos dos tipos de procesos tienen requisitos diferentes de tiempo de

respuesta y, por tanto, pueden tener distintas necesidades de planificacin. Adems, los procesos de primer plano pueden tener

prioridad (definida externamente) sobre los procesos de segundo plano.

Multi-Level Feedback Queues (Colas Multinivel Realimentadas)

El algoritmo de planificacin mediante colas multinivel realimentadas permite mover un proceso de una cola a otra. La idea es

separar los procesos en funcin de las caractersticas de sus rfagas de CPU. Si un proceso utiliza demasiado tiempo de CPU, se pasa

a una a de prioridad mas baja.

La definicin del planificador mediante colas multinivel realimentadas le convierte en el algoritmo de planificacin de la CPU mas

general. Puede configurarse este algoritmo para adaptarlo a cualquier sistema especifico que se quiera disear. Lamentablemente,

tambin es el algoritmo mas complejo, puesto que definir el mejor planificador requiere disponer de algn mecanismo para

seleccionar los valores de todos los parmetros.

Das könnte Ihnen auch gefallen

- Administracion de Procesos y Del ProcesadorDokument10 SeitenAdministracion de Procesos y Del ProcesadorAleks FloresNoch keine Bewertungen

- UF0852 - Instalación y actualización de sistemas operativosVon EverandUF0852 - Instalación y actualización de sistemas operativosBewertung: 5 von 5 Sternen5/5 (1)

- Presupuesto Estructuras Hosp - TarapotoDokument4 SeitenPresupuesto Estructuras Hosp - TarapotoDiegoCastilloNoch keine Bewertungen

- E 3 Tabla 3 Trabajos Energizados y DesenergizadosDokument1 SeiteE 3 Tabla 3 Trabajos Energizados y DesenergizadosCarmen Castillo0% (1)

- Algoritmos Planificacion FCFS SJF SRTF Round RobinDokument10 SeitenAlgoritmos Planificacion FCFS SJF SRTF Round RobinRamon Lloret PertusaNoch keine Bewertungen

- Procesos e HilosDokument6 SeitenProcesos e HilosTracey YangNoch keine Bewertungen

- UNIDAD 2 Administración de Procesos y Del ProcesadorDokument7 SeitenUNIDAD 2 Administración de Procesos y Del ProcesadorPorfis Aguilar TrejoNoch keine Bewertungen

- 1er Examen ParcialDokument5 Seiten1er Examen ParcialDassaef TorresNoch keine Bewertungen

- Concurrencia y SecuencialidadDokument4 SeitenConcurrencia y SecuencialidadIsmael Miguel Montalvo100% (1)

- UNIDAD 2 Administracion de Procesos y Del ProcesadorDokument7 SeitenUNIDAD 2 Administracion de Procesos y Del ProcesadorAngelina Salgado LeonNoch keine Bewertungen

- Segunda Unidad de Sistema OperativoDokument12 SeitenSegunda Unidad de Sistema OperativoRigo PerezNoch keine Bewertungen

- Unidad IIDokument10 SeitenUnidad IIAngelina Salgado LeonNoch keine Bewertungen

- Cap 4 Administración Del Procesador Yosnel JimenezDokument13 SeitenCap 4 Administración Del Procesador Yosnel JimenezYosnel Alberto Jiménez LedesmaNoch keine Bewertungen

- Procesos y Threads: Comunicación y EstadosDokument7 SeitenProcesos y Threads: Comunicación y Estadosjonathan joel lagoriaNoch keine Bewertungen

- 3ra Unidad Completo Toda La InvestigacionDokument50 Seiten3ra Unidad Completo Toda La InvestigacionJanet ShNoch keine Bewertungen

- Para Recordar SO Gestión de ProcesosDokument6 SeitenPara Recordar SO Gestión de ProcesoscamiloNoch keine Bewertungen

- 2.5 y 2.6 - Niveles Objetivos y Criterios de La PlanificaciónDokument12 Seiten2.5 y 2.6 - Niveles Objetivos y Criterios de La PlanificaciónJuan alejandro Valenzuela garciaNoch keine Bewertungen

- Administración Del Procesador (Scheduling) - Universidad Católica Andrés BelloDokument48 SeitenAdministración Del Procesador (Scheduling) - Universidad Católica Andrés Bellodarioleonz0% (1)

- Segundo Trabajo Especial SODokument31 SeitenSegundo Trabajo Especial SOLuis MartinezNoch keine Bewertungen

- Administración de procesos en SODokument9 SeitenAdministración de procesos en SODavid Paredes CapetilloNoch keine Bewertungen

- Taller 3 - PlanificadoresDokument4 SeitenTaller 3 - PlanificadoresGiovanny VarónNoch keine Bewertungen

- Gestión de procesos en sistemas operativosDokument5 SeitenGestión de procesos en sistemas operativosJuanjoNoch keine Bewertungen

- Planificacion de ProcesosDokument13 SeitenPlanificacion de ProcesosLuis SandovalNoch keine Bewertungen

- 5 SO Teo ProcesosDokument23 Seiten5 SO Teo ProcesosCesar GaviriaNoch keine Bewertungen

- Gestión de ProcesosDokument22 SeitenGestión de ProcesosServio Arnaldo Vanegas VásquezNoch keine Bewertungen

- Cuestionario SO - Semana 8Dokument6 SeitenCuestionario SO - Semana 8PabloNoch keine Bewertungen

- Sistema Op 5Dokument7 SeitenSistema Op 5Henry GarciaNoch keine Bewertungen

- Tarea Unidad IIDokument13 SeitenTarea Unidad IIBrandon Torres IriarteNoch keine Bewertungen

- UNIDAD 2 Administración de Procesos y Del ProcesadorDokument6 SeitenUNIDAD 2 Administración de Procesos y Del ProcesadorMiguel Jose Gonzalez BeaurregardNoch keine Bewertungen

- Gestión de procesos y estados del ciclo de vida de un procesoDokument8 SeitenGestión de procesos y estados del ciclo de vida de un procesoHector Jafet PuelloNoch keine Bewertungen

- Matriz de Evaluacion 3, Competencia 2, Avance de ProyectoDokument8 SeitenMatriz de Evaluacion 3, Competencia 2, Avance de ProyectoEquipo CuasimodosNoch keine Bewertungen

- Pre Laboratorio 3Dokument4 SeitenPre Laboratorio 3Jose Miguel ValeraNoch keine Bewertungen

- Trabajo 2 ColaborativoDokument8 SeitenTrabajo 2 ColaborativorenzoNoch keine Bewertungen

- Proceso, Hilos, Planificación de Procesos.Dokument8 SeitenProceso, Hilos, Planificación de Procesos.Patrick Ricardo ChacónNoch keine Bewertungen

- Job ShudelingDokument12 SeitenJob ShudelingcocoNoch keine Bewertungen

- UNIDAD 2 Sistemas OperativosDokument36 SeitenUNIDAD 2 Sistemas OperativosCarlos Gonzalez0% (1)

- 258 PitterDokument23 Seiten258 Pitterjose perezNoch keine Bewertungen

- Planificacion en Sistemas OperativosDokument16 SeitenPlanificacion en Sistemas OperativosRicardoOmarRomeroRamosNoch keine Bewertungen

- Resumes S.ODokument15 SeitenResumes S.ODaniel OrtizNoch keine Bewertungen

- Niveles, Objetivos y Criterios de PlanificaciónDokument27 SeitenNiveles, Objetivos y Criterios de Planificaciónlelouch4Noch keine Bewertungen

- Renzo.... (Autoguardado)Dokument6 SeitenRenzo.... (Autoguardado)yulexiNoch keine Bewertungen

- Planificación de Procesos en Sistemas OperativosDokument4 SeitenPlanificación de Procesos en Sistemas OperativosYANELI GAITANNoch keine Bewertungen

- So 4Dokument8 SeitenSo 4Yeray FernandezNoch keine Bewertungen

- Paso 3 - Grupo-22 - Andres Felipe RiosDokument8 SeitenPaso 3 - Grupo-22 - Andres Felipe RiosShi No Datenshi100% (1)

- Procesos de Sistemas OperativosDokument10 SeitenProcesos de Sistemas OperativosMiguel kunfupandaNoch keine Bewertungen

- Hilos y algoritmos de planificación en 40Dokument7 SeitenHilos y algoritmos de planificación en 40Lily Corina SaucaNoch keine Bewertungen

- Procesos y Administración Del ProcesadorVer2-1Dokument13 SeitenProcesos y Administración Del ProcesadorVer2-1Onaldo José Quintana WuizeNoch keine Bewertungen

- Sist Operativo3Dokument16 SeitenSist Operativo3Luis SantamariaNoch keine Bewertungen

- Niveles de PlanificaciónDokument8 SeitenNiveles de PlanificaciónAndy SilvaNoch keine Bewertungen

- Gestión de ProcesosDokument8 SeitenGestión de ProcesosWesliR7Noch keine Bewertungen

- Scheduling Alvarez Caiza RamosDokument6 SeitenScheduling Alvarez Caiza RamosWilson Gabriel Ramos BravoNoch keine Bewertungen

- Tema - Planificación de ProcesosDokument7 SeitenTema - Planificación de ProcesosTelmo EstradaNoch keine Bewertungen

- Estado DORMIDO y semáforosDokument9 SeitenEstado DORMIDO y semáforosMakova DiyeyNoch keine Bewertungen

- Trabajo Planificacion de ProcesosDokument17 SeitenTrabajo Planificacion de ProcesoselixNoch keine Bewertungen

- DE PROGRAMAS A PROCESOSDokument7 SeitenDE PROGRAMAS A PROCESOSPATRICIO BORDONNoch keine Bewertungen

- Taller Diagnostico SDDokument7 SeitenTaller Diagnostico SDJuan Camilo Barreto MateusNoch keine Bewertungen

- Administracion de Procesos KevDokument9 SeitenAdministracion de Procesos KevKevin LaraNoch keine Bewertungen

- Unidad 2 Sistemas OperativosDokument72 SeitenUnidad 2 Sistemas OperativosRobert MendozaNoch keine Bewertungen

- Unidad 4 Procesos Y Administración Del ProcesadorDokument12 SeitenUnidad 4 Procesos Y Administración Del ProcesadorLuis Eliecer EscorciaNoch keine Bewertungen

- Ensayo Gestion de ProcesosDokument8 SeitenEnsayo Gestion de ProcesosKaren JimenezNoch keine Bewertungen

- Desarrollo de componentes software para servicios de comunicaciones. IFCT0609Von EverandDesarrollo de componentes software para servicios de comunicaciones. IFCT0609Noch keine Bewertungen

- Desarrollo y optimización de componentes software para tareas administrativas de sistemas. IFCT0609Von EverandDesarrollo y optimización de componentes software para tareas administrativas de sistemas. IFCT0609Noch keine Bewertungen

- Informe de AdministraciónDokument4 SeitenInforme de AdministraciónLasColinas TurbacoNoch keine Bewertungen

- Charla de Gases TóxicosDokument15 SeitenCharla de Gases TóxicosIsol Clarett Nieves TorbettNoch keine Bewertungen

- Introduccion e Instrumentos de MedidasDokument245 SeitenIntroduccion e Instrumentos de MedidasI-ván F Zandalio100% (1)

- Lectura 4.4 - Planes CSPDokument3 SeitenLectura 4.4 - Planes CSPShirly Johana Julio JimenezNoch keine Bewertungen

- Diametro de Los Dilatadores UretralesDokument2 SeitenDiametro de Los Dilatadores UretralesMonserrath SantoyoNoch keine Bewertungen

- Normas de seguridad para soldadura eléctrica (menos deDokument3 SeitenNormas de seguridad para soldadura eléctrica (menos dejosetoapantaNoch keine Bewertungen

- Carbonato de Calcio Práctica de LaboratorioDokument7 SeitenCarbonato de Calcio Práctica de LaboratorioJose PerezNoch keine Bewertungen

- Ponencias JASL2Dokument52 SeitenPonencias JASL2manuel_palomo1018Noch keine Bewertungen

- Práctica 11 - Resonancia Rev1Dokument4 SeitenPráctica 11 - Resonancia Rev1Liz CampoverdeNoch keine Bewertungen

- TesisDokument129 SeitenTesisEnrique BarragánNoch keine Bewertungen

- GUIA de TP - 01 - Parametros ELECTRICOsDokument2 SeitenGUIA de TP - 01 - Parametros ELECTRICOsmatialmazanNoch keine Bewertungen

- Semana 8-TALLER Diagrama de MódulosDokument1 SeiteSemana 8-TALLER Diagrama de Módulosjuan eduardoNoch keine Bewertungen

- DISEÑO Y CONSTRUCCION DE TUBERIASDokument8 SeitenDISEÑO Y CONSTRUCCION DE TUBERIASIsrael Avendaño AguilarNoch keine Bewertungen

- Tema 13Dokument17 SeitenTema 13EDDY GONZALO QUEA MAMANINoch keine Bewertungen

- Base de Datos Frann.......Dokument36 SeitenBase de Datos Frann.......Frann HRNoch keine Bewertungen

- Cálculo de Entalpías MolaresDokument51 SeitenCálculo de Entalpías MolaresNelson Estela ValenzuelaNoch keine Bewertungen

- Manipulación de CilindrosDokument4 SeitenManipulación de CilindrosAngel Reventon MendozaNoch keine Bewertungen

- Manual tortilladora MLRDokument9 SeitenManual tortilladora MLRjose floresNoch keine Bewertungen

- Vitruvio y los 10 libros de arquitecturaDokument22 SeitenVitruvio y los 10 libros de arquitecturaMaiteCeballos100% (4)

- 5 Administración de Proyectos Industriales Semana 5 PDFDokument20 Seiten5 Administración de Proyectos Industriales Semana 5 PDFLuis Vi llamar malvaezNoch keine Bewertungen

- Partes de Torno y NCNDokument9 SeitenPartes de Torno y NCNEnrique Gonzalez HerreraNoch keine Bewertungen

- Extensión de registros hidrológicos cortos usando modelos bivariadosDokument25 SeitenExtensión de registros hidrológicos cortos usando modelos bivariadosANDRES AUGUSTO JUNIOR CAJA YNGANoch keine Bewertungen

- 01 Curvado 60x40Dokument1 Seite01 Curvado 60x40Alfonsina ReyesNoch keine Bewertungen

- Configuracion Base ComunDokument3 SeitenConfiguracion Base ComunjoseNoch keine Bewertungen

- Libro de Electricidad Gustavo 2017 Pick 2Dokument104 SeitenLibro de Electricidad Gustavo 2017 Pick 2Luis Gustavo Perez SanhuezaNoch keine Bewertungen