Beruflich Dokumente

Kultur Dokumente

Conte Nidos

Hochgeladen von

ana0 Bewertungen0% fanden dieses Dokument nützlich (0 Abstimmungen)

19 Ansichten7 Seitenecuaciones

Copyright

© © All Rights Reserved

Verfügbare Formate

DOCX, PDF, TXT oder online auf Scribd lesen

Dieses Dokument teilen

Dokument teilen oder einbetten

Stufen Sie dieses Dokument als nützlich ein?

Sind diese Inhalte unangemessen?

Dieses Dokument meldenecuaciones

Copyright:

© All Rights Reserved

Verfügbare Formate

Als DOCX, PDF, TXT herunterladen oder online auf Scribd lesen

0 Bewertungen0% fanden dieses Dokument nützlich (0 Abstimmungen)

19 Ansichten7 SeitenConte Nidos

Hochgeladen von

anaecuaciones

Copyright:

© All Rights Reserved

Verfügbare Formate

Als DOCX, PDF, TXT herunterladen oder online auf Scribd lesen

Sie sind auf Seite 1von 7

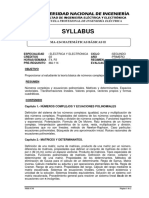

CONTENIDOS

1. Matrices: 1.1 Operaciones con matrices. 1.2 Escalonamiento

de Matrices (Método de Gauss). 1.3 Rango de una matriz. 1.4

Inversa de una matriz. 1.5 Determinante de una matrizz

Una matriz de orden o tamaño m por n , con elementos en un cuerpo K , es un conjunto

de m×n escalares (o elementos del cuerpo) ordenados en m filas y n columnas.

Comenzamos estudiando distintos tipos de matrices y en la Sección 1.1 se presentan las

operaciones básicas: suma de matrices y producto de un escalar por una matriz. Estas

dos operaciones cumplen una serie de propiedades con las que estamos familiarizados

ya que son propiedades (pág. 6) de los cuerpos de números reales y complejos, que

confieren al conjunto de matrices estructura de espacio vectorial. También se estudia el

producto de matrices, de tamaño adecuado, una operación que no cumple algunas de las

propiedades "buenas" de las operaciones anteriores. Por ejemplo, el producto no es

conmutativo: AB≠BA, en general. A veces, para simplificar el producto de matrices

resulta interesante contemplar las matrices por "trozos": a esto lo llamamos división por

cajas o bloques de una matriz.

La Sección 1.2 se dedica al conocido como Método de Gauss que sirve para

transformar una matriz A en otra más sencilla B manteniendo ambas propiedades

similares más fáciles de estudiar en B que en A . El método consiste en cambiar las filas

de una matriz mediante la aplicación de operaciones elementales (pág. 16) que

consisten en:

(1) Intercambiar dos filas.

(2) Sumarle a una fila otra multiplicada por un escalar.

(3) Multiplicar una fila por un escalar no nulo.

Cada operación elemental tiene asociada una matriz elemental que es el resultado de

aplicar a la matriz identidad dicha operación elemental. De modo que, aplicarle a una

matriz una operación elemental en sus filas es equivalente a multiplicarla por la

izquierda por la matriz elemental asociada (pág. 17).

Cuando mediante un número finito e operaciones elementales de filas podemos

transformar una matriz A en otra matriz B , decimos que A y B son equivalentes por

filas. De entre todas las matrices equivalentes por filas a una matriz A nos interesan

dos: las matrices escalonadas y la matriz escalonada reducida (esta última es única).

Llamamos Método de Gauss al algoritmo que transforma una matriz en una escalonada

(Teorema 1.24), y Método de Gauss-Jordan al que transforma una matriz en su matriz

escalonada reducida equivalente (forma de Hermite por filas, pág. 25).

En la Sección 1.3 se estudia el rango de una matriz, que es el número de filas

independientes que tiene. Resulta que el rango de dos matrices equivalentes por filas es

igual, y que el rango de una matriz escalonada es igual al número de filas no nulas. Por

lo que el rango de una matriz es igual al número de filas no nulas de cualquier matriz

escalonada equivalente (Corolario 1.44) y esta caracterización es el método más

eficiente de cálculo del rango. En esta sección se estudia también el comportamiento

del rango respecto a las operaciones con matrices (Teorema 1.53).

Todo lo hecho por filas, puede hacerse también por columnas y se cumplen las mismas

propiedades, de modo que se puede definir una equivalencia entre matrices si podemos

pasar de una a otra utilizando operaciones elementales de filas y/o de columnas.

En la Sección 1.4 se estudian los casos de existencia de elemento inverso para el

producto entre matrices cuadradas. Una matriz A se dice que es invertible o regular si

tiene elemento inverso para el producto, es decir si existe otra matriz A-1 tal que AA-1=A-

1A=I. Entre los ejemplos de matrices invertibles están las matrices elementales. Se

tienen distintas caracterizaciones de las matrices inversas (Teorema 1.68) y un método

de cálculo eficiente de la inversa utilizando operaciones elementales por filas o por

columnas (pág. 44). Terminamos la sección con el concepto deinversas laterales para

matrices no cuadradas.

En la Sección 1.5 se estudia el concepto de determinante de una matriz cuadrada, así

como distintas reglas de cálculo: bien sea recurriendo al método de escalonamiento de

Gauss o bien utilizando el desarrollo por una fila o columna a lo que llamamos Método

de Laplace. El determinante de una matriz triangular se calcula trivialmente como el

producto de los elementos de la diagonal, y el método de escalonamiento simplificará el

cálculo del determinante convirtiendo una matriz cuadrada en escalonada (en particular

triangular). Esto se puede hacer porque las operaciones elementales se comportan bien

respecto al determinante (Proposiciones 1.75, 1.77 y 1.80). Mediante el determinante se

obtiene la siguiente caracterización de las matrices invertibles: A tiene inversa si y sólo

si det(A)≠0 (Teorema 1.84). El determinante se comporta bien respecto al producto y

trasposición de matrices:

det (A B)=det(A) det(B) y det(A)=det(At) .

Dos aplicaciones directas del determinante son:

- El cálculo (poco eficiente) de la inversa según la fórmula A-1=Adj(A)t /det(A) (pág.

59).

- El estudio del rango de una matriz por menores (pág. 61).

2. Sistemas Lineales: 2.1 Representación matricial . 2.2

Resolución de sistemas lineales por escalonamiento. 2.3

Teorema de Rouché-Frobenius.

En este tema se estudian métodos de resolución de sistemas de ecuaciones lineales, o

simplemente sistemas lineales.

Una ecuación lineal en n incógnitas x1,…,xn tiene una expresión de la

forma a1x1+…+anxn=b donde los a1,…,an se llaman coeficientes y son escalares

(números) o elementos de un cuerpo K que será el de los números reales R, o el de los

complejos C. El término b es un escalar del mismo cuerpo y se denomina término

independiente. Cuando b=0 la ecuación se dice que es homogénea. Una solución de la

ecuación anterior es una lista ordenada de n escalares (c1,…,cn) que son valores que

sustituidos en las n incógnitas x1,…,xn cumplen la ecuación.

Un sistema lineal es un conjunto de varias ecuaciones lineales, en las mismas

incógnitas, que tienen que cumplirse a la vez y dos sistemas se dicen equivalentes si

tienen las mismas soluciones.

El objetivo de esta Unidad Didáctica es encontrar métodos para decidir si un sistema

lineal tiene o no soluciones (discusión de un sistema), y en caso afirmativo encontrarlas

todas (resolución de un sistema). Para ello, vamos a utilizar representaciones

matriciales de los sistemas que se escriben de forma abreviada como

AX=B

Siendo A la matriz de coeficientes, X la matriz de incógnitas y B la matriz de términos

independientes. A la matriz que resulta de añadir a A la columna B se la denomina

matriz ampliada y se denota por (A|B). Cada fila de la matriz (A|B) representa una

ecuación del sistema. Los resultados de este capítulo ya son de sobra conocidos de

cursos preuniversitarios. Ahora, simplemente formalizamos y demostramos los

resultados teóricos que se aplican en la práctica.

Un sistema lineal se dice que es escalonado si la matriz ampliada (A|B) es escalonada.

Estos sistemas se resuelven con gran facilidad (pág. 75).

El método que emplearemos para discutir y resolver un sistema AX=B será el de

transformarlo en otro escalonado equivalente A' X = B' . Esto podremos hacerlo

aplicando el método de Gauss a la matriz (A|B) hasta obtener otra escalonada

equivalente (A' | B') . El Teorema 2.5, pág. 73, nos dice que si las matrices ampliadas de

dos sistemas lineales son equivalentes por filas, entonces los sistemas lineales son

equivalentes, es decir tienen las mismas soluciones. Las operaciones elementales se

hacen sólo en filas (que representan las ecuaciones), ¡ojo! aquí no se pueden utilizar

operaciones por columnas.

Con los resultados conocidos sobre el rango de matrices y sabiendo que éste se conserva

por operaciones elementales, se tiene como consecuencia directa el Teorema de

Rouché-Frobenius (pág. 81) que permite discutir un sistema AX=B comparando los

rangos de las matrices A y (A|B) .

El capítulo 2 del libro de texto incluye una sección sobre la conocida como

factorización LU. Método que se aplica para resolver de forma eficiente, o bien sistemas

con un número grande de variables, o bien baterías de sistemas lineales de la forma

AX=B , con B variando y A fija. Se recomienda la lectura de esta sección, aunque no

será materia de examen.

3. Espacios vectoriales: 3.1 Espacios vectoriales reales y

complejos 3.2 Dependencia e independencia lineal de vectores.

Rango. Sistema generador, base y dimensión. 3.3 Coordenadas

y matrices de cambio de base. 3.4 Subespacios vectoriales.

Ecuaciones paramétricas e implícitas. 3.5 Suma e intersección

de subespacios. 3.6 Espacio vectorial cociente módulo un

subespacio.

El conjunto de soluciones de un sistema lineal así como el conjunto de las matrices de

un orden dado tienen propiedades comunes: la combinación lineal de dos soluciones de

un sistema es otra solución del sistema, y la combinación lineal de dos matrices del

mismo orden es otra matriz del mismo orden. Estas "combinaciones lineales" son la

base del Método de Gauss que ha impregnado hasta ahora -y lo seguirá haciendo- todo

lo visto.

Generalizando lo que ha pasado con los sistemas lineales y las matrices, aparece la

estructura abstracta de espacio vectorial. Las combinaciones lineales de los elementos

de un espacio vectorial, a los que llamaremos vectores, producen nuevos elementos de

dicho espacio, nuevos vectores. Así, los conjuntos de matrices o de soluciones de

sistemas lineales son ejemplos de espacios vectoriales.

Comenzamos con el concepto abstracto de espacio vectorial V , que es una estructura

algebraica ligada a un cuerpo de números K que será el de los reales: ¿, o el de los

complejos C . En el espacio vectorial se podrán operar sus elementos entre sí (la

operación normalmente se denotará como "+") y se podrán multiplicar por los

elementos del cuerpo, a los que se llamará escalares; de modo que las operaciones

cumplan las 8 propiedades enunciadas en la pág. 89.

A los elementos del espacio vectorial V se les suele denotar por letras latinas como u, v,

w… o también x, y, z… ; mientras que se suelen utilizar las letras griegas α, β, γ o

también λ (lambda), μ (mu)..., para denotar a los escalares.

Un espacio vectorial que jugará un papel importante será Kn=Rn o Cn formado por

secuencias ordenadas de n elementos de K , también llamadas n -uplas. Esto es Kn={

(x1,…,xn) : xi∈K} .

En la Sección 3.1 conoceremos los conceptos más importantes del espacio vectorial:

combinación lineal, dependencia e independencia lineal de vectores. Será

importantísimo tenerlos muy claros.

Desde la Sección 3.2 centraremos el estudio en los espacios vectoriales de tipo finito o

de dimensión finita, que son los únicos que trabajaremos en este curso. En un

espacio vectorial de dimensión finita se puede encontrar un conjunto finito de

vectores {v1,…,vk} , de modo que podamos obtener todos los vectores del espacio

mediante combinaciones lineales de ellos. A un conjunto de vectores tal se le

denomina sistema generador o sistema de generadores (pág. 98). Estaremos

interesados en encontrar sistemas generadores que tengan el número mínimo de

vectores, a los que llamaremos bases, y que estarán caracterizados por el hecho de que

los vectores sean linealmente independientes. Todas las bases de un espacio vectorial

tienen el mismo número de elementos al que se denomina dimensión (Teorema 3.18,

pág. 101), y todo conjunto de vectores linealmente independiente se puede ampliar hasta

obtener una base (Teorema de ampliación de la base, pág. 104).

Dada una base B={v1,v2,…,vn} de un K -espacio vectorial V de dimensión n , se

cumple que cualquier vector v de V se puede escribir de modo único como combinación

lineal de los elementos de la base

v=x1v1+…+xnvn ,

con x1,…,xn escalares, a los que se denomina coordenadas de v en la base B. Este

hecho es importantísi-mo pues permite, fijada una base B , identificar todo vector con

sus coordenadas respecto a dicha base, lo que expresaremos del siguiente modo:

v = (x1,…,xn)B

"v es el vector de coordenadas (x1,…,xn) r especto de la base B ". Así, se representan los

vectores de un espacio vectorial mediante elementos de Kn , facilitando su manipulación

y el uso de matrices para el estudio de espacios y subespacios.

La Sección 3.4 se dedica al rango de un conjunto de vectores que es el mayor número de

vectores linealmente independientes que contiene. Una forma muy cómoda de estudiar

el rango es representar los vectores mediante coordenadas, disponerlos en las filas de

una matriz, y estudiar el rango de la matriz.

Un mismo vector v tiene distintas coordenadas respecto de distintas bases B y B', y

podemos obtener una matriz que nos permita obtener las coordenadas de un vector en

una base dada B’ , conocidas sus coordenadas en otra base B, se hace a utilizando una

matriz que se denomina matriz de cambio de base de B a B’ (pág. 113). Esto se hará

en la Sección 3.5.

En la sección 3.6 nos interesaremos por los subconjuntos no vacíos U de un espacio

vectorial V que, en sí mismos, tienen estructura de espacio vectorial, a los que

llamaremos subespacios vectoriales (pág. 116). Todos ellos contienen al vector 0. Si

{u1,…,um} es un sistema generador de un subespacio U , lo denotaremos

por U=L(u1,…,um) . De un subespacio vectorial nos interesará determinar un sistema

generador, una base y su dimensión.

La representación de vectores mediante coordenadas respecto de una B , permite

también definir cualquier subespacio vectorial U, de un espacio vectorial V, como el

conjunto de vectores cuyas coordenadas son el conjunto de soluciones de un sistema de

ecuaciones lineales homogéneo, al que llamaremos ecuaciones implícitas o

cartesianas del subespacio respecto de B . Las ecuaciones son condiciones que tienen

que cumplir las coordenadas de un vector para que pertenezca al subespacio. El

conjunto de soluciones de las ecuaciones implícitas se denominan ecuaciones

paramétricas del subespacio y a partir de ellas se puede determinar fácilmente una

base.

Una vez que se tiene una representación de los subespacios vectoriales mediante

ecuaciones y de los vectores mediante coordenadas - todo ello relativo a una base fijada-

, en las Secciones 3.8 y 3.9 se construyen nuevos subespacios vectoriales haciendo

distintos tipos de operaciones con ellos:

- Intersección de subespacios

- Suma de subespacios

- Cociente módulo un subespacio.

4. Aplicaciones lineales: 4.1 Aplicación lineal. Subespacios

Núcleo e Imagen. 4.2 Tipos de aplicaciones lineales. 4.3

Representación matricial. 4.4 Endomorfismos. 4.5

Proyecciones y Simetrías. 4.6 Espacio dual.

En esta unidad didáctica se estudiarán la aplicaciones propias entre espacios vectoriales.

Dados dos espacios vectoriales de dimensión finita U y V definidos sobre el mismo

cuerpo K , una aplicación f:U→V es lineal si transforma combinaciones lineales de

vectores del espacio de partida U en combinaciones lineales del espacio V de llegada:

f(αu+βv)=αf(u)+βf(v) , para todo u, v∈U; α,β∈K .

Se dice que f respeta la estructura de los espacios vectoriales. A las aplicaciones lineales

también se les llama homomorfismos vectoriales. Una de las características de estas

aplicaciones es que transforman el cero del espacio vectorial de partida en el cero del

espacio vectorial de llegada: f(0U)=0V , aunque, igual que en el texto base, cuando no se

produzca ambigüedad prescindiremos de la notación con subíndices y llamaremos 0 al

elemento neutro de todo espacio vectorial, ya sea una matriz, un polinomio, una

aplicación o un elemento de Kn .

Por cómo se comportan las aplicaciones lineales respecto a las combinaciones lineales

de vectores, ocurre que conservan la dependencia lineal: si u1,…,un son vectores

linealmente dependientes en U , entonces sus imágenes f(u1),…,f(un) son vectores

linealmente dependientes en V (eso no ocurre con la independencia lineal en general), y

como consecuencia una aplicación lineal queda completamente determinada conocidas

las imágenes de los vectores de una base del espacio de partida (pág. 147).

El conjunto formado por todas las aplicaciones lineales entre dos espacios

vectoriales U y V de denota por L(U,V) y tiene estructura de espacio vectorial para la

suma de aplicaciones y el producto de una aplicación por un escalar.

Existen dos subespacios vectoriales asociados a una aplicación lineal dada f:U→V

denominados núcleo e imagen. Elnúcleo de f es el conjunto de vectores de U cuya

imagen es el 0 de V y se suele denotar por Ker f={ u∈U: f(u)=0}⊂U. "Ker" viene de

kernel, núcleo en inglés. Y la imagen de f que es el subespacio vectorial de V formado

por todas las imágener de los vectores de U:

Im f = { f(v): v∈U }⊂V

Las dimensiones de estos subespacios guardan la siguiente relación (pág. 152):

Fórmula de dimensiones: dim Ker f + dim Im f = dimU.

El estudio de estos subespacios vectoriales permite clasificar las aplicaciones en los

siguientes tipos:

Inyectivas o monomorfismos: si Ker f = {0} .

Suprayectivas (o sobreyectivas ) o epimorfismos: si Im f= V

Biyectivas o isomorfismos: inyectivas y sobreyectivas a la vez.

Cuando los espacios de partida y de llegada coinciden, esto es f:V→V entonces se

dice que f es un endomorfismo y cuando es biyectivo se le llama automorfismo.

Otra de las operaciones entre aplicaciones lineales es la composición. Para realizar

la composición de dos aplicaciones lineales f y g tenemos que tener espacios

vectoriales U , V y W (no necesariamente distintos) definidos sobre el mismo cuerpo K .

Si f:U→V y g:V→W entonces podemos definir la aplicación f compuesta con g, que se

denota por g º f del siguiente modo g º f:U→W , ( gº f)(v):=g(fv), para todo v∈U .

El Primer Teorema de Isomorfía (pág. 158) nos dice que toda aplicación lineal f se

puede descomponer como la composición de 3 aplicaciones canónicamente asociadas a

ella: una sobreyectiva, una biyectiva y una tercera inyectiva.

En la Sección 4.3 se describen las aplicaciones lineales f:U→V mediante ecuaciones y

matrices que relacionan las coordenadas de vectores respecto a bases fijadas B y B' en

los espacios de partida y de llegada, respectivamente. Si u∈U, con coordenadas u =

(x1,…,xn)B y su imagen es el vector f(u) = (y1,…,yn)B' ∈ V , entonces existe una única

matriz MBB´(f) de orden m×n que cumple:

(y1 … yn)t = MBB´(f) (x1 … xn)t → de forma abreviada Y=MX

para todo u∈U . A esta expresión la denominaremos ecuaciones de f respecto de las

bases B y B' , y MBB´(f) es la matriz de f respecto de las bases B y B' . Las columnas de

dicha matriz están formadas por las coordenadas en B' de las imágenes de los vectores

de B. Estaremos interesados en obtener matrices de una misma aplicación en distintas

bases, y veremos cómo se relacionan dichas matrices con las matrices de cambio de

base o de cambio de coordenadas.

Se dedica la Sección 4.4 al estudio de los endomorfismos o aplicaciones lineales de un

espacio vectorial en sí mismo. En estos casos se considera la misma base en el espacio

de partida y de llegada, que son el mismo Las matrices de un endomorfismo en distintas

bases son matrices semejantes (. En la Sección 4.5 se estudian dos tipos de

endomorfismos que tienen especial interés: las proyecciones y las simetrías.

La última Sección, la 4.6, se dedica al estudio del espacio dual V* asociado a un K -

espacio vectorial V . El dual está formado por todas las aplicaciones lineales f:V→K ,

llamadas formas lineales. La dimensión de V y V* coincide, y a partir de una

base B de V se puede obtener una base de V* , canónicamente asociada , denominada

base dual. También se estudiará la relación existente entre los elementos de V* y los

hiperplanos de V.

Das könnte Ihnen auch gefallen

- Hoja 1 - Matrices y Sist. Ec. Lin. SolucionesDokument7 SeitenHoja 1 - Matrices y Sist. Ec. Lin. SolucionesFrancisco Javier Peña HernándezNoch keine Bewertungen

- PEC Curso 2020 2021 (Resolución)Dokument6 SeitenPEC Curso 2020 2021 (Resolución)AlexeyNoch keine Bewertungen

- Formas Bilineales y CuadráticasDokument11 SeitenFormas Bilineales y Cuadráticascl4d10Noch keine Bewertungen

- Ejercicios Resuelto Matrices y Sistemas de EcuacionesDokument4 SeitenEjercicios Resuelto Matrices y Sistemas de EcuacionesJaviera VejarNoch keine Bewertungen

- Capítulo Xvi Modelos de Ecuaciones Multiples Ii PDFDokument81 SeitenCapítulo Xvi Modelos de Ecuaciones Multiples Ii PDFpolojorge200% (1)

- 3.transformaciones Lineales PDFDokument50 Seiten3.transformaciones Lineales PDFSofía Harriet De SantiagoNoch keine Bewertungen

- Geogebra IIIDokument26 SeitenGeogebra IIIsanti1212Noch keine Bewertungen

- Evaluacion Und 3 FinalDokument8 SeitenEvaluacion Und 3 FinalYised Buitrago CardonaNoch keine Bewertungen

- Tarea4 208046 345 JuanSaavedraTejadaDokument22 SeitenTarea4 208046 345 JuanSaavedraTejadaJUAN PABLO SAAVEDRA TEJADANoch keine Bewertungen

- HC ASUC01108 Algebra Matricial y Geometria-Analitica 2022Dokument16 SeitenHC ASUC01108 Algebra Matricial y Geometria-Analitica 2022ELIAS ZUNIGA TACACNoch keine Bewertungen

- Álgebra Lineal Parte 2Dokument50 SeitenÁlgebra Lineal Parte 2Rivera VictorNoch keine Bewertungen

- Tarea 2 - Ejercicios - Trabajo Colaborativo...Dokument36 SeitenTarea 2 - Ejercicios - Trabajo Colaborativo...Juliana ContrerasNoch keine Bewertungen

- Instrumentación Álgebra Lineal A-D 2021Dokument14 SeitenInstrumentación Álgebra Lineal A-D 2021Brandon Ramirez HernandezNoch keine Bewertungen

- Practica de Algebra Lineal TransformacionesDokument7 SeitenPractica de Algebra Lineal Transformaciones...Noch keine Bewertungen

- JavaDokument5 SeitenJavaCinthia Ramos HerreraNoch keine Bewertungen

- (2-2020) MAT103-SA - Lección 4.5 - Espacios Vectoriales - Base y Dimensión de SubespaciosDokument2 Seiten(2-2020) MAT103-SA - Lección 4.5 - Espacios Vectoriales - Base y Dimensión de SubespaciosJuanJo HazNoch keine Bewertungen

- Incertidumbre InterpolacionDokument13 SeitenIncertidumbre Interpolacionjhon edisson ramirez lopezNoch keine Bewertungen

- 2.3 Bases de Un Espacio VectorialDokument6 Seiten2.3 Bases de Un Espacio Vectorialchuy juarezNoch keine Bewertungen

- Ma 124 Matematicas Basicas IIDokument2 SeitenMa 124 Matematicas Basicas IIalexanderNoch keine Bewertungen

- Sol MatII Tema1 MatricesDokument24 SeitenSol MatII Tema1 Matricesandrei129Noch keine Bewertungen

- Ejercicios Métodos MatemáticosDokument40 SeitenEjercicios Métodos MatemáticosmrpevaNoch keine Bewertungen

- Ensayo Grupo8Dokument18 SeitenEnsayo Grupo8Ariel Set TrujilloNoch keine Bewertungen

- Autovalores y AutovectoresDokument23 SeitenAutovalores y AutovectoresBrunoNoch keine Bewertungen

- Ejercicio 1Dokument39 SeitenEjercicio 1auxo.qa9Noch keine Bewertungen

- TeoriaMatrices PDFDokument20 SeitenTeoriaMatrices PDFJordi Hernandez Gisbert100% (1)

- Algebra Examenes SolDokument22 SeitenAlgebra Examenes SolPedro del moralNoch keine Bewertungen

- Silabo Matematica Basica Ingenieria de SistemasDokument8 SeitenSilabo Matematica Basica Ingenieria de SistemasRaul FerrelNoch keine Bewertungen

- Informe 3Dokument15 SeitenInforme 3delvis mendezNoch keine Bewertungen

- Ejercicio Con Lenguaje RDokument10 SeitenEjercicio Con Lenguaje RGiancarlos Anthony Espíritu BravoNoch keine Bewertungen