Beruflich Dokumente

Kultur Dokumente

Glosario Probabilidad

Hochgeladen von

Ingrid Margeli Nuñez50%(2)50% fanden dieses Dokument nützlich (2 Abstimmungen)

891 Ansichten4 SeitenOriginaltitel

Glosario probabilidad..docx

Copyright

© © All Rights Reserved

Verfügbare Formate

DOCX, PDF, TXT oder online auf Scribd lesen

Dieses Dokument teilen

Dokument teilen oder einbetten

Stufen Sie dieses Dokument als nützlich ein?

Sind diese Inhalte unangemessen?

Dieses Dokument meldenCopyright:

© All Rights Reserved

Verfügbare Formate

Als DOCX, PDF, TXT herunterladen oder online auf Scribd lesen

50%(2)50% fanden dieses Dokument nützlich (2 Abstimmungen)

891 Ansichten4 SeitenGlosario Probabilidad

Hochgeladen von

Ingrid Margeli NuñezCopyright:

© All Rights Reserved

Verfügbare Formate

Als DOCX, PDF, TXT herunterladen oder online auf Scribd lesen

Sie sind auf Seite 1von 4

Glosario

1. Análisis de correlación: se utiliza para medir la intensidad de la asociación

entre las variables numéricas.

2. Análisis de regresión lineal múltiple: nos permite establecer la relación que

se produce entre una variable dependiente Y

y un conjunto de variables independientes (X1, X2, ... XK).

3. Análisis de regresión simple: Nos permite establecer la relación entre una

variable dependiente y una variable independiente.

4. Análisis residual: análisis de los residuales que se usan para determinar si

parecen ser válidas las suposiciones hechas acerca del modelo de regresión.

El análisis de residuales también se usa para identificar observaciones

atípicas y observaciones influyentes.

5. Coeficiente de asimetría Pearson: es un valor que indica la asimetría.

Simbólicamente representada por As.

6. Coeficiente de correlación lineal de Pearson: es un número que mide la

intensidad de la asociación lineal entre dos variables, el coeficiente de

correlación es representado por “r”.

7. Coeficiente de correlación: medida de la intensidad de la relación lineal entre

dos variables.

8. Coeficiente de determinación: es un valor que se obtiene elevando al

cuadrado el coeficiente de correlación, se representa simbólicamente por r2

y puede tomar valores de 0 y 1.

9. Coeficiente de determinación: medida de la bondad de ajuste de la ecuación

de regresión estimada. Se puede interpretar como la proporción de la

variabilidad de la variable dependiente y que es explicada por la ecuación de

regresión estimada.

10. Correlación de rango: Método para hacer análisis de correlación cuando los

datos no están disponibles en forma numérica, pero cuando la información

es suficiente para clasificar los datos.

11. Correlación serial: Existe cuando las observaciones sucesivas a través del

tiempo se relacionan entre sí.

12. Correlación: Es una medida de la relación entre dos o más variables. La

correlación puede tomar valores entre –1 y +1. El valor de –1 representa una

correlación negativa perfecta mientras un valor de +1 representa una

correlación perfecta positiva. Un valor de 0 representa una falta de

correlación

13. Covarianza: es una medida de la asociación lineal entre dos variables

14. Diagrama de dispersión: es un gráfico utilizado para representar la relación

entre valores observados de dos variables numéricas.

15. Diagrama de dispersión: es un tipo de diagrama matemático que utiliza

las coordenadas cartesianas para mostrar los valores de dos variables para

un conjunto de datos.

16. Diagramas de dispersión: grafica de datos bivariados en la que la variable

independiente va en el eje horizontal y la variable dependiente va en el eje

vertical.

17. Ecuación de regresión estimada: estimación de la ecuación de regresión

obtenida a partir de datos muéstrales, empleando el método de mínimos

cuadrados. En la regresión lineal simple, la ecuación de regresión estimada

es Ẏ= b0+b1x.

18. Ecuación de regresión: ecuación que describe como está relacionada la

media o valor esperado de la variable dependiente con la variable

independiente; es la regresión lineal simple E(y)= β0+β1x.

19. Error cuadrado medio: estimación insesgada de la varianza del término del

error ð2. Se denota ECM o s2.

20. Error estándar de estimación: raíz cuadrada del error cuadrado medio, se

denota s. es una estimación de ð2, la desviación estándar del error.

21. Error estándar: es la desviación estándar de la distribución maestral de un

estadístico.

22. Error estándar: es la desviación estándar de la distribución maestral de

un estadístico.

23. Grafica de probabilidad normal: grafica en la que los residuales

estandarizados se grafican contra los puntos normales. Esta grafica ayuda

determinar si parecen ser validas la suposición de que los términos del error

tienen una distribución de probabilidad normal.

24. Graficas de residuales: representación gráfica de los residuales, se usa para

determinar si parecen ser válidas las suposiciones hechas acerca del modelo

de regresión.

25. Intervalo de confianza: estimación por intervalo del valor medio de Y para un

valor dado de X.

26. Intervalo de predicción: estimación por intervalo de un solo valor de Y para

un valor dado de X.

27. Método de mínimos cuadrados: procedimiento empleado para obtener la

ecuación de regresión estimada. El objetivo es minimizar Σ(yi-ẏ1)2.

28. Modelo de regresión: ecuación que describe como están relacionadas Y y X,

más un término del error; en la regresión lineal simple, el modelo de regresión

es Y= β0+β1x+€.

29. Observación atípica: dato u observación que no sigue la tendencia del resto

de los datos.

30. Observación influyente: observación en a que la variable independiente tiene

un valor extremo.

31. Punto de gran influencia: observaciones en la que la variable independiente

tiene valores extremos.

32. Regresión lineal múltiple: El modelo de regresión lineal múltiple sirve para

explicar una variable respuesta continua en términos de varios factores o

variables explicativas continuas.

33. Regresión lineal simple: análisis de regresión en el que participa una variable

independiente y una variable dependiente, y en el que la relación entre estas

variables se aproximan mediante una línea recta.

34. Regresión polinómica: Es un tipo especial de regresión múltiple donde

aparecen como variables independientes una única variable y potencias de

ésta (al cuadrado, al cubo).

35. Regresión: Técnica estadística que relaciona una variable dependiente (y)

con la información suministrada por otra variable independiente (x); ambas

variables deben ser continuas. Si asumimos relación lineal, utilizaremos la

regresión lineal simple. Entre las restricciones de la RLS se incluyen: Los

residuos deben ser normales; las observaciones independientes; la

dispersión de los residuos debe mantenerse a lo largo de la recta de

regresión.

36. Residual estandarizado: valor obtenido al dividir un residual entre su

desviación estándar.

37. Residual i: diferencia que existe entre el valor observado en la variable

dependiente y valor pronosticado empleando la ecuación de regresión

estimada; para la observación i, el residual i es yi-ẏ1.

38. SPEARMAN (rho de Spearman): Coeficiente de correlación ordinal análogo

al coeficiente r de Pearson de correlación lineal.

39. Tabla ANOVA: en el análisis de varianza, tabal que se usa para resumir los

cálculos necesarios en la prueba F de significancia.

40. Variable aleatoria: Variable cuyo resultado varía según la muestra según una

distribución de probabilidad.

41. Variable continua: Aquella que puede tomar una infinidad de valores, de

forma que dados dos valores cualesquiera, también pueda tomar cualquier

valor entre dichos valores.

42. Variable dependiente: la variable que se predice o explicada. Se denota Y

43. Variable dependiente: variable que va a predecir.

Das könnte Ihnen auch gefallen

- Técnicas de Regresión para El Calculo de LaDokument5 SeitenTécnicas de Regresión para El Calculo de LaVicente Banda Zuñiga50% (2)

- Mi Linea Del TiempoDokument2 SeitenMi Linea Del TiempoArely Moran Hernandez100% (1)

- Reporte de Investigacion MacroeconomiaDokument9 SeitenReporte de Investigacion MacroeconomiaAldahir MelendezNoch keine Bewertungen

- Diseño de Losas Con Vigueta y BovedillaDokument6 SeitenDiseño de Losas Con Vigueta y BovedillaMariano DiazNoch keine Bewertungen

- Cuadro Comparativo Aspectos A1 - Legales U1Dokument4 SeitenCuadro Comparativo Aspectos A1 - Legales U1Carlos Daniel100% (1)

- Tarea MercadoDokument3 SeitenTarea MercadorubenNoch keine Bewertungen

- Unidad 3 FinanzasDokument15 SeitenUnidad 3 FinanzasDaniaPadillaNoch keine Bewertungen

- Remuneraciones Con Base Al PuestoDokument1 SeiteRemuneraciones Con Base Al PuestoAlfredo Lopez Lopez100% (2)

- 1.4 Forma Polar y Exponencial de Un Número Complejo.Dokument14 Seiten1.4 Forma Polar y Exponencial de Un Número Complejo.Vrs SerranoNoch keine Bewertungen

- 5.3.2 Centros de Ingresos - ExposiciónDokument23 Seiten5.3.2 Centros de Ingresos - ExposiciónGiise ChavezNoch keine Bewertungen

- 1.4 Medidas de VariacionDokument5 Seiten1.4 Medidas de VariacionfauzNoch keine Bewertungen

- N Servidores Una ColaDokument2 SeitenN Servidores Una ColaNatividad LC100% (1)

- Estadistica Inferencial IIDokument33 SeitenEstadistica Inferencial IINoris Guzmán67% (3)

- Act2 t2Dokument4 SeitenAct2 t2Knd Gmz ChvzNoch keine Bewertungen

- 5.7 Modelos ProbabilísticosDokument8 Seiten5.7 Modelos Probabilísticosirvin cisnerosNoch keine Bewertungen

- Intervalos de Confianza y de Predicción. Regresion MultipleDokument23 SeitenIntervalos de Confianza y de Predicción. Regresion MultipleXisco ArjonaNoch keine Bewertungen

- Sintesis Variables Economicas y Su Afectacion en El Proceso ProductivoDokument12 SeitenSintesis Variables Economicas y Su Afectacion en El Proceso ProductivoAdms Mendieta50% (4)

- Sistemas MecánicosDokument4 SeitenSistemas MecánicoshuberNoch keine Bewertungen

- Analisis ResidualDokument9 SeitenAnalisis ResidualPablo Rocha BastidasNoch keine Bewertungen

- Cuadro Comparativo Tipos de IntervalosDokument4 SeitenCuadro Comparativo Tipos de IntervalosJennifer Mendoza Hermosillo100% (2)

- Definiciones y Terminología de Investigación de OperacionesDokument12 SeitenDefiniciones y Terminología de Investigación de OperacioneslizbethNoch keine Bewertungen

- 4.3.2 HDDokument1 Seite4.3.2 HDKyou MikiNoch keine Bewertungen

- Métodos Estadísticos Contra No ParamétricosDokument4 SeitenMétodos Estadísticos Contra No ParamétricosHernOvNoch keine Bewertungen

- 2 Las Herramientas Estadísticas BásicasDokument43 Seiten2 Las Herramientas Estadísticas BásicasJorge Luis Fasabi RuizNoch keine Bewertungen

- Marco Legal y Ético de Las Finanzas.Dokument3 SeitenMarco Legal y Ético de Las Finanzas.Elizabeth Marín100% (1)

- 3.5 Distribucion de Probabilidad HipergeometricaDokument4 Seiten3.5 Distribucion de Probabilidad HipergeometricaLuis Antonio CastilloNoch keine Bewertungen

- Definición de Subespacio Vectorial y Sus PropiedadesDokument2 SeitenDefinición de Subespacio Vectorial y Sus PropiedadesKati Fernadez Reyes50% (2)

- 1.1 Interés SimpleDokument12 Seiten1.1 Interés SimpleMorro TorresNoch keine Bewertungen

- Exposicion Unidad 2 Funcion AdministrativaDokument13 SeitenExposicion Unidad 2 Funcion AdministrativaKATYA HDEZNoch keine Bewertungen

- Conduccion de EntrevistasDokument2 SeitenConduccion de EntrevistasCitlali Santos Hernandez100% (1)

- 3.3. Enfoques y Estilos ContemporaneosDokument3 Seiten3.3. Enfoques y Estilos Contemporaneosaxel alvaradoNoch keine Bewertungen

- Traslacion y RotacionDokument7 SeitenTraslacion y RotacionING. GUSTAVO HERRERA CONTRERASNoch keine Bewertungen

- 2.1 Modelo Clasico de Series de TiempoDokument6 Seiten2.1 Modelo Clasico de Series de TiempoAntonio Garcia Lopez100% (1)

- 1 Introducción A La Investigacion de OperacionesDokument8 Seiten1 Introducción A La Investigacion de OperacionesDiegoNoch keine Bewertungen

- 5-3 Errores en Los PronosticosDokument5 Seiten5-3 Errores en Los Pronosticospatricia ramirezNoch keine Bewertungen

- Solucion de Casos PracticoaDokument3 SeitenSolucion de Casos Practicoamarcols buysNoch keine Bewertungen

- Políticas Generales de La Empresa SorianaDokument6 SeitenPolíticas Generales de La Empresa SorianaGabriel Torruco100% (2)

- Cuadro SinopticoDokument1 SeiteCuadro Sinopticomildre yasno50% (2)

- Pronosticos CasualesDokument5 SeitenPronosticos Casualesana joachinNoch keine Bewertungen

- Fundamentos Del Costeo Directo Y Absorbente.: Empresas Función ComportamientoDokument1 SeiteFundamentos Del Costeo Directo Y Absorbente.: Empresas Función Comportamientohh2303100% (1)

- Conclusion Unidad 4Dokument3 SeitenConclusion Unidad 4Yadi PerezNoch keine Bewertungen

- Ejemplo 3 - Ejercicio #22 - p.554 - RM - AEDokument7 SeitenEjemplo 3 - Ejercicio #22 - p.554 - RM - AEjulio castilloNoch keine Bewertungen

- 2.9 RugosidadDokument9 Seiten2.9 RugosidadZąiidą 'HernandezNoch keine Bewertungen

- GradientesDokument2 SeitenGradienteslizmarina11Noch keine Bewertungen

- 4.2.1 Escala de MedicionDokument3 Seiten4.2.1 Escala de MedicionIzaac Mendoza100% (1)

- Determinación de La Ecuación de RegresiónDokument1 SeiteDeterminación de La Ecuación de RegresiónMiranda DanNoch keine Bewertungen

- Facultamiento y DelegaciónDokument31 SeitenFacultamiento y DelegaciónDiana MagdalenoNoch keine Bewertungen

- 1.3. Frecuencia de Capitalizacion de Interes Tasa NominalDokument5 Seiten1.3. Frecuencia de Capitalizacion de Interes Tasa NominalHEIDI DAYAN FLORES RAMIREZNoch keine Bewertungen

- 6.2.4 Ventas PersonalesDokument8 Seiten6.2.4 Ventas PersonalesarlyNoch keine Bewertungen

- 3.2.1. y 3.2.2.Dokument4 Seiten3.2.1. y 3.2.2.VICTOR MANUEL VAZQUEZ MARTINEZNoch keine Bewertungen

- La Administración Financiera y Relacionarlo Con Sus Alcances Éticos.Dokument3 SeitenLa Administración Financiera y Relacionarlo Con Sus Alcances Éticos.Luis Angel Perez PerezNoch keine Bewertungen

- Ensayo de Las Perspectivas de Capacitacion y Desarrollo de Los Distintos Niveles Jerarquicos de La EmpresaDokument4 SeitenEnsayo de Las Perspectivas de Capacitacion y Desarrollo de Los Distintos Niveles Jerarquicos de La EmpresaVeronica Diaz Alvaro75% (4)

- 3.1 Características de La DemandaDokument21 Seiten3.1 Características de La DemandaAlvaro HernandezNoch keine Bewertungen

- 2.5 Técnicas de Regresión para El Cálculo de La Oferta y de La Demanda.Dokument3 Seiten2.5 Técnicas de Regresión para El Cálculo de La Oferta y de La Demanda.Ana Perez100% (1)

- Unidad 4 Estadistica InferencialDokument6 SeitenUnidad 4 Estadistica InferencialIzamar Garcia Rodriguez75% (4)

- Ejercicio para Anexar A La Carpeta de EvidenciasDokument13 SeitenEjercicio para Anexar A La Carpeta de EvidenciasYezica ChanNoch keine Bewertungen

- Ensayo "Importancia Del Desarrollo de Capital Humano"Dokument4 SeitenEnsayo "Importancia Del Desarrollo de Capital Humano"AkIrA NakamarUNoch keine Bewertungen

- Caracteristica de La Serie de TiempoDokument2 SeitenCaracteristica de La Serie de TiempoMariana ElguezabalNoch keine Bewertungen

- Regresion LinealDokument28 SeitenRegresion LinealAlexandro Barradas DíazNoch keine Bewertungen

- Regresion LinealDokument28 SeitenRegresion Linealvcamposr100% (1)

- Análisis de RegresiónDokument5 SeitenAnálisis de RegresiónMARLON CATAGUANoch keine Bewertungen

- EstaticaDokument15 SeitenEstaticaLuis Fernando BatistaNoch keine Bewertungen

- Informacion para Diapositivas de Sociedad de Responsabilidad Limitada. MARCO LEGALDokument4 SeitenInformacion para Diapositivas de Sociedad de Responsabilidad Limitada. MARCO LEGALIngrid Margeli NuñezNoch keine Bewertungen

- TopografíaDokument3 SeitenTopografíaIngrid Margeli NuñezNoch keine Bewertungen

- TrbajoDokument45 SeitenTrbajoIngrid Margeli NuñezNoch keine Bewertungen

- Cálculo de La Demanda Diaria Proyecto DiegoDokument12 SeitenCálculo de La Demanda Diaria Proyecto DiegoIngrid Margeli NuñezNoch keine Bewertungen

- Cuadro ComparativoDokument8 SeitenCuadro ComparativoIngrid Margeli NuñezNoch keine Bewertungen

- IngridDokument9 SeitenIngridIngrid Margeli NuñezNoch keine Bewertungen

- 4.3 Deformación de La Corteza TerrestreDokument4 Seiten4.3 Deformación de La Corteza TerrestreIngrid Margeli NuñezNoch keine Bewertungen

- MoireDokument9 SeitenMoireIngrid Margeli NuñezNoch keine Bewertungen

- Resumen Dinamica 2Dokument4 SeitenResumen Dinamica 2Ingrid Margeli NuñezNoch keine Bewertungen

- Guia 3 - INSTALACION DE PROGRAMASDokument78 SeitenGuia 3 - INSTALACION DE PROGRAMASIvan Dario RubianoNoch keine Bewertungen

- Arturo Sanchez LimonesDokument8 SeitenArturo Sanchez Limoneskamo5Noch keine Bewertungen

- Proceso Dirección de Formación Profesional Integral Formato Guía de Aprendizaje 1. Identificación de La Guía de AprendizajeDokument24 SeitenProceso Dirección de Formación Profesional Integral Formato Guía de Aprendizaje 1. Identificación de La Guía de AprendizajeAlejandra OlayaNoch keine Bewertungen

- dATOS ARRANCADORES SUAVESDokument8 SeitendATOS ARRANCADORES SUAVESRobinsonContrerasMNoch keine Bewertungen

- Tipos de Mantenimiento - MMM - NTODokument14 SeitenTipos de Mantenimiento - MMM - NTONatalia Tavera OrozcoNoch keine Bewertungen

- Teoria PolinomioDokument14 SeitenTeoria PolinomioCristian SulcaNoch keine Bewertungen

- FacturaDokument6 SeitenFacturaAMPARO INOA SERVICE SRLNoch keine Bewertungen

- Dibuje Un Diagrama en El Que Se Muestre Un Banco Formado Por Dos Resistencias Que Este en Serie Como Ejemplo de Su ExplicaciónDokument2 SeitenDibuje Un Diagrama en El Que Se Muestre Un Banco Formado Por Dos Resistencias Que Este en Serie Como Ejemplo de Su ExplicaciónMisael CruzNoch keine Bewertungen

- 200427-Programa Analitico Cad400Dokument8 Seiten200427-Programa Analitico Cad400Alexander Muriel HilariNoch keine Bewertungen

- ( ( (M 4n 6) - (2m 3n 8) ) 3) (10) - Calculadora de Álgebra - SymbolabDokument2 Seiten( ( (M 4n 6) - (2m 3n 8) ) 3) (10) - Calculadora de Álgebra - Symbolabmarcos castroNoch keine Bewertungen

- El Sistema Diédrico (Complejo)Dokument170 SeitenEl Sistema Diédrico (Complejo)sinparticoNoch keine Bewertungen

- Marketing Digital Aplicado - Capítulo 7Dokument16 SeitenMarketing Digital Aplicado - Capítulo 7Smart B ConnectNoch keine Bewertungen

- Qué Son Las 5s (Y Las Otras 4s)Dokument5 SeitenQué Son Las 5s (Y Las Otras 4s)iqrjtpNoch keine Bewertungen

- TELECOMUNICACIONESDokument178 SeitenTELECOMUNICACIONESyoriam67% (3)

- 1-b Presentación Subsistema de Antenas Venesat-1-Diplomado FabricaDokument52 Seiten1-b Presentación Subsistema de Antenas Venesat-1-Diplomado FabricapedroNoch keine Bewertungen

- Introduccion A RAPIDDokument60 SeitenIntroduccion A RAPIDRafael Ricardo Beltrán López100% (1)

- SRWE - Module - 1 (Resúmen)Dokument51 SeitenSRWE - Module - 1 (Resúmen)Yorvin MendezNoch keine Bewertungen

- RadicacionDokument2 SeitenRadicacionRobertoManuelLeccaRojasNoch keine Bewertungen

- Taller Electrónica DigitalDokument53 SeitenTaller Electrónica Digitalcsantos712100% (1)

- Potenciación y Radicación - Ecuaciones y Funciones ExponencialesDokument9 SeitenPotenciación y Radicación - Ecuaciones y Funciones ExponencialesJudith AguilarNoch keine Bewertungen

- City Safety VoloDokument2 SeitenCity Safety VoloSadam A.A.P.Noch keine Bewertungen

- Cisa2011 - ResumidoDokument11 SeitenCisa2011 - ResumidoNando YorshNoch keine Bewertungen

- Redes SocialesDokument3 SeitenRedes SocialesNoé Hernández SagastumeNoch keine Bewertungen

- 281 360Dokument80 Seiten281 360Jorge Ignacio MVNoch keine Bewertungen

- Rectificación y OrtofotogrametríaDokument20 SeitenRectificación y Ortofotogrametríapiero mendoza timanáNoch keine Bewertungen

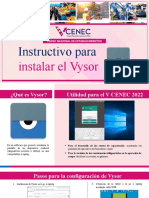

- Instructivo para Instalar El VysorDokument21 SeitenInstructivo para Instalar El VysorPaul ValdezNoch keine Bewertungen

- Plataforma TI de Vigilancia Entomológica Del Aedes AegyptiDokument19 SeitenPlataforma TI de Vigilancia Entomológica Del Aedes AegyptiIriana MoreiraNoch keine Bewertungen

- Taller 1Dokument5 SeitenTaller 1Maria Ruiz LinoNoch keine Bewertungen