Beruflich Dokumente

Kultur Dokumente

Fiche Ao 101

Hochgeladen von

صبرين النصريOriginaltitel

Copyright

Verfügbare Formate

Dieses Dokument teilen

Dokument teilen oder einbetten

Stufen Sie dieses Dokument als nützlich ein?

Sind diese Inhalte unangemessen?

Dieses Dokument meldenCopyright:

Verfügbare Formate

Fiche Ao 101

Hochgeladen von

صبرين النصريCopyright:

Verfügbare Formate

Optimisation quadratique

Table des matires

1 Existence et unicit dun minimum 1

1.1 Notations . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1

1.2 Problme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1

1.3 Existence . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1

1.4 Convexit et unicit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1

1.4.1 Projection sur un convexe ferm . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2

1.4.2 Proprit des fonctions convexes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2

2 Conditions doptimalit 3

2.1 Cas gnral . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

2.2 Cas convexe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

2.3 Contraintes dgalit afnes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

2.4 Le lagrangien . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

2.5 Fonctionnelle quadratique et contraintes dgalit afnes . . . . . . . . . . . . . . . . . . . . . . . . 4

2.6 Contraintes dingalit afnes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5

3 Algorithmes pour problmes sans contraintes, fonctionnelle quadratique 5

3.1 Taux et vitesse de convergence . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

3.2 Mthode de descente . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

3.2.1 Pas optimal fonctionnelle quadratique . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

3.2.2 Relaxation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

3.2.3 Gradient pas xe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

3.2.4 Mthode du gradient pas optimal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

3.2.5 Gradient conjugu . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

3.2.6 Mthodes itratives . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

4 Algorithme pour les problmes contraints 9

4.1 Mthode du gradient projet . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

4.2 Mthode dUZAWA . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

1 Existence et unicit dun minimum

1.1 Notations

On considre E lespace vectoriel R

n

, k un sous-ensemble non vide de E et J une fonctionnelle continue dnie

sur K valeur dans R.

1.2 Problme

Trouver u K, tel que J(u) = inf

vK

J(v).

1.3 Existence

Dnition : Minimum localglobal

_

_

_

_

_

_

_

_

_

_

_

u K est un point de minimum local de J sur K si, et seulement si

>0, v K, |v u| < J(u) J(v)

u K est un minimum global de J sur K si, et seulement si

v K, J(u) J(v)

1

Dnition : Suite minimisante

_

_

_

_

_

On dit quune suite (u

k

)

kN

dlments de K est une suite minimisante si et seulement si

lim

k+

J(u

k

) = inf

vK

J(v)

Thorme : (rappel)

Si K est compact et J continue sur K, alors J atteint ses extrema.

Dnition :

_

_

_

_

_

On dit quun fonctionnelle J est inne linni si, et seulement si :

pour toute suite (u

n

)

n

K

n

, lim

n+

_

_

v

n

_

_

= + lim

n+

J(v

n

) = +

Thorme : Existence dun minimum global

Dans le cas o E = R

n

, si K est un ferm, et si J est continue et innie linni dans K, alors elle admet

un minimum global sur K. De plus, de toute suite minimisante, on peut extraire une sous-suite qui

converge vers un point de minimum.

1.4 Convexit et unicit

Dnition : Ensemble convexe

_

_

_

_

_

_

On dit quun sous-ensemble K de E est convexe si, et seulement si, pour tout couple dlments (u, v),

le segment [u, v] est inclus dans K :

(u, v) K

2

, t [0, 1], t v + (1 t)u K

Dnition : Fonctionnelle convexe

_

_

_

_

_

_

_

_

_

_

Soit J une fonctionnelle dnie sur un sous-ensemble convexe non vide K de E, valeurs dans R. On

dit que J est convexe si et seulement si :

(u, v) K

2

, u ,= v, ]0, 1[, J(u + (1 v) J(u) + (1 )J(v)

Dans le cas dune ingalit stricte, on dit que la fonctionnelle est strictement convexe.

u v u + (1 )v

J(u) + (1 )J(v)

J(u + (1 )v)

2

Proprit

Soit J une fonctionnelle convexe dnie sur un convexe non vide K :

si u et v sont deux points de minimum locaux, alors J(u) = J(v) ;

si en plus, J est strictement convexe alors u = v.

Thorme :

Soit J une fonctionnelle convexe dnie sur un convexe non vide K de E :

tout point de minimum local est un point de minimum globale ;

si de plus J est strictement convexe, le point de minimum, sil exite, est unique.

1.4.1 Projection sur un convexe ferm

Dnition :

_

_

_

_

_

Pour tout w de E, on dnit sa projection sur un convexe ferm K P

K

(w)comme llment u tel que :

|w u| = min

vK

|w v|

Proprit

Si K est un convexe ferm, alors tout lment w de E admet une projection unique P

K

(w) sur K. DE lus

lapplication w P

K

(w) est contractante.

1.4.2 Proprit des fonctions convexes

Thorme :

Soit J une fonctionnelle diffrentiable sur un sous-ensemble K convexe non vide.

Les assertions suivantes sont quivalentes :

J est convexe sur K.

(u, v) K

2

, u ,= v :

J(v) J(u) +J(u), v u.

(u, v) K

2

, u ,= v :

J(u) J(v), u v 0.

Pour la stricte convexit, on a des ingalit strictes.

Thorme : classe (

2

Soit J une fonctionnelle de E dans R de classe (

2

. Alors J est convexe si, et seulement si,

(u, d) E

2

,

_

2

J(u)d, d

_

0.

2 Conditions doptimalit

2.1 Cas gnral

3

Dnition : Cne des directions admissibles

_

_

_

Soit K un sous-ensemble non vide de E, et v un point de K. On appelle cne des directions admissibles

lensemble

K

des tangentes en v aux chemins inclus dans K et commenants en v.

Thorme :

Soient K un sous-ensemble non vide de E, u un point de K et J une fonctionnelle de K dans R. On

suppose que J est FRECHET-diffrentiable en u. Si u est un point de minimum local de J sur K, on a

ncessairement :

w

K

, J(u), w 0

Proprit

Si K = E ou si le minimum u est intrieur K alors linquation ci-dessus devient :

J(u) = 0

2.2 Cas convexe

Ici onse place dans le cas o K est convexe.

Thorme : Inquation dEuler

Soient K un sous-ensemble convexe non vide de E, u un point de K et J une fonctionnelle de K dans

R. On suppose que J est diffrentiable en u. Si u est un point de minimum local de J sur K, on a

ncessairement

v K, J(u), v u 0

Thorme : J convexe

Soient K un sous-ensemble convexe non vide de E, u un point de K et J une fonctionnelle de K dans

R. On suppose que J est convexe et diffrentiable en u. Si u est un point de minimum local de J sur

K si, et seulement si

v K, J(u), v u 0

2.3 Contraintes dgalit afnes

On suppose ici que lensemble K est dni par :

K =

_

v R

n

_

Cv = f

_

o C est une matrice p n et f un lment de R

p

(on suppose K ,= 0). On remarque que K est un convexe

non vide.

Thorme : (Karush, Kuhn et Tucker)

Soit C ,

p,n

(R) et f R

p

, K le sous-espace dni par K = |v R

n

/ Cv = f |, u un point de K et J

une fonctionnelle diffrentiable en u.

Si u est un point de minimum local de J sur K, on a ncessairement :

_

R

p

, J(u) +

t

C = 0

Cu f = 0

4

2.4 Le lagrangien

Dnition : Le lagrangien

_

_

_

_

_

_

_

_

On dnit la fonctionnelle (appele le lagrangien du systme) :

(v, ) e R

p

, '(v, u) = J(v) +

_

Cv f

_

Les lment de R

p

sont appels les multiplicateurs de LAGRANGE.

Proprit

Soit C ,

p,n

(R) et f R

p

, K le sous-espace dni par K = |v R

n

/ Cv = f |, u un point de K et J

une fonctionnelle diffrentiable en u.

Si u est un point de minimum local de J sur K, on a ncessairement :

R

p

, tel que

_

v

'(u, ) = 0

'(u, ) = 0

2.5 Fonctionnelle quadratique et contraintes dgalit afnes

La fonctionnelle est ici quadratique en v R

n

:

v R

n

, J(v) =

1

2

Av, v b, v + c

o A est une matrica symtrique de R

nn

, b un vecteur de R

n

et c R.

On considre ses variations sur lespace afne :

K =

_

v R

p

_

Cv = f

_

o C R

pn

, et f un lments de R

p

.

Daprs les thormes prcdents, on a si u est un point de minimum de J sur K :

R

p

, tel que

_

Au +

t

C = b

Cu = f

Proprit

Soit J et K dnis ci-dessus. Si u est un point de minimum de J sur K, alors il existe R

p

tel que le

couple (u, ) de R

n

R

p

soit solution du syste=me linaire :

_

A

t

C

C 0

__

u

_

=

_

b

f

_

Thorme :

Si A est symtrique positive, le vecteur u est un point de minimum de J sur K si, et seulement si,

il existe un lmet de R

p

tel que le couple (u, ) soit solution de :

_

A

t

C

C 0

__

u

_

=

_

b

f

_

Si de plus A est dnie-positive et C est surjective alors le systme linaire admet une solution

unique.

5

2.6 Contraintes dingalit afnes

Dans cette section on considre que lensemble des contraintes K est donn par :

K =

_

v E

_

Cv f

_

Thorme :

On considre K dni ci-dessus et J une fonctionnelle diffrentiable sur E dans R. Si u K est un

minimum local de J sur K alors :

R

p

, 0,

_

_

_

J(u) +

t

C = 0

i

_

Cu f

_

i

= 0

Cu f

De plus si J est convexe, alors ceci est une condition sufsante de minimalit.

3 Algorithmes pour problmes sans contraintes, fonctionnelle quadra-

tique

On tudie ici les algorithmes qui permettent de calculer numriquement la solution du problme de minimi-

sation :

Trouver u R

n

tel que J(u) = min

vR

n J(v).

Avec ici, J le fonctionnelle qui v associe J(v) =

1

2

Av, v b, v, avec A une matrice symtrique dnie-

positive de R

nn

et b un vecteur quelconque de R

n

.

Dans ce cas, la solution existe et est unique, et elle vrie le systme linaire :

Au = b

Les algorithmes suivants consistent tous choisir une condition initiale u

0

puis construire une suite (u

k

)

k1

.

Ces algorithmes doivent vrier les deux proprits suivantes :

La convergence de la suite 5u

k

) est assure quel que soit le vecteur initiale.

La convergence doit tre sufsament rapide .

3.1 Taux et vitesse de convergence

Dnition :

_

_

_

_

_

_

_

Soit |.| une norme matricielle induite. On appelle conditionnement dune matrice relle inversible

A R

nn

, relatif cette norme, la valeur dnie par :

cond(A) = |A|

_

_

A

1

_

_

Dnition :

_

_

_

_

_

Soit une mthode numrique produisant une suite ditrs (u

k

). Soit C > 0 la plus petite constante

telle que, pour tout k 0 :

_

_

u

k+1

u

_

_

C

_

_

u

k

u

_

_

. C est appel taux de convergence. On appellera

vitesse de convergence R = log C.

6

3.2 Mthode de descente

Supposons litr u

k

connu, on choisit une direction dite de descente d

k

,= 0, et un pas de descente

k

.

On construit alors litr u

k+1

par la formule :

u

k+1

= u

k

+

k

d

k

Remarque : Le choix de

k

et d

k

se fait de manire assurer que J(u

k+1

) < J(u

k

).

Principe

3.2.1 Pas optimal fonctionnelle quadratique

Dans le cas o la fonctionnelle est quadratique, on obtient une formule du pas optimal :

k

=

J(u

k

), d

k

Ad

k

, d

k

3.2.2 Relaxation

Dnition :

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

On considre une base orthonorme (e

i

)

1in

de R

n

. On choisit la suite des direction de descente

d

0

= e

1

,. . .,d

n

= e

1

,. . ., etc. et ainsi de suite. On choisit le pas optimal dni ci dessus. Lalgorithme est

alors :

Soit l 0, on choisit u

o

R

n

et une tolrance .

Pour k = nl + i 1, on prend :

d

k

= e

i

k

=

J(u

k

), d

k

Ad

k

, d

k

u

k+1

= u

k

+

k

e

i

Proprit

Si A est symtrique dnie positive alors la mthode de relaxation est convergente.

3.2.3 Gradient pas xe

Dnition :

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

Ici, on cherche la direction dans laquelle la convergence sera la plus rapide.

Soit u

0

R

n

une condition initiale, un pas xe.

Pour k N+

d

k

= J(u

k

) = b Au

k

u

k+1

= u

k

+d

k

Proprit

Si A est symtrique dnie positive, la mthode de gradient pas xe est convergente sous rserve

que :

0 < <

2

max

(A)

7

3.2.4 Mthode du gradient pas optimal

Dnition :

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

_

On procde ici comme avec la mthode du gradient pas xe, sauf que le pas

k

est ici :

k

=

J(u

k

), d

k

Ad

k

, d

k

Soit u

0

R

n

une condition initiale.

Pour k N+

d

k

= J(u

k

) = b Au

k

u

k+1

= u

k

+

k

d

k

Proprit

Si A est symtrique dnie positive, la mthode de gradient pas optimal est convergente.

3.2.5 Gradient conjugu

Le principe de la mthode du gradient conjugu est de construire une suite de direction de descente que lon

garde en mmoire, pour essayer dviter les retours.

Si u

1

, . . . , u

k

ont dj t calculs, et si tous les gradients g

l

= J(u

l

), on recherche u

k+1

tel que :

J(u

k+1

) = min

vu

k

+G

k

J(v) avec G

k

= Vect(g

0

, . . . , g

k

)

On a :

g

k+1

est orthogonale G

k

, i.e l 0, k, g

k+1

, g

l

= 0

La mthode du GC converge en au plus n tapes !

(d

l

) sont conjugus par rapport A : k ,= l, Ad

k

, d

l

= 0.

Algorithme

_

_

_

_

_

_

_

_

_

_

_

_

_

_

initialisation : k = 0, on choisit u

0

, on calcul g

0

= Au

0

b et d

0

= g

0

.

tant que :

_

_

g

k

_

_

> , itrer k

Calculer

k1

=

g

k1

, d

k1

Ad

k1

, d

k1

Calculer u

k

= u

k1

k1

d

k1

Nouvelle direction : g

k

= Au

k

b puis

k

=

_

_

g

k

_

_

2

_

_

g

k1

_

_

2

et enn d

k

=

k

d

k1

g

k

.

3.2.6 Mthodes itratives

On sintresse ici des mthodes numriques de rsolution du systme linaire :

J

/

(u) = Au b = 0.

La solution de ce systme est le minimum recherch de la fonctionnelle quadratique J sur R

n

.

Principe

_

_

_

_

_

_

_

On dcompose A sous la forme A = M N avec M inversible.

Partant de u

0

R

n

, on construit (u

k

)

k

par :

Mu

k+1

= Nu

k

b i.e u

k+1

= M

1

Nu

k

M

1

b.

8

Attention : Ces mthodes ne sont intressante que si le choix de M rend le calcul de u

k+1

facile.

Proprit

Si (u

k

)

k

converge alors cest vers la solution du systme linaire Au = b.

Proprit

La suite (u

k

)

k

dnie par la mthode irative est convergente si et seulement si le rayon spectrale

(M

1

N) vrie : (M

1

N) < 1.

Si A est symtrique dnie positive et si

t

M + N est aussi dnie positive, alors

(M

1

N) < 1

On note D = diagA, E = tirang

inf

(A) et F = tirang

sup

(A).

Dnition : Mthode de Jacobi

_

_

_

_

_

_

_

_

Cette mthode consiste choisir M = D et N = E + F. On dsigne par matrice de Jacobi la matrice

= M

1

N = D

1

(E + F). Lalgorithme scrit alors :

On choisit u

0

R

n

et > 0.

Tant que

_

_

Au

k

b

_

_

> , calculer u

k+1

= u

k

+ D

1

b.

Dnition : Mthode de Gauss-Seidel

_

_

_

_

_

_

_

_

Cette mthode consiste choisir M = DE et N = F. On dsigne par matrice de Gauss-Seidel la matrice

( = M

1

N = (D E)

1

F. Lalgorithme scrit alors :

On choisit u

0

R

n

et > 0.

Tant que

_

_

Au

k

b

_

_

> , calculer u

k+1

= (u

k

+ (D E)

1

b.

Thorme :

Si A est symtrique et dnie-positive, alors la mthode de GAUSS-SEIDEL converge.

Si A est diagonale strictement dominante alors les deux mthodes convergent.

Si A est tridiagonale, alors (() = ()

2

.

4 Algorithme pour les problmes contraints

L encore nous nous intressons au problme :

Trouver u K tel que J(u) = min

vK

J(v).

o J est la fonctionnelle qui v K associe J(v) =

1

2

Av, v b, v, A ,

nn

(R) est suppose symtrique

dnie-positive, b est un vecteur quelconque de R

n

et K est un convexe ferm de R

n

.

4.1 Mthode du gradient projet

Rappel : Pour tout w R

n

, il existe une unique projection de w sur K, note P

K

(w) K, solution de :

_

_

P

K

(w) w

_

_

= min

vK

|v w| .

De plus la projection est caractrise par :

v K,

_

P

K

(w) w, P

K

(w) v

_

0

9

Proprit

Soit K un convexe ferm non vide de R

n

et > 0. u est solution du problme contraint J(u) =

min

vK

J(v) si et seulement si :

u = P

K

(u J(u)).

Algorithme

_

_

_

_

_

_

Initialisation : u

0

R

n

, un pas > 0 et une prcision >0.

Tant que :

_

_

u

k

u

k+1

_

_

> ,

u

k+1

= P

K

(u

k

J(u

k

))

Proprit

Dans les conditions voques ci-dessus et si K est non vide, si 0 < <

2

max

(A)

, alors quel que soit

u

0

R

n

, la suite (u

k

)

k

dnie par le gradient projet converge vers le minimum u.

Proprit

Si K =

n

i=1

[a

i

, b

i

], et y =

t

( y

1

, . . . , y

n

) R

n

, la projection x = P

K

( y) a pour composantes :

x

i

= min

_

max(a

i

, y

i

), b

i

_

4.2 Mthode dUZAWA

Supposons que lensemble

K =

_

v R

n

_

Cv = f

_

ou

K =

_

v R

n

_

Cv f

_

o C est une matrice p n et f R

p

.

Soit u K le minimum de la fonctionnelle J sur K. Alors il existe F tel que :

_

_

J(u) +

t

C = 0

Cu f 0

Cu f = 0

, Cu f 0, F

F est si il y a contraintes dgalit gal R

p

, si il y a contraintes dingalit gal R

+

p

.

Proprit

Soit R

p

tel que (u, ) verie le systme ci-dessus. Pour tout > 0, on a :

= P

F

(+(Cu f ))

10

Das könnte Ihnen auch gefallen

- Méthodes Numériques: Pierre-Antoine Comby (D'après Notes Du Cours de S. Capdevielle) 22 Décembre 2017Dokument20 SeitenMéthodes Numériques: Pierre-Antoine Comby (D'après Notes Du Cours de S. Capdevielle) 22 Décembre 2017svetNoch keine Bewertungen

- Proba StatDokument43 SeitenProba StatZaynabBenAbdelhadiNoch keine Bewertungen

- Courbes SurfacesDokument135 SeitenCourbes Surfacesmohamed ismael toure mohamed ismaelNoch keine Bewertungen

- M2edp PDFDokument214 SeitenM2edp PDFAnonymous 4qfK8SzqEYNoch keine Bewertungen

- LM256Dokument126 SeitenLM256Wassim BouyoucefNoch keine Bewertungen

- Monte Carlo A Guyader PDFDokument131 SeitenMonte Carlo A Guyader PDFLucas Berlinot100% (3)

- Cours Analyse 1 2022-2023Dokument68 SeitenCours Analyse 1 2022-2023AhmedNoch keine Bewertungen

- Cours de DEUG Probabilites Et StatistiquesDokument335 SeitenCours de DEUG Probabilites Et StatistiquesSyrine100% (1)

- Introduction Au Calcul Des ProbabilitésDokument219 SeitenIntroduction Au Calcul Des ProbabilitésIbrahima Samoura100% (1)

- Cours de Probabilit 2 Me Anne LDokument89 SeitenCours de Probabilit 2 Me Anne LJonathan wawehNoch keine Bewertungen

- Mat 142Dokument49 SeitenMat 142Duchel Amayana ayangmaNoch keine Bewertungen

- Poly ProbaDokument73 SeitenPoly Probazeineb elghoulNoch keine Bewertungen

- M2 EdpDokument272 SeitenM2 EdpLet us DanceNoch keine Bewertungen

- Cours AnalyseDokument70 SeitenCours AnalyseMaria Jose de las mercedes Costa Azul100% (1)

- Insa Energetique + RDM PDFDokument20 SeitenInsa Energetique + RDM PDFmathx342908Noch keine Bewertungen

- Cours Topol Ogie en SamDokument124 SeitenCours Topol Ogie en SamAYA ACHIRNoch keine Bewertungen

- Resume M1 Proba 2018Dokument41 SeitenResume M1 Proba 2018ismail elfaykNoch keine Bewertungen

- Probab I LiteDokument30 SeitenProbab I LiteCorey ButlerNoch keine Bewertungen

- Probabilites Et Simulation AleatoireDokument173 SeitenProbabilites Et Simulation Aleatoireapi-3737025Noch keine Bewertungen

- SLC OursDokument173 SeitenSLC Oursأيمن أيمنNoch keine Bewertungen

- 1-Poly Rappels de Proba M1 Sep 2022Dokument28 Seiten1-Poly Rappels de Proba M1 Sep 2022Quang Dũng ĐinhNoch keine Bewertungen

- Polycopié Proba Stat 1ère PharmDokument243 SeitenPolycopié Proba Stat 1ère PharmKarimaNoch keine Bewertungen

- SI227 Etats V6Dokument44 SeitenSI227 Etats V6ismailNoch keine Bewertungen

- Analyse s1Dokument61 SeitenAnalyse s1Youcef KhadirNoch keine Bewertungen

- Ouvrir Semaine1Dokument41 SeitenOuvrir Semaine1francemoungaNoch keine Bewertungen

- Poly MMC 08 2010Dokument42 SeitenPoly MMC 08 2010Ben Habib BambaNoch keine Bewertungen

- Elements Analyse 2021 2022 ISJ Semestre 2Dokument62 SeitenElements Analyse 2021 2022 ISJ Semestre 2koagne ryanNoch keine Bewertungen

- 3 - Espace Préhilbertien Réel Et Espace EuclidienDokument57 Seiten3 - Espace Préhilbertien Réel Et Espace Euclidiensk6qkj5Noch keine Bewertungen

- CoursDokument88 SeitenCoursMeryem NajiNoch keine Bewertungen

- MMC - Mécaniques Des Milieux Continus: SommaireDokument16 SeitenMMC - Mécaniques Des Milieux Continus: SommaireazzamNoch keine Bewertungen

- Cours FLODokument65 SeitenCours FLOFares TounsiNoch keine Bewertungen

- Cours Probas L3 Sylvie MeleardDokument170 SeitenCours Probas L3 Sylvie MeleardInoxideNoch keine Bewertungen

- Monte CarloDokument88 SeitenMonte CarloNaima HassouneNoch keine Bewertungen

- Cours FC PDFDokument127 SeitenCours FC PDFBrahim Karim MohamedNoch keine Bewertungen

- StatistiquesDokument52 SeitenStatistiquesbiblio mNoch keine Bewertungen

- Pr. Ayoub Azzayani - Cours S1 EcogrC-D - 9-11-2020 - CopieDokument41 SeitenPr. Ayoub Azzayani - Cours S1 EcogrC-D - 9-11-2020 - CopieRachid Ait ben assilaNoch keine Bewertungen

- Cours Probastat 2023Dokument57 SeitenCours Probastat 2023Lao LavodiNoch keine Bewertungen

- Cours Alg 1e AnnéDokument24 SeitenCours Alg 1e Annéflashmines7Noch keine Bewertungen

- Chapitre1 - Cours - Analyse1 - API - ENSA CP1Dokument22 SeitenChapitre1 - Cours - Analyse1 - API - ENSA CP1younesbzize0Noch keine Bewertungen

- E Fini Important PDFDokument256 SeitenE Fini Important PDFMarouane Samadi100% (1)

- Poly Cours Miage 2011 2012 Version 02 WebDokument85 SeitenPoly Cours Miage 2011 2012 Version 02 WebHermann Akouete AkueNoch keine Bewertungen

- Universit e Aix Marseille 1 Master de Math Ematiques Analyse Num Erique Des Equations Aux D Eriv Ees PartiellesDokument237 SeitenUniversit e Aix Marseille 1 Master de Math Ematiques Analyse Num Erique Des Equations Aux D Eriv Ees PartiellesLeila Anedp100% (1)

- Mainoptimisation PDFDokument113 SeitenMainoptimisation PDFhidou2013Noch keine Bewertungen

- Math 1er Cour - 8 PDFDokument12 SeitenMath 1er Cour - 8 PDFsoufiane soufNoch keine Bewertungen

- Analyse L2Dokument52 SeitenAnalyse L2Farel NgouasNoch keine Bewertungen

- Coursalgebre PDFDokument44 SeitenCoursalgebre PDFGeorges Keynes LorentzNoch keine Bewertungen

- Anedp PDFDokument245 SeitenAnedp PDFMohamed AmineNoch keine Bewertungen

- ConvexiteDokument53 SeitenConvexiteAzer TyuiopNoch keine Bewertungen

- Cours de Mécanique QuantiqueDokument73 SeitenCours de Mécanique Quantiquepablo uribeNoch keine Bewertungen

- Mathématiques en Tle F & BT Notes de CoursDokument48 SeitenMathématiques en Tle F & BT Notes de CoursMaitre beniNoch keine Bewertungen

- FPR L3Dokument58 SeitenFPR L3raphNoch keine Bewertungen

- Géométrie Pour Le CAPES de MathématiquesDokument85 SeitenGéométrie Pour Le CAPES de MathématiquespmellerNoch keine Bewertungen

- Poly AlgoDokument159 SeitenPoly AlgomaherhamdiNoch keine Bewertungen

- Traité d'économétrie financière: Modélisation financièreVon EverandTraité d'économétrie financière: Modélisation financièreNoch keine Bewertungen

- Objectifs LPIC 201 2009-2Dokument12 SeitenObjectifs LPIC 201 2009-2صبرين النصري100% (1)

- 4-Les JSP JavaDokument29 Seiten4-Les JSP Javaصبرين النصريNoch keine Bewertungen

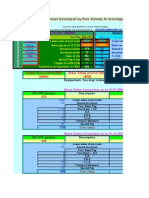

- 6th Central Pay Commission Salary CalculatorDokument15 Seiten6th Central Pay Commission Salary Calculatorrakhonde100% (436)

- Ingenieur en InformatiqueDokument54 SeitenIngenieur en Informatiqueصبرين النصريNoch keine Bewertungen

- CFPSousse FRDokument1 SeiteCFPSousse FRصبرين النصريNoch keine Bewertungen

- 158 - 170 DécantationDokument14 Seiten158 - 170 DécantationZe Lotfi100% (2)

- Fonction Ordonnancement - 2014 - EtudDokument26 SeitenFonction Ordonnancement - 2014 - Etudnguele lionnelNoch keine Bewertungen

- La TaxationDokument21 SeitenLa TaxationfathimohamedNoch keine Bewertungen

- Bac S 2012 Prob AbilitesDokument163 SeitenBac S 2012 Prob AbilitesDohan Saadane100% (1)

- L'essentiel Pour La PediatrieDokument83 SeitenL'essentiel Pour La Pediatrien7gy6wkv9rNoch keine Bewertungen

- NOMBREENTIERDokument1 SeiteNOMBREENTIERIMANNoch keine Bewertungen

- Cours Bases Dirrigation COMPLETDokument109 SeitenCours Bases Dirrigation COMPLETHouyem Guebli100% (2)

- Introduction GeneralDokument5 SeitenIntroduction GeneralJaweb WebNoch keine Bewertungen

- La Vie Au MexiqueDokument7 SeitenLa Vie Au Mexiquerodrigoguadiana790Noch keine Bewertungen

- Societe DolusDokument3 SeitenSociete Doluslm10 MedNoch keine Bewertungen

- CAF TV Services - Schedule 1, Appendix A - Host Broadcast Requirements - AFCONDokument15 SeitenCAF TV Services - Schedule 1, Appendix A - Host Broadcast Requirements - AFCONZEBOUA100% (1)

- Examen Developpement Mobile.4IIR - BOUSMAHDokument8 SeitenExamen Developpement Mobile.4IIR - BOUSMAHberylmerikhNoch keine Bewertungen

- Une Lettre AmicaleDokument1 SeiteUne Lettre AmicaleMiguel Nuñez Morales0% (1)

- Chapitre 3Dokument36 SeitenChapitre 3Othmane MoubarikNoch keine Bewertungen

- CCP Tsi 2008 Physique EnonceDokument11 SeitenCCP Tsi 2008 Physique EnonceAbdelhadi OfficielNoch keine Bewertungen

- Brochure Hiver 2009Dokument52 SeitenBrochure Hiver 2009bogdan@sepoarta.roNoch keine Bewertungen

- Cours Math - Dérivabilité - Bac Math MR Dhaouadi Nejib WWW - Sigmaths.co - CCDokument10 SeitenCours Math - Dérivabilité - Bac Math MR Dhaouadi Nejib WWW - Sigmaths.co - CCRochdi Bouzaien100% (1)

- Chapitre 5 PH Des Solutions AqueusesDokument16 SeitenChapitre 5 PH Des Solutions AqueusesSyryne DridiNoch keine Bewertungen

- T - 22 - Géométrie Vectorielle - BisDokument10 SeitenT - 22 - Géométrie Vectorielle - BisidNoch keine Bewertungen

- TD 2 Résolution GraphiqueDokument2 SeitenTD 2 Résolution GraphiquezinebNoch keine Bewertungen

- TC PhaserDokument27 SeitenTC PhaserPierre DupontNoch keine Bewertungen

- DM MDS2 - BAIBA RahelDokument4 SeitenDM MDS2 - BAIBA RahelRahel BANoch keine Bewertungen

- Barthes Sur RacineDokument161 SeitenBarthes Sur Racineplume1978100% (2)

- FinallDokument56 SeitenFinallRaphaëlNoch keine Bewertungen

- TH6310Dokument201 SeitenTH6310Zoubida HerrougTvNoch keine Bewertungen

- Bac S 2011 - Les Sujets Probables en MathématiquesDokument4 SeitenBac S 2011 - Les Sujets Probables en MathématiquesMehdi ChamekhNoch keine Bewertungen

- Pfe Stage Anass Benaziz Master INDUSAHADokument74 SeitenPfe Stage Anass Benaziz Master INDUSAHASaadia JamalNoch keine Bewertungen

- Distinction Entre Éthique Et DéontologieDokument3 SeitenDistinction Entre Éthique Et DéontologieSabrina DjebbarNoch keine Bewertungen

- DR Verin HydrauliqueDokument13 SeitenDR Verin HydrauliquefatihamNoch keine Bewertungen

- Représentation Du Schéma D'assainissement U1Dokument3 SeitenReprésentation Du Schéma D'assainissement U1Isaac KandaNoch keine Bewertungen