Beruflich Dokumente

Kultur Dokumente

Les Réseaux de Neurones Et Leurs Applications

Hochgeladen von

Ali DaoudiOriginaltitel

Copyright

Verfügbare Formate

Dieses Dokument teilen

Dokument teilen oder einbetten

Stufen Sie dieses Dokument als nützlich ein?

Sind diese Inhalte unangemessen?

Dieses Dokument meldenCopyright:

Verfügbare Formate

Les Réseaux de Neurones Et Leurs Applications

Hochgeladen von

Ali DaoudiCopyright:

Verfügbare Formate

1

Rseaux neuronaux et applications

Richard Lepage

M.Sc.A ingnierie

Dpartement dinformatique, de

mathmatiques et de gnie.

Universit du Qubec Rimouski

@2007

2

Les Sujets de discussion

Historique et concepts .

Types de rseau (MLP, RBF, Kohonen).

Les champs dapplications.

Avenir des rseaux de neurones artificielles

Conclusion.

3

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

Naissance du modle thorique (mathmatique et informatique) du

neurone biologique labor par 2 neuro-biologistes (McCulloch et

Pitts, 1943).

Schmatisation dun

neurone biologique.

Schmatisation

dun neurone

formel servant de

modle biologique

4

Neurone formel (automate seuil avec entres et sorties binaires).

A B S

0 0 0

0 1 1

1 0 1

1 1 1

OU logique

S=0

S=1

A B S

0 0 0

0 1 0

1 0 0

1 1 1

ET logique

S=0

S=1

=

+ + = =

n

i

i i

x w x w x w x w Y

0

2 2 1 1 0 0

) sgn(S

1

1 = Y

0 = Y

b mx y

w

w

x

w

w

y + =

= ou

2

0

2

1

Le neurone formel

Sapparente la mthode

du discriminant linaire.

La mise jour des poids

seffectue manuellement.

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

Le Biais permet

de jouer sur

lordonne de la

droite de

sparation

35 . 0

1

= w

35 . 0

2

= w

1

x

2

x

Y ) sgn(S

=

n

i

i i

x w

1

1

0

= x

3 .

0

= w

35 . 0

1

= w

35 . 0

2

= w

1

x

2

x

Y ) sgn(S

=

n

i

i i

x w

1

1

0

= x

5 .

0

= w

Biais

0 ) , (

0 2 2 1 1

= + + = + + = w x w x w c by ax y x d

Poids

5

Rgles du Perceptron

En 1949, dcouverte de la rgle dapprentissage de Hebb pour la mise jour

des poids dun rseau de neurones.

Dveloppement de lalgorithme du perceptron qui permet la mise jour des

poids selon la sortie dsire d(i) durant le processus dapprentissage.

tape 1 Choisir des valeurs alatoires pour les poids et le biais

tape 2 Appliquer le vecteur dentre x(i)

tape 3 -Calculer la valeur de S ()

tape 4 Si S= d(i) on retourne ltape 2 sinon on continue

ltape 5

tape 5 -

tape 6 - Retourner ltape 2.

n

w w w .. ,

2 1

0

w

0 2 2 1 1

... w x w x w S + + + =

) ( ) ( dw ), (

i 0

i d i x i d dw = = n i dw w w .. 1 pour dw w w ,

i i i 0 0 0

= + = + =

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

6

Mise jour des poids de

la couche linaire par la

rgle de Hebb

1 . 0

1

= w

2

2

= w

1

x

2

x

Y

) sgn(S

1

0

= x

3 .

0

= w

) (i d

-

err

) (i d

1 . 0

1

=

n

w

2 =

n

w

1 n

x

n

x

Y

) sgn(S

1

0

= x

3 .

0

= w

-

err

Rosenblatt entraina une

couche linaire de neurones

formels soumis la rgle

dapprentissage de Hebb

Entres

Entres

Sortie dsire

Sortie dsire

Modification des

biais et des

poids du rseau

selon lerreur

entre la sortie

dsire et la

sortie du rseau

Le perceptron de Rosenblatt (1958).

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

Le but premier du

perceptron est la

modlisation de la

perception visuelle.

7

Problme non linairement

sparable

En 1970, Minsky et Papert valurent les

faiblesses du Perceptron.

impossibilit pour le Perceptron de

rsoudre un problme qui nest pas

linairement sparable.

Minsky et Papert prconisrent dajouter

des couches de neurones entre lentre et

la sortie mais il restait trouver une

procdure qui ntait pas connu pour mettre

jour les poids et les biais du rseau.

A B S

0 0 0

0 1 1

1 0 1

1 1 0

XOR logique

S=1

S=1

S=0

S=0

La droite de

discrimination linaire

ne peut sparer les

deux classes peut

importe les valeurs

des poids et du biais

1 . 0

1

= w

2

2

= w

1

x

2

x

Y

) sgn(S

1

0

= x

3 .

0

= w

) (i d

-

err

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

8

volution du rseau multi-couche

En 1980, rvolution du Perceptron couches multiples (MLP) avec la rgle de

rtropropagation du gradient de lerreur (back-propagation).

x y =

Couche de sortie Couche cache Couche d'entre

x1

x2

x3

x4

w

ji

w

kj

y1

y2

y3

z1

z2

zk

Fonctions dactivations

( )

j k k j

y ) ( ' z - t y

k k kj

net f w q o q = = A

Couche cache vers la couche de sortie

Couche dentre vers la couche cache

i

c

1 k

i

x ) ( ' x

j k kj j ji

net f w w

(

= = A

=

o q o q

Cette dcouverte revient deux quipes indpendantes:

Gnralisation de lalgorithme de

Widrow et Hoff ou rgle delta en

minimisant la somme des erreurs

quadratiques.

Rumelhart et all et Le Cun et all

x y =

x

e

y

+

=

1

1

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

9

Rsolution dun problme non linairement sparable avec le rseau MLP

A B S

0 0 0

0 1 1

1 0 1

1 1 0

XOR logique

D1

S=1

S=1

S=0

S=0

D2

y

2

o

x

1

x

2

y

1

1

1 , 1

w

2

1 , 1

w

2

2 , 1

w

1

1 , 2

w

1

1 , 2

w

Le rseau MLP permet de

sparer les deux classes

du problme XOR. Noeuds dentre

Noeuds cachs

Noeuds de sortie

Branchements

Couche 0

Couche 1

Couche N

Couche N-1

Rseau N-couches

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

10

Configuration optimale du rseau de neurone (MLP)

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

Un des gros problmes qui apparait dans lutilisation des

rseaux de neurones est la difficult du choix dans le nombre

de couche et le nombre de neurone par couche.

Le pas dapprentissage

La vitesse dapprentissage

La capacit de gnralisation du rseau

Les fonctions dactivations des couches caches

Paramtres prendre en considration

Comment y remdier?

Mthode essai et erreur

La mthode des plans dexpriences (taguchi)

Optimisation conjointe des paramtres et de la topologie du

rseau par algorithme gntique hirarchiques.

Utilisation de lensemble de Pareto optimal (Vilfredo Pareto )

11

Avantages:

Le rseau atteint une prcision trs leve au niveau de la reconnaissance

et la base dexemple na pas besoin dtre trs grande.

Dsavantage:

On perd en gnralit car les formes sont reconnues dune manire trop

exacte. Si une forme proche est prsente au rseau, celle-ci ne sera peut-

tre pas reconnue. On peut ajouter un bruit blanc au donnes pour permettre

une meilleure gnralisation.

Techniques dapprentissage ou de dtermination des poids

Apprentissage supervis (Approche dterministe)

On enseigne au rseau ce quil doit prsenter comme information la sortie

selon les donnes prsentes lentre. Cela force les poids prendre des

valeurs distinctes selon les formes prsentes au rseau de neurones.

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

12

Le rseau regroupe les donnes selon des algorithmes de calcul de distance

par la mthode des moindres carres. chaque groupe correspond une

classe. Aprs lidentification de toutes les classes, une valeur de sortie,

dicte par lusager, est associe chacune des classes. Peut-tre associ

une infrence baysienne pour produire des probabilits conditionnelles pour

chaque variable alatoire tant donn les autres.

Avantages:

Le rseau atteint une prcision trs leve au niveau de la reconnaissance

et la gnralisation est trs bonne.

Dsavantage:

La base dexemples se doit dtre trs volumineuse et le temps

dapprentissage est trs long si un nouvel exemple est prsent au rseau

pour un nouvel apprentissage.

Techniques dapprentissage ou de dtermination des poids

Apprentissage non supervis (approche statistique)

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

13

Mthode de minimisation pour le calcul des poids.

) (

) (

2

1

,

2

,

n

j

n

j

n

j

n

j

n

i

n

j

n

j

n

i j

n

i j

h f

x h f

w

w

' A =

c

c

= A

' A =

c

c

= A

o

u

c

o u

o

c

o

Mthode de descente du Gradient

Mise jour des poids et des biais

n

j

n

j

n

j

n

i j

n

i j

n

i j

old new

w old w new w

u u u A + =

A + =

) ( ) (

) ( ) (

, , ,

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

14

Mthode de minimisation pour le calcul des poids.

( )

j k k j

y ) ( ' z - t y

k k kj

net f w q o q = = A

Mthode de descente du Gradient avec terme dinertie

) ( ) (

2

old w

w

new w A +

c

c

= A |

c

o

0< | <1

Terme dinertie

w

w

c

c

~ A

2

1

c

|

o

Aw convergera vers

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

15

Mthode de minimisation pour le calcul des poids.

Mthode de Newton

+ + V + = H w w w E w w w E w E

2

0 0 0 0

) (

2

1

) ( ) ( ) ( ) (

Par lutilisation de la srie de Taylor

j i

ij

w w

E

H

c c

c

=

2

o H = matrice Hessienne E = fonction derreur (c

2

)

De la srie de Taylor, nous obtenons

+ + V = V ) ( ) ( ) (

0 0

w w H w E w E

o

) (

0

1

0

w E H w w V =

( Mthode de Newton)

( )

=

= =

N

i

i ij j j j

x w Y d Y w E

1

o

2

1

) (

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

16

Avantages:

w Convergence rapide (forme quadratique)

Dsavantages:

wCalcul intensif (ncessit de calculer la matrice inverse

chaque pas ditration.

wLa matrice Hessienne est difficile calculer selon la

complexit de la fonction dactivation. Nous devons choisir

une fonction dactivation qui est continuement drivable.

Mthode de minimisation pour le calcul des poids.

Mise jour des poids par la mthode de Newton

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

17

Avantages:

wConvergence trs rapide et gnralisation trs bonne.

wMthode la plus utilise jusqu maintenant.

Dsavantages:

Il ne faut pas que le nombre de poids constituant le rseau soit plus

grand que 200 car cette mthode devient infficace en terme de

rapidit de calcul.

Mthode de minimisation pour le calcul des poids.

Mthode Levenberg-Marquardt Backpropagation

1

) (

) (

) ( ) (

+ = A

=

=

JE I JJ w

E w J JE

w J w J JJ

o J = Matrice Jacobienne

E = Toutes les erreurs

I = Matrice identit

= Taux dapprentissage

HISTORIQUE ET CONCEPT DES RSEAUX NEURONAUX

18

TYPES DE RSEAU (MLP, RBF, KOHONEN).

MLP Multilayer perceptron (perceptron multi-couches)

Rseau vu prcdemment.

RBF Radial Basis Function (Fonction dactivation gaussienne)

Approximation de fonctions plusieurs variables.

Rseau de Kohonen (Rseau auto-organisateur)

Conservation topologique de la forme

Compression de donnes

Rseau de Hopfield (Rseau pleine connection) non prsent dans cette

prsentation

Nouvelles tendances:

Combinaison de plusieurs types de rseaux pour des problmes spcifiques

Rseau de Kohonen Rseau MLP Entre

Sortie

19

Le rseau RBF (Radial Basis Function)

TYPES DE RSEAU (MLP, RBF, KOHONEN).

Broomhead et Lowe (1988) employrent pour la premire fois le rseau RBF.

Sert actuellement pour les applications dapproximation de fonction mais

sexplique mieux dans le contexte de la classification.

Structure du rseau RBF

x

2

x

1

La couche cache est constitue

de fonction-noyau de type gaussienne.

Paramtrisation ncessaire

de la fonction noyau.

sortie linaire

Entres

Le rseau RBF est un

rseau trois couches

(Couche dentre, couche

RBF, couche de sortie

linaire).

La rgle Delta est utilise comme

technique dapprentissage. Il faut

choisir le bon nombre de neurone

pour la couche RBF.

20

Le rseau RBF (Radial Basis Function)

TYPES DE RSEAU (MLP, RBF, KOHONEN).

Pour dterminer le nombre et la position des neurones-noyau, on utilise

lalgorithme dcrit par Mustawi et all (1992).

1. On associe un neurone par donne du corpus dapprentissage

reprsentant un nuage distinct, le but tant de regrouper des nuages de

donnes.

2. Choisir alatoirement un nuage (un neurone i)

3. Trouver un second nuage de la mme classe (un neurone j).

4. Regroupement des deux nuages en un nouveau nuage k et calculer

barycentre C

k

.

5. Calculer la distance r

k

entre C

k

et la donne de k la plus loigne.

6. Calculer la distance dk entre Ck et le barycentre du nuage le plus

proche.

7. Si dk > Delta*rk, alors regroupement accept et nouveau nuage k

remplace nuage i et j, sinon rpt depuis ltape 3 jusqu ce que le

regroupement soit accept.

8. Rpter lopration partir de 2, en examinant tous les nuages jusqu

ce quaucun regroupement ne soit plus possible.

21

Le rseau RBF (Radial Basis Function) dans lapproximation dune fonction

TYPES DE RSEAU (MLP, RBF, KOHONEN).

Vecteurs dapprentissage

Fonction gaussienne

Somme pondre des entres

Rsultat aprs apprentissage

On prsente 20 vecteurs

que le rseau doit

apprendre (x,y). Une fois

lapprentissage termin,

nimporte laquelle des

valeurs prsentes

lentre donnera une

valeur de sortie qui sera

prsente sur la courbe.

22

Le rseau SOM de Kohonen (rseau comptitif)

TYPES DE RSEAU (MLP, RBF, KOHONEN).

Kohonen (1990) dveloppa la carte topologique (Self-Organizing Map).

Le rseau apprentissage

comptitif de Kohonen

(spcialisation du neurone )

sapproche le plus du type

de structure observ dans le

cerveau.

Le rseau SOM est constitu dune couche dentre et dune couche de comptition en

sortie.

1 , 1

w

1

e

1 , 2

w

2 , 1

w

2 , 2

w

2

e

1

i

2

i

Couche

dentre

Couche de

comptition

Poids

du

rseau

I1 I2

W1 0.6 0.4

W2 0.4 0.6

Patron 1 1.0 0.0

Patron 2 0.8 0.2

Patron 3 0.0 1.0

Patron 4 0.2 0.8

La rgle dapprentissage

modifie les poids du

neurone 1 de faon le

rapprocher du patron

prsent.

Le rseau SOM est parfaitement adapt dans lanalyse des donnes (regroupement

sous forme de nuage de donnes).

23

Le rseau SOM de Kohonen (rseau comptitif)

TYPES DE RSEAU (MLP, RBF, KOHONEN).

100 points de donnes crs sur

un cercle unitaire

1 , 1

w

1

e

1 , 2

w

2 , 1

w

2 , 2

w

2

e

x

y

9

e

10

e

2 entre et 10 neurones dans la

couche comptitive

Les vecteurs poids suivent la courbe

de donnes aprs apprentissage.

Le graphique reprsentant les poids de chaque neurone suivent la

courbe de donnes en positionnant les poids de chacun des

neurones au barycentre des nuages de donnes qui ont t cr.

24

APPLICATIONS DES RSEAUX NEURONAUX

Classification de donnes vectorielles

Reconnaissance de formes

Approximation de fonctions

Dtection de patrons dans un signal

Prdiction future selon des donnes passs

Contrle robotique (PID)

Compression de donnes

rgression linaire et non-linaire

25

Classification par rseau MLP.

-3 -2 -1 0 1 2 3

-3

-2

-1

0

1

2

Class 1

Class 0

x = randn([2 200]);

o = (x(1,:).^2+x(2,:).^2) < 1;

Commande Matlab : Cration des donnes dapprentissage

Les composantes x

1

et x

2

sont gnres

partir de nombres alatoires.

Sortie dsire o:

Si (x

1

,x

2

) est dans un cercle

de rayon 1 centr lorigine

Alors

o = 1

Sinon

o = 0

APPLICATIONS DES RSEAUX NEURONAUX

26

PR = [min(x(1,:)) max(x(1,:));

min(x(2,:)) max(x(2,:))];

S1 = 10;

S2 = 1;

TF1 = 'logsig';

TF2 = 'logsig';

BTF = 'traingd';

BLF = 'learngd';

PF = 'mse';

net = newff(PR,[S1 S2],{TF1

TF2},BTF,BLF,PF);

Commande Matlab : Cration dun rseau deux couches

Bornes de chacune des entres

Nbr. de noeuds dans la couche 1 et 2

Fonction dactivation de la couche 1 et 2

Fonction dentrainement

Fonction dapprentissage

Fonction cot (mean square error ou MSE)

Commande de cration du rseau

APPLICATIONS DES RSEAUX NEURONAUX

Classification par rseau MLP.

27

net.trainParam.epochs = 2000;

net.trainParam.goal = 0.002;

net = train(net,x,o);

y = sim(net,x);

netout = y>0.5;

Nbr. dpoque de calcul

Erreur maximale dsire

Commande dapprentissage

Calcul en continue des sortie du rseau

Conversion en sortie binaire

Structure du rseau

x

2

x

1

Couche cache

(sigmoide)

Noeud de sortie (Sigmoide)

Noeuds dentre

Unit de seuil

(pour sortie binaire)

APPLICATIONS DES RSEAUX NEURONAUX

Classification par rseau MLP.

28

-3 -2 -1 0 1 2 3

-3

-2

-1

0

1

2

Class 1

Class 0

Les poids sont choisis alatoirement avant

le dbut du calcul. Affichage des droites de

sparation avant apprentissage.

APPLICATIONS DES RSEAUX NEURONAUX

Classification par rseau MLP.

Lorsque le processus dapprentissage est

termin, tout vecteur se prsentant en

entre du rseau sera reconnu comme

faisant partie de la classe o ou x.

On essaye de voir jusqu quel point les

droites de sparation peuvent encercler les

vecteurs x pour former une classe distinctes

des vecteurs o.

Trois types dalgorithme de gestion

des poids seront utiliss dans cet

exemple pour dmontrer la rapidit

de chacun deux lors du processus

dapprentissage.

29

Algorithme dapprentissage:

Descente de gradient avec terme dinertie

0 0.5 1 1.5 2

x 10

4

10

-3

10

-2

10

-1

10

0

Performance is 0.151679, Goal is 0.002

20000 Epochs

T

r

a

i n

i n

g

-

B

l u

e

G

o

a

l -

B

l a

c

k

MSE vs poques dapprentissage

Erreur de classification : 40/200

-3 -2 -1 0 1 2 3

-3

-2

-1

0

1

2

Class 1

Class 0

MSE vs poques dapprentissage

(convergence atteinte en 10 poques)

Algorithme dapprentissage:

Levenberg-Marquardt Backpropagation

0 2 4 6 8 10

10

-3

10

-2

10

-1

10

0

Performance is 0.00172594, Goal is 0.002

10 Epochs

T

r

a

i n

i n

g

-

B

l u

e

G

o

a

l -

B

l a

c

k

Erreur de classification : 0/200

-3 -2 -1 0 1 2 3

-3

-2

-1

0

1

2

Class 1

Class 0

la fin de lapprentissage, 6 noeuds seulement sont ncessaires pour classer les vecteurs x.

APPLICATIONS DES RSEAUX NEURONAUX

Classification par rseau MLP.

MSE vs poques dapprentissage

Algorithme dapprentissage:

Mthode de descente par le gradient

0 0.5 1 1.5 2

x 10

4

10

-3

10

-2

10

-1

10

0

Performance is 0.151511, Goal is 0.002

20000 Epochs

T

r

a

i n

i n

g

-

B

l u

e

G

o

a

l -

B

l a

c

k

Erreur de classification : 40/200

-3 -2 -1 0 1 2 3

-3

-2

-1

0

1

2

Class 1

Class 0

30

APPLICATIONS DES RSEAUX NEURONAUX

Reconnaissance de forme avec rseau MLP

Schmas synoptiques dun systme de reconnaissance de formes

Acquisition de limage

Prtraitement de limage

Extraction des

caractristiques

dinvariance

Cration dune base de donnes des caractristiques

invariantes (Identifier chaque image avec une classe

dappartenance)

Processus dapprentissage du rseau de neurones

(stabilisation des poids du rseau selon la base de

donnes des caractristiques).

Prsentation au rseau de

neurones pour fin

didentification (le processus

dapprentissage est ralis

au pralable).

Prsentation du rsultat

de la classification.

Choisir alatoirement selon une courbe normale

(moyenne nulle et variance unitaire) des chantillons

qui serviront lapprentissage du rseau)

On se sert des trois premier modules pour former la

base de donnes des caractristiques dimages.

31

APPLICATIONS DES RSEAUX NEURONAUX

Prtraitement des donnes images

Image originale en

couleurs

Niveau de gris Filtre Sobel

Rehaussement de

contraste

Remplissage des

vides

Linarisation de

lobjet

Segmentation de

limage

1 2 3

4 5

6

Reconnaissance de forme avec rseau MLP

32

Reconnaissance de forme avec rseau MLP

APPLICATIONS DES RSEAUX NEURONAUX

M

10

et M

01

dfinissent le

centre de gravit de la

surface et M

00

dfinit la

surface de lobjet

Moments centrs dordre p,q

Extraction des caractristiques de la forme

Moments lmentaires dordre p,q

On recherche linvariance en translation, en rotation et en homothtie en

groupant des moments centrs dordre p,q, par exemple M

20

+M

02

Axes principaux dinertie

Allongement et orientation

de la forme

33

Reconnaissance de forme avec rseau MLP

APPLICATIONS DES RSEAUX NEURONAUX

Normalisation des donnes et prsentation au

rseau MLP

La normalisation est le processus par lequel les donnes dentre et les

donnes en sortie ont des valeurs voluant entre -1 et +1.

On utilise habituellement deux couches

caches dune dizaine de neurones pour

viter le sur-apprentissage et on fait apprendre

au rseau les formes qui sont prsentes

lentre selon les paramtres caractristiques.

On peut ajouter un bruit blanc aux formes qui sont prsentes lors de

lapprentissage du rseau pour amliorer la gnralisation. On utilise un

algorithme dapprentissage de type Levenberg-Marquard qui est le plus

adquat pour le rseau MLP.

34

APPLICATIONS DES RSEAUX NEURONAUX

Reconnaissance des signaux par rseau MLP

Signal analyser Patrons de signaux

Le signal que nous voulons analyser provient dune machine usiner. Pour

viter dendommager la pice, un rseau de neurone dtecte les bris des

outils usiner (mches, fraiseuses) en reconnaissant les signaux

prcurseurs.

Signal analyser

en temps rel

Passage dune

fentre de 10

chantillons par

intervalle dun

chantillon.

Prsentation des

10 chantillons au

rseau MLP

Dcision sur la

commande de

lappareil

35

APPLICATIONS DES RSEAUX NEURONAUX

On utilise un rseau dune couche cache de 5 neurones avec fonction

dactivation logsig et un neurone en sortie avec fonction dactivation purelin.

Reconnaissance des signaux par rseau MLP

y1

y10

La mise jour des poids se

fait par lalgorithme de

Levenberg-Marquard durant

ltape dapprentissage.

Contrle de la

machine usiner

36

AVENIR DES RSEAUX NEURONAUX

Caractristiques gnrales

Technology: 0,35 CMOS

Chip size: 35 mm2

Supply voltage: 3,3 V

Clock frequency: 33 MHz

Power consumption: 0,5 W

Package type: CQFP 208

Dimensions: 30,6 mm x 30,6 mm x 4,1 mm

Processing speed at 33MHz: 45MCUPS1

Implantation sous forme de circuits intgrs dun rseau de neurone

lectronique controle universel.

Rseau de neurones circuit intgr

Le DANA23 (Digital Adaptive Neuro ASIC) contient un rseau

complet avec modification et sauvegarde des poids et biais avec un

algorithme dapprentissage intgr de type backpropagation modifi.

37

AVENIR DES RSEAUX NEURONAUX

Rseau de neurones circuit intgr

38

AVENIR DES RSEAUX NEURONAUX

Rseau de neurones biologiques sur substrat de silicium (neurochips)

Un groupe de chercheur du Caltech (institut de technologie de

Californie) ont russi la greffe dun neurone sur un substrat de silicium

en 1991.

La vision et les capacits de la mmoire neurologique excutent massivement des

oprations parallles impossibles reproduire mme sur les plus grands

superordinateurs du monde.

Conception prochaine de circuits qui

excutent des calculs analogiques

massivement parallles

La surface lisse du silicium est un

environnement idal pour la

croissance des cellules crbrales.

39

CONCLUSIONS

Les rseaux de neurones sont en constante volution et la nouvelle vogue

est de combiner diffrents rseaux pour accomplir des tche spcifiques.

Loptimisation de la configuration des rseaux de neurones est actuellement

un problme ouvert. Il existe diverses techniques mais celle qui optimise

vraiment la configuration na pas vu le jour.

Des recherches intensives sont en cours pour appliquer les rseaux SOM

(auto-organisateur) dans le secteur de lindustrie. La comprhension des

rseaux SOM permet dapprocher le comportement du cerveau humain en

liaison avec la logique floue.

Nous sommes encore loin de lpoque o un cerveau humain sera remplac

par une machine car les fonctions humaines mme les plus simple sont un

norme dfis pour la technologie.

40

Vous avez des questions???

Das könnte Ihnen auch gefallen

- Réseaux de Neurones ArtificielsDokument39 SeitenRéseaux de Neurones ArtificielsMrabtei Ayoub100% (2)

- Formation 3D par la pratique avec C#5 et WPF: Modeliser des moleculesVon EverandFormation 3D par la pratique avec C#5 et WPF: Modeliser des moleculesNoch keine Bewertungen

- Les - Reseaux - de - Neurones - Artificiels (Trés Important Projet Module)Dokument129 SeitenLes - Reseaux - de - Neurones - Artificiels (Trés Important Projet Module)Safouane Ben SaâdNoch keine Bewertungen

- Introduction Aux Reseaux de NeuronesDokument31 SeitenIntroduction Aux Reseaux de NeuronesIbrahim RanaoNoch keine Bewertungen

- Reseaux de Neurones: PerceptronDokument20 SeitenReseaux de Neurones: PerceptronAnovar_ebooks100% (1)

- Reseaux BayesiensDokument442 SeitenReseaux BayesiensEd Phénix le Prince86% (7)

- Le système d'approvisionnement en terres dans les villes d'Afrique de l'Ouest: L’exemple de BamakoVon EverandLe système d'approvisionnement en terres dans les villes d'Afrique de l'Ouest: L’exemple de BamakoNoch keine Bewertungen

- Apprentissage Artificiel - Concepts Et Algorithmes by Antoine Cornuéjols, Laurent Miclet, Jean-Paul HatonDokument834 SeitenApprentissage Artificiel - Concepts Et Algorithmes by Antoine Cornuéjols, Laurent Miclet, Jean-Paul Hatonnacer zidiNoch keine Bewertungen

- Introduction à l’analyse des données de sondage avec SPSS : Guide d’auto-apprentissageVon EverandIntroduction à l’analyse des données de sondage avec SPSS : Guide d’auto-apprentissageNoch keine Bewertungen

- Réseaux de NeuronesDokument54 SeitenRéseaux de NeuronesKhalifa BakkarNoch keine Bewertungen

- Machine Learning (FR)Dokument181 SeitenMachine Learning (FR)Vigil TestNoch keine Bewertungen

- MAITRISER Python : De l'Apprentissage aux Projets ProfessionnelsVon EverandMAITRISER Python : De l'Apprentissage aux Projets ProfessionnelsNoch keine Bewertungen

- Réseau de NeuronesDokument49 SeitenRéseau de NeuronesOualid ZaouichNoch keine Bewertungen

- Cours Intelligence ArtificielleDokument39 SeitenCours Intelligence ArtificielleYacine MokhtariNoch keine Bewertungen

- Modélisation MATEMATIQEDokument22 SeitenModélisation MATEMATIQEZaki El Alami67% (3)

- ClusteringDokument50 SeitenClusteringسارة شعيرNoch keine Bewertungen

- Une Approche Deep Learning Pour L'analyse Des Sentiments Sur TwitterDokument73 SeitenUne Approche Deep Learning Pour L'analyse Des Sentiments Sur Twitteraoudou mounchingamNoch keine Bewertungen

- 02 AlgorithmesDokument102 Seiten02 AlgorithmesWalid Yahia MahammedNoch keine Bewertungen

- MemoireDokument90 SeitenMemoireSoheib SadounNoch keine Bewertungen

- Programmation PythonDokument222 SeitenProgrammation PythonHamza Bennis100% (2)

- Aprentissage - Artificiel Concepts Et Algorithmes PDFDokument635 SeitenAprentissage - Artificiel Concepts Et Algorithmes PDFSofiene Guedri100% (1)

- Rapport RegressionDokument20 SeitenRapport RegressionrusselNoch keine Bewertungen

- Cours Reseaux de NeuronesDokument20 SeitenCours Reseaux de NeuronesPatrick Marcial Etata Mandjouk100% (1)

- Machine LearningDokument11 SeitenMachine Learningcrew playerNoch keine Bewertungen

- Réseau de Neurones ArtificielsDokument14 SeitenRéseau de Neurones ArtificielsSouhaib LoudaNoch keine Bewertungen

- TP 11Dokument8 SeitenTP 11Lemrouce EkairineNoch keine Bewertungen

- Initiation À L'analyse Statistique Des Données ExpérimentalesDokument10 SeitenInitiation À L'analyse Statistique Des Données ExpérimentalesImen ThabetNoch keine Bewertungen

- Réseaux de Neurones Artificiels By: Abdelouahid ELYAHYAOUIDokument35 SeitenRéseaux de Neurones Artificiels By: Abdelouahid ELYAHYAOUIRachid ZineNoch keine Bewertungen

- Data Scientist JobDokument32 SeitenData Scientist JobJohn RoyonNoch keine Bewertungen

- Apprentissage ArtificielDokument635 SeitenApprentissage Artificielfedalus1837100% (6)

- Chapitre3 IADokument57 SeitenChapitre3 IASamir AouniNoch keine Bewertungen

- Recuit SimuleDokument19 SeitenRecuit SimuleNour El HoudaNoch keine Bewertungen

- Rabeb Rapport PDFDokument117 SeitenRabeb Rapport PDFHelmi CheguevaraNoch keine Bewertungen

- Chapitre3 Robotique 2017Dokument45 SeitenChapitre3 Robotique 2017imene titaNoch keine Bewertungen

- Projet Machine Learning TensorDokument18 SeitenProjet Machine Learning TensorMeryame HoussamNoch keine Bewertungen

- Rapport Sur: L'application Des Réseaux NeuronauxDokument28 SeitenRapport Sur: L'application Des Réseaux NeuronauxNajlae ChtebiNoch keine Bewertungen

- Les Réseaux de Neurones - Présentation Et Applications Par Pierre Borne-Mohamed Benrejeb-Joseph HaggègeDokument35 SeitenLes Réseaux de Neurones - Présentation Et Applications Par Pierre Borne-Mohamed Benrejeb-Joseph Haggègejohn_cooper20100% (11)

- Réseaux de Neurones ArtificielsDokument19 SeitenRéseaux de Neurones ArtificielsAbdessamed Belhadj100% (1)

- Programmation Linéaire en Nombres Entiers Pour L'ordonnancement Modulo Sous Contraintes de Ressources.Dokument75 SeitenProgrammation Linéaire en Nombres Entiers Pour L'ordonnancement Modulo Sous Contraintes de Ressources.Med GasNoch keine Bewertungen

- Règles D'associationDokument35 SeitenRègles D'associationMeryem BakirNoch keine Bewertungen

- THLDokument56 SeitenTHLlicvol0% (1)

- Modélisation Stochastique Et Simulation - Cours Et Applications by Bernard Bercu and Djalil ChafaïDokument312 SeitenModélisation Stochastique Et Simulation - Cours Et Applications by Bernard Bercu and Djalil ChafaïkhabdouNoch keine Bewertungen

- Machine LearningDokument5 SeitenMachine LearningOumayma Ben YoussefNoch keine Bewertungen

- Les Reseaux de NeuronesDokument22 SeitenLes Reseaux de Neuronesariel100% (1)

- Cours Apprentissage AutomatiqueDokument138 SeitenCours Apprentissage Automatiquenawras_universNoch keine Bewertungen

- Informatique Pour GéologueDokument164 SeitenInformatique Pour GéologuemakayaboNoch keine Bewertungen

- Support Python Scientifique PDFDokument163 SeitenSupport Python Scientifique PDFAnonymous wpcDszt100% (1)

- Apprentissage Automatique - Les Réseaux de NeuronesDokument9 SeitenApprentissage Automatique - Les Réseaux de NeuronesSohib LoudadjiNoch keine Bewertungen

- Comprendre Les Files D'attenteDokument12 SeitenComprendre Les Files D'attentepierree1Noch keine Bewertungen

- Apprentissage Artificiel Ed2 v1 PDFDokument837 SeitenApprentissage Artificiel Ed2 v1 PDFMatisiSpra100% (1)

- T.P Langage AssembleurDokument6 SeitenT.P Langage Assembleurababele jacques100% (1)

- Big Data - Machine Learning PDFDokument57 SeitenBig Data - Machine Learning PDFManseriNoch keine Bewertungen

- 5-Algorithmes de TriDokument12 Seiten5-Algorithmes de TriMrhafid ÉzardouniNoch keine Bewertungen

- 2018 ChaireAgroTIC DeepLearning VD2 PDFDokument49 Seiten2018 ChaireAgroTIC DeepLearning VD2 PDFAbdou Aziz CisséNoch keine Bewertungen

- Examen National Du BTS - Maintenance Industrielle - Session de Mai 2015Dokument4 SeitenExamen National Du BTS - Maintenance Industrielle - Session de Mai 2015enjy top1Noch keine Bewertungen

- Techniques de ClimatisationDokument27 SeitenTechniques de ClimatisationMohamud Lhaf100% (1)

- Beer - Méthode de Clarinette (1891)Dokument60 SeitenBeer - Méthode de Clarinette (1891)fabri21Noch keine Bewertungen

- Travaux Dirigés - TD - ArbresDokument2 SeitenTravaux Dirigés - TD - Arbresلا إلٰه إلّا اللهNoch keine Bewertungen

- Examen1+Solution Microcontrà Leurs Et Microprocesseurs - PDF  Version 1Dokument4 SeitenExamen1+Solution Microcontrà Leurs Et Microprocesseurs - PDF  Version 1Chaima BellatNoch keine Bewertungen

- SALOMÉ Test Management FrameworkDokument101 SeitenSALOMÉ Test Management FrameworkPharell William BaldorNoch keine Bewertungen

- TD N°2 Maths 3emeDokument5 SeitenTD N°2 Maths 3emebilly kanaNoch keine Bewertungen

- Cours Probabilités (Chapitre 1 - Analyse Combinatoire)Dokument41 SeitenCours Probabilités (Chapitre 1 - Analyse Combinatoire)Khadija Dia100% (1)

- TP E P RedresseurDokument5 SeitenTP E P RedresseurRafik BouhennacheNoch keine Bewertungen

- cm2 Exercices SymetrieDokument4 Seitencm2 Exercices Symetriegjx7qcfwmyNoch keine Bewertungen

- NPS - VPN Sous Windows2012 ServerDokument19 SeitenNPS - VPN Sous Windows2012 ServerAKUENoch keine Bewertungen

- 0-Rappel Langage SQLDokument4 Seiten0-Rappel Langage SQLaminehosnyNoch keine Bewertungen

- FX808394F FlexES Control FX10 (10 Boucles)Dokument1 SeiteFX808394F FlexES Control FX10 (10 Boucles)Ramdane RamdanoNoch keine Bewertungen

- Alimentations StatiquesDokument16 SeitenAlimentations StatiquesKdr Khair-Eddine100% (1)

- QCM 5Dokument2 SeitenQCM 5HAPMRINoch keine Bewertungen

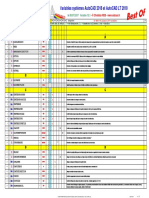

- Variables Systemes AutoCAD 2Mxx-BEST of VARIABLESDokument7 SeitenVariables Systemes AutoCAD 2Mxx-BEST of VARIABLESazeNoch keine Bewertungen

- Mem Corr AndriantavyDokument66 SeitenMem Corr AndriantavyWael TrabelsiNoch keine Bewertungen

- TP BDV 2016Dokument17 SeitenTP BDV 2016Khabtane AbdelhamidNoch keine Bewertungen

- Crabol XXIV-3Dokument2 SeitenCrabol XXIV-3Pham Van DuongNoch keine Bewertungen

- MathématiquesDokument393 SeitenMathématiquesSaido Medjout100% (1)

- MEMOIRE Samer MoussaDokument94 SeitenMEMOIRE Samer Moussatoni JabbourNoch keine Bewertungen

- Joyeux Anniversaire Tab F - Partition Et PartiesDokument2 SeitenJoyeux Anniversaire Tab F - Partition Et PartiesMartinNoch keine Bewertungen

- Pvsyst Evaluation: Pvsyst - Rapport de SimulationDokument7 SeitenPvsyst Evaluation: Pvsyst - Rapport de Simulationidriss habibiNoch keine Bewertungen

- Top Ten 50Dokument35 SeitenTop Ten 50Beppe SorboNoch keine Bewertungen

- Remerciements: Kabou Saleh Eddine Pour Sa Disponibilite A' Superviser MonDokument42 SeitenRemerciements: Kabou Saleh Eddine Pour Sa Disponibilite A' Superviser MonOMAE01Noch keine Bewertungen

- Cours AngularDokument44 SeitenCours Angularyosri grira100% (1)

- ADE - UHA 2022-2023 (Alioune-Badara-Ibn - Diene@uha - FR) - 6.6.4jDokument1 SeiteADE - UHA 2022-2023 (Alioune-Badara-Ibn - Diene@uha - FR) - 6.6.4jAlioune Badara Ibn Abu Talib DièneNoch keine Bewertungen

- Composition de 3ètrim MathsDokument2 SeitenComposition de 3ètrim Mathsnaababaongo052Noch keine Bewertungen

- PLE CoursDokument95 SeitenPLE CoursFranck-Olivier KassouNoch keine Bewertungen

- Ifr AttDokument9 SeitenIfr AttpatrouilledeafranceNoch keine Bewertungen